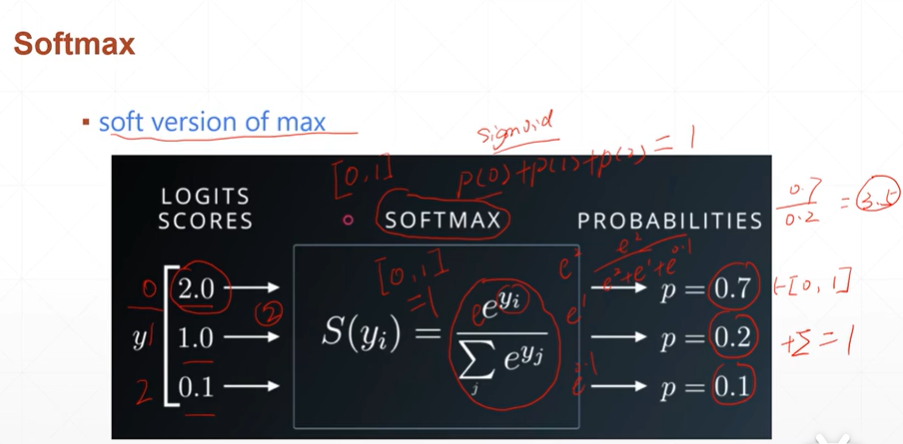

1:softmax

(1)softmax函数适用于多分类,可以将进行[0,1]之间的压缩,并且保证和为1.

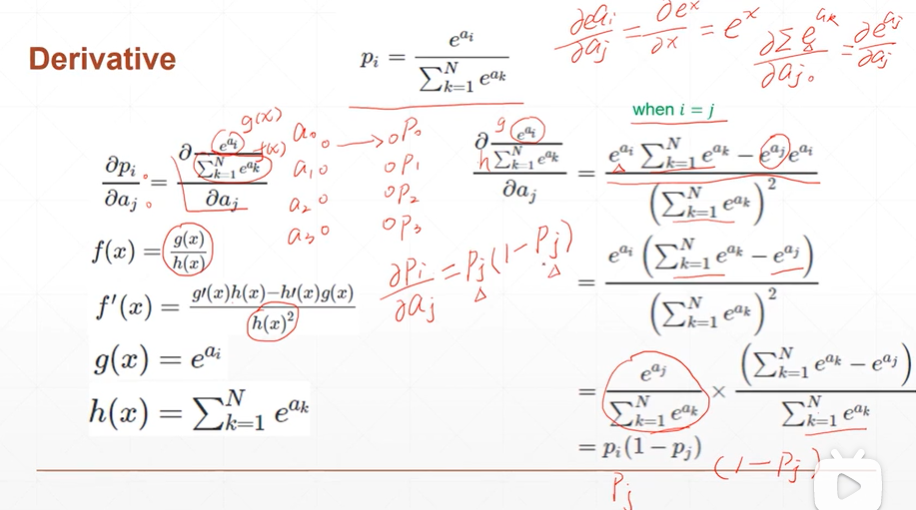

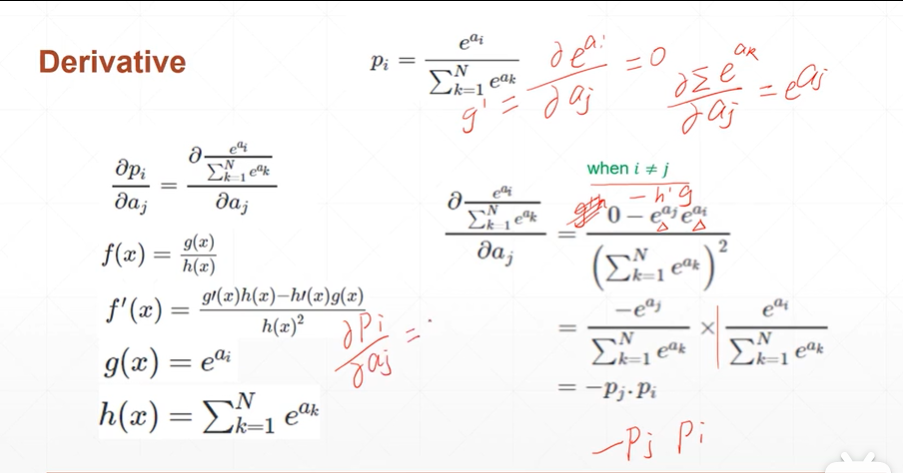

(2)softmax函数求导

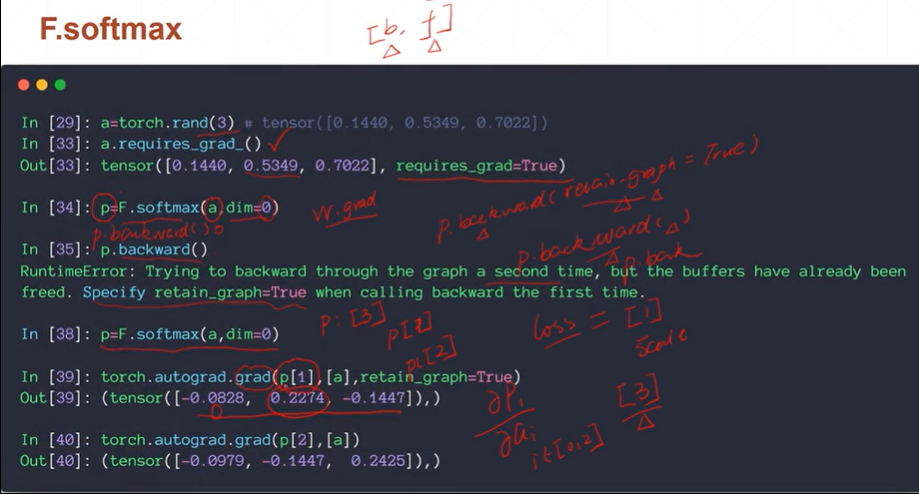

(3)softmax函数在pytorch中的使用

[注]求梯度有两种,分别为:p.backward()以及torch.autograd.grad().

当p.backward()不设置retain_graph=True时,当再次使用p.backward()会报错。原因:p.backward()会删除梯度.

[注]torch.autograd.grad(para,para2)参数1必须是一个维度和长度都为1的tensor。