论文地址:https://arxiv.org/abs/1906.05226?context=cs

已有研究工作:

本文主要参考了google那篇经典的ENAS模型,ENAS通过树结构的搜索空间或者Q-learning,基于权重共享策略进行架构搜索。

本文的工作和创新点:、

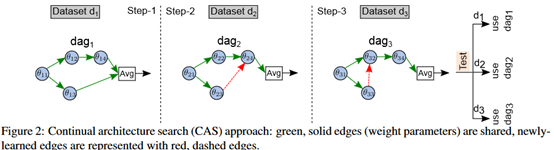

在ENAS的基础上,提出了CAS(Continual architecture search)方法。目的是在几个任务的连续训练期间不断地优化模型参数,同时不损失之前学习的任务的性能,从而支持持续学习。同时在ENAS的基础上,提出MAS(Multi-task architecture search)方法,目的是发现一种可泛化的单细胞结构,通过联合奖励函数来同时执行多个任务。

研究方法:

CAS:主要通过块稀疏性(block-sparsity)和正交化条件(orthogonality conditions)实现。设 为模型在d1这个数据集上训练所得到的最佳参数,

为模型在d1这个数据集上训练所得到的最佳参数, 为上述模型在d2这个数据集上再次训练得到的最佳参数,其中k代表模型参数,并设

为上述模型在d2这个数据集上再次训练得到的最佳参数,其中k代表模型参数,并设 ,

, 表示参数的改变量。

表示参数的改变量。

Condition1: 当在d1数据集上训练模型时,限制 为稀疏的,尤其是块稀疏的。可以通过l1,l2范式约束来实现。

为稀疏的,尤其是块稀疏的。可以通过l1,l2范式约束来实现。

Condition2:再次在d2数据集上训练模型时,保持 不变,更新

不变,更新 ,同时满足:

,同时满足: 是块稀疏的,

是块稀疏的, 和

和 相互正交。

相互正交。

整体流程如下图所示。

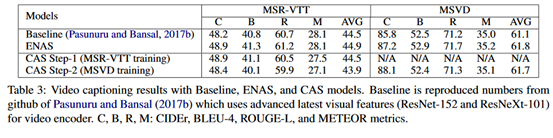

MAS:架构搜索的训练期间,控制器的联合奖励为 ,

, 是在第i个任务/数据集上的验证集的奖励。

是在第i个任务/数据集上的验证集的奖励。

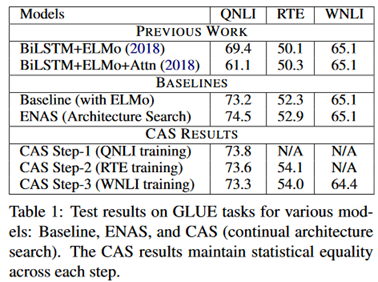

实验部分:分别在文本分类跟视频字幕生成数据集上展开实验,文本分类中用了QNLI、RTE、WNLI数据集,视频字幕生成中用了MSR-VTT、MSVD数据集。实验结果如下:

这个任务中,模型的学习顺序是QNLI-RTE-WNLI。

评价:

在ENAS的基础上增砖添瓦的一篇论文。主要研究了持续学习跟联合训练两个问题。对于持续学习,主要的问题是catastrophic forgetting,本文是通过块稀疏性跟正交化条件来进行约束的。联合训练是用RL的方法解决的。