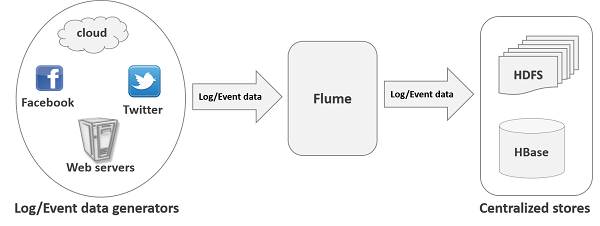

1、Flume概念

Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统。Flume基于流式架构,灵活简单。

Flume很多时候和storm以及spark streaming等流式处理框架结合使用。

Flume最主要的作用就是,实时读取服务器本地磁盘的数据(Python爬虫数据、java后台日志数据),将数据写入到HDFS。

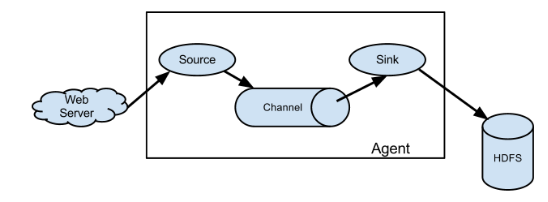

2、Flume组成架构

下面介绍Flume各组件

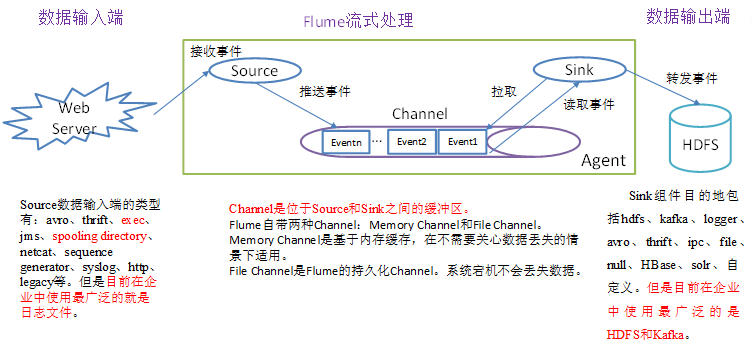

Event: 传输单元,Flume数据传输的基本单元,以事件的形式将数据从源头送至目的地。带有一个可选的消息头

Client:是一个将原始log包装成events并且发送它们到一个或多个agent的实体,在flume的拓扑结构中不是必须的

Agent: Agent是一个JVM进程,它以事件的形式将数据从源头送至目的,是Flume数据传输的基本单元。

Source: 负责接收event数据,并将events数据放到Channel,至少关联一个channel。Source组件可以处理各种类型、各种格式的日志数据,包括avro、thrift、exec、jms、spooling directory、netcat、sequence generator、syslog、http、legacy。

Channel: Channel是位于Source和Sink之间的缓冲区。因此,Channel允许Source和Sink运作在不同的速率上。Channel是线程安全的,可以同时处理几个Source的写入操作和几个Sink的读取操作。

Flume自带两种Channel:Memory Channel和File Channel。

Memory Channel是内存中的队列。Memory Channel在不需要关心数据丢失的情景下适用。如果需要关心数据丢失,那么Memory Channel就不应该使用,因为程序死亡、机器宕机或者重启都会导致数据丢失。

File Channel将所有事件写到磁盘。因此在程序关闭或机器宕机的情况下不会丢失数据。

Sink:Sink不断地轮询Channel中的事件且批量地移除它们,并将这些事件批量写入到存储或索引系统、或者被发送到另一个Flume Agent。

Sink是完全事务性的。在从Channel批量删除数据之前,每个Sink用Channel启动一个事务。批量事件一旦成功写出到存储系统或下一个Flume Agent,Sink就利用Channel提交事务。事务一旦被提交,该Channel从自己的内部缓冲区删除事件。

Sink组件目的地包括hdfs、logger、avro、thrift、ipc、file、null、HBase、solr、自定义。

其他组件:

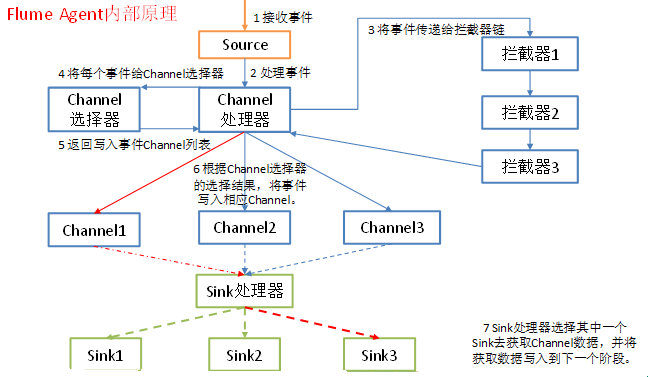

Interceptor:

作用于source,按照预设的顺序在必要的地方装饰和过滤events

Channel Selector :

允许source基于预设的标准,从所有的channel中,选择一个或多个Channel

Sink Processor

多个sink可以构成一个sink group,Sink Processor 可以通过组中所有sink实现负载均衡,也可以在一个sink失败时转移到另一个

Flow:Event从源点到达目的点的迁移的抽象

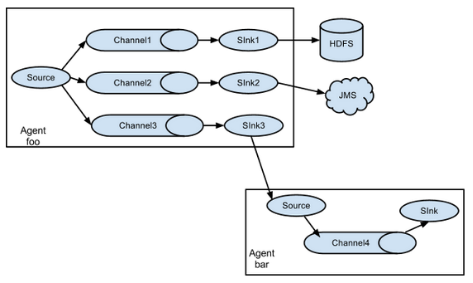

3、Flume拓扑结构

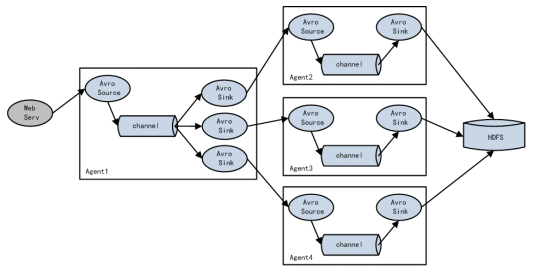

3.1 Flume Agent连接

3.2 单source,多channel、sink

3.3 Flume负载均衡

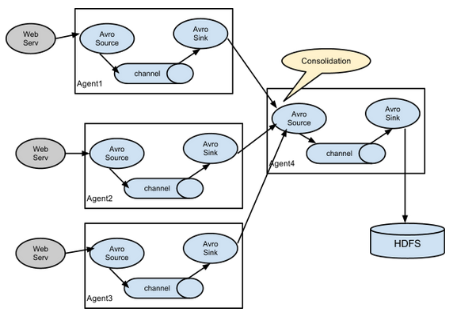

3.4 Flume Agent聚合

4、Flume Agent内部原理

5、Flume安装地址

1) Flume官网地址

2)文档查看地址

http://flume.apache.org/FlumeUserGuide.html

3)下载地址

http://archive.apache.org/dist/flume/

6、安装部署

1)将apache-flume-1.7.0-bin.tar.gz上传到linux的/opt/software目录下

2)解压apache-flume-1.7.0-bin.tar.gz到/opt/module/目录下

[jason@hadoop102 software]$ tar -zxf apache-flume-1.7.0-bin.tar.gz -C /opt/module/

3)修改apache-flume-1.7.0-bin的名称为flume

[jason@hadoop102 module]$ mv apache-flume-1.7.0-bin flume

4) 将flume/conf下的flume-env.sh.template文件修改为flume-env.sh,并配置flume-env.sh文件

[jason@hadoop102 conf]$ mv flume-env.sh.template flume-env.sh [jason@hadoop102 conf]$ vi flume-env.sh export JAVA_HOME=/opt/module/jdk1.8.0_144