1 存在的问题

在两层深度网路中,作为第二层的输入的第一层输出会被参数影响从而无法保持稳定的分布,影响学习效果,导致不能设定较大的学习率以及需要精巧的初始化手段

我们把这个问题叫做内部协变量偏移

2针对内部协变量偏移

传统手段:白化,但是会带来梯度爆炸的问题,因为偏移b无法影响白化后的输入值,即b可能朝着一个方向无限增大或减小,但是不影响白化后的输入值x,这就导致了梯度爆炸

传统白化手段的问题在于没有考虑整个输入数据集,求解对应的Jacobians需要计算x与整个数据集的偏导数

3利用Mini-Batch统计的均值和方差

算法1

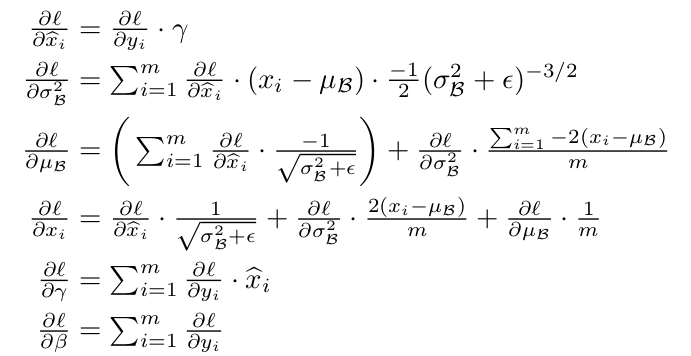

反向传播:

3.1BN网络训练及推断

3.2BN化卷积神经网络

3.3BN能够使用高学习率

3.4BN正则化

在使用BN层可以替代DropOut的作用