最近做的一个项目的一部分就是分词技术,在网上找到的技术也有很多,在这里对hanlp和ansj技术进行代码展示以及结果展示

首先是hanlp技术对分词的使用:

1.下载hanlp的jar包(地址:http://hanlp.linrunsoft.com/services.html)

2.创建一个测试的java project 新建一个test的测试类进行测试:(代码如下)

package hanlp; import java.util.List; import com.hankcs.hanlp.HanLP; import com.hankcs.hanlp.seg.common.Term; import com.hankcs.hanlp.tokenizer.NLPTokenizer; import com.hankcs.hanlp.tokenizer.TraditionalChineseTokenizer; public class test { public static void main(String args[]) { List<Term> termList = NLPTokenizer.segment("中国科学院计算技术研究所的宗成庆教授正在教授自然语言处理课程"); System.out.println(termList); } }

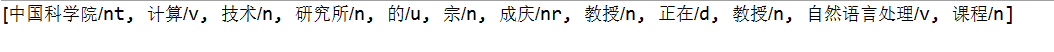

展示结果如下:

其次介绍ansj技术对分词的解决办法:

1.下载ansj的jar包( http://maven.ansj.org/org/ansj/)

代码如下:

package AnsjTest; import java.util.List; import org.ansj.splitWord.analysis.IndexAnalysis; import org.ansj.splitWord.analysis.ToAnalysis; import com.hankcs.hanlp.seg.common.Term; import com.hankcs.hanlp.tokenizer.NLPTokenizer; public class test { public static void main(String args[]) { String str="欢迎使用ansj_seg,(ansj中文分词)在这里如果你遇到什么问题都可以联系我.我一定尽我所能.帮助大家.ansj_seg更快,更准,更自由!"; System.out.println(IndexAnalysis.parse(str)); } }