1.数学家证明了,双隐层神经网络能够解决任意复杂的分类问题。

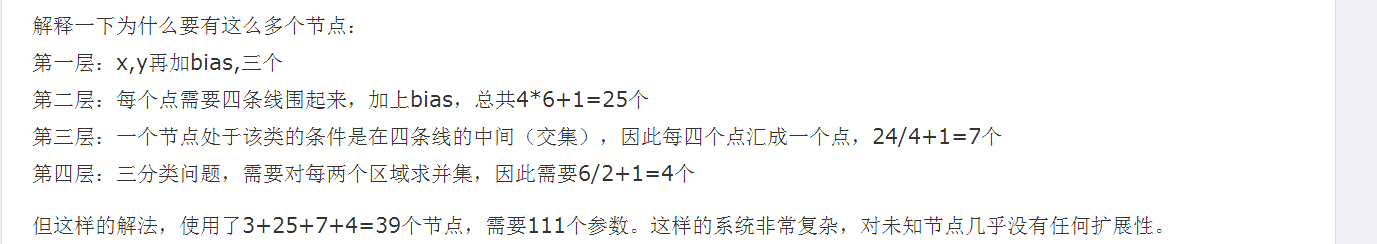

下面写一下如何计算这些数目。第一层:因为是平面问题所以分类器是对一个点进行分类他有2个参数,所以这里我们写x,y

因为是放射函数,所以还需要一个bias,所以第一层有3个参数x,y,bias。所以知道了,任何层都需要一个bias参数。

下面算第二层。这个层体现每一个点,用4个线来包围表示属于这个点的类的区域所以是25.

第三层是区域一共6个素以加bias是7个。第四层:最后输出结果是哪个类应该是3个。他写4个不清楚。最后的层是不加bias的。

向前传播(Forward Propagration,FP):

输入:

http://zzk.cnblogs.com/s/blogpost?Keywords=%E7%A5%9E%E7%BB%8F%E7%BD%91%E7%BB%9C&ViewCount=10000&pageindex=1

直接进入流量1万以上的博客。就从这些开始看

1.

这个卷积的求和范围[-a,a] ,[-b,b] 叫做卷积核的大小。他决定了定义了图像中任何一点参与运算的邻域的大小。

这个文章http://www.cnblogs.com/ronny/p/ann_03.html

真的写的很清楚。不知道为什么这些年读书总是感觉越是大神写的经典书籍越看不懂说啥,越感觉他各种跳步,阐述东一步西一步,

就喜欢这种民科气息写的心得感觉更有实用和体会的价值。

根据上面的定义这里写错了,应该反过来求和即:

35*w9+124*w8+...+206*w1

但是这个问题不大,因为如果上面定义的卷积是:

中间取减号即可就是他所写的。这个虽然在数学上不同,但是在电脑里面没啥本质区别,因为只不过为了一个加权平均的效果而已。

跑程序这么写输出来的矩阵也就是之前矩阵反着写而已,对数学不同但是对代码相同。所以不用在意这些真正的细节。