上周参加了XX大学研究生推免的面试,面试老爷问到了resnet主要解决了什么问题,我下意识的回答到解决了当网络加深的时候会出现的vanishing/exploding gradients,然后面试老爷的表情就很丰富。这两天推免名额到手了,翻了翻resnet的paper(Deep Residual Learning for Image Recognition Kaiming He Xiangyu Zhang Shaoqing Ren Jian Sun Microsoft Research),em....果然回答错了。

论文地址:https://arxiv.org/pdf/1512.03385.pdf

先放一段原文:

大致就是随着深度的加深可能产生的vanishing/exploding gradients由normalized initialization和intermediate normalization解决了(读到的时候心理那叫一个刺激...)。残差网络主要解决了网络退化的问题(随着网络的深度增加,准确度反而下降了)。留下不学无术的眼泪。。。。

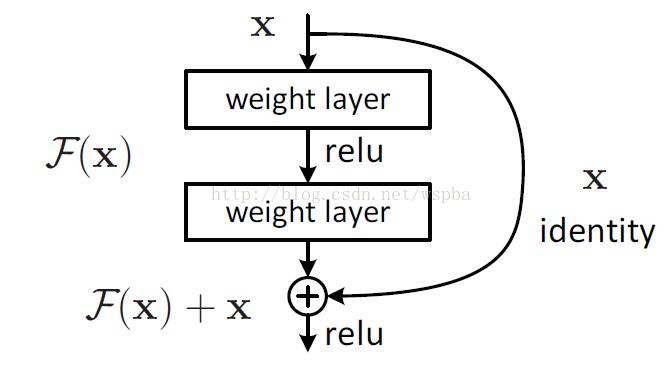

针对这个问题,作者提出了一个Residual的结构:

即增加一个identity mapping(恒等映射),将原始所需要学的函数H(x)转换成F(x)+x,而作者认为这两种表达的效果相同,但是优化的难度却并不相同,作者假设F(x)的优化 会比H(x)简单的多。这一想法也是源于图像处理中的残差向量编码,通过一个reformulation,将一个问题分解成多个尺度直接的残差问题,能够很好的起到优化训练的效果。 这个Residual block通过shortcut connection实现,通过shortcut将这个block的输入和输出进行一个element-wise的加叠,这个简单的加法并不会给网络增加额外的参数和计算量,同时却可以大大增加模型的训练速度、提高训练效果,并且当模型的层数加深时,这个简单的结构能够很好的解决退化问题。

面试的时候还提到了一个问题:残差网络的残差怎么来的,现在看了看论文,应该是从文献中的残差表示入手。留下不学无术的眼泪......