一.相关知识

1.向量空间(线性空间):向量张成的空间(简单来说,就是一些向量及其线性组合组成的集合,而且这个集中定义了一些代数运算,张:向量的线性组合)

2.维度:Rn表示n维实数集的向量空间,n表示向量的维度,也就是需要描述一个向量(或者说是一个数学对象)所需要的参数个数,R表示每个参数是在实数集上定义的

3.基:是描述、刻画向量空间的基本工具,向量空间的基是向量空间的一个特殊的子集

4.基向量:基中的元素称为基向量,向量空间中任意一个元素,都可以唯一地表示成基向量的线性组合

5.正交基:一组基向量中,基向量两两之间互不相关,则这是这一组正交基,正交就是不线性相关,内积为0

6.标准正交基:每个基向量的模长都为1,线性空间的每个向量都可以用其对应的标准正交基的线性组合来表示,相当于坐标系

7.维度灾难:用向量表示样本时,每个特征代表一个维度的表示,若特征数太多,即维度太大,则会导致样本间计算变复杂,数据样本变得稀疏

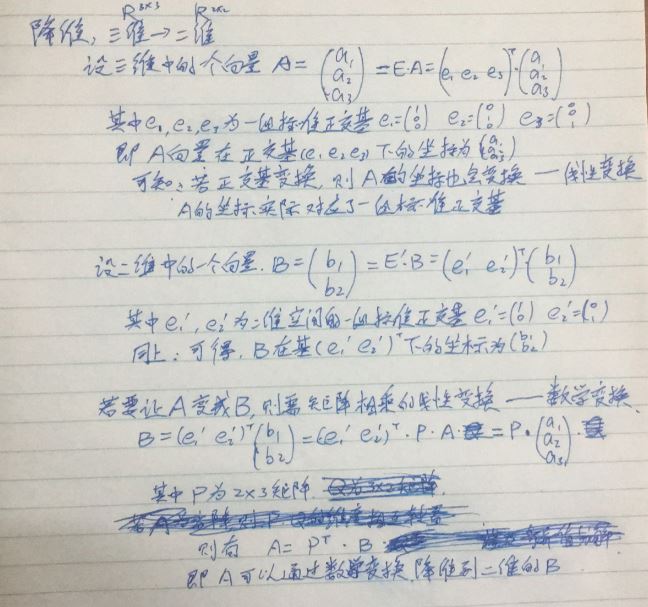

8.降维:通过某种数学变换,将原始高维属性空间转为一个低维子空间,这样,样本密度提高,计算变简单

(1)改变的是向量空间,而向量空间可以用正交基来表示,因此实际是把高维空间的正交基变为低维空间的正交基

(2)单个向量的降维

(3)降维就是数据变换、矩阵乘法,但是我们用降维的目的并不仅仅是做变换,而是为了某个目的做降维处理,怎么使得降维前和降维后数据的某些特性一致是我们的目的,也就是说对于降维后的空间有所要求

(4)通过评估降维前和降维后模型的性能,若有所提升,则表示降维起了作用

二.k近邻(KNN---k nearest neighbor):

1.一种监督学习方法,给定测试样本,基于某种距离度量找出训练集中与其最靠近的k个训练样本,然后基于这k个邻居的信息采用投票法和平均法来进行预测。要注意k的选取和距离度量指标的选取

三.降维方法

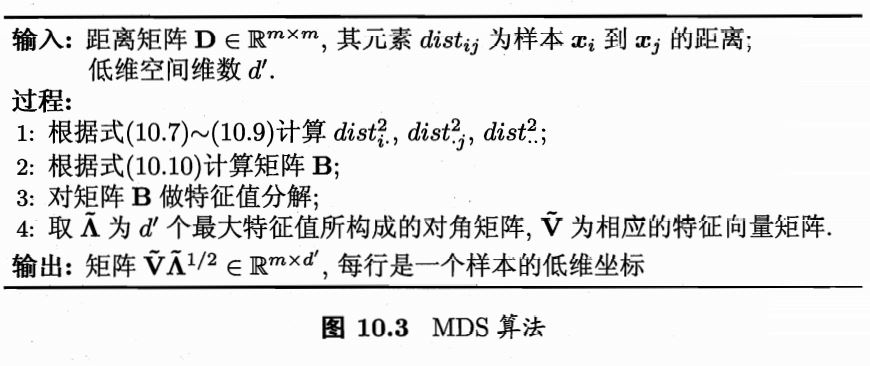

1.多维缩放MDS:要求:降维前后样本间距离尽量接近,计算内积矩阵,再对该矩阵作特征值分解

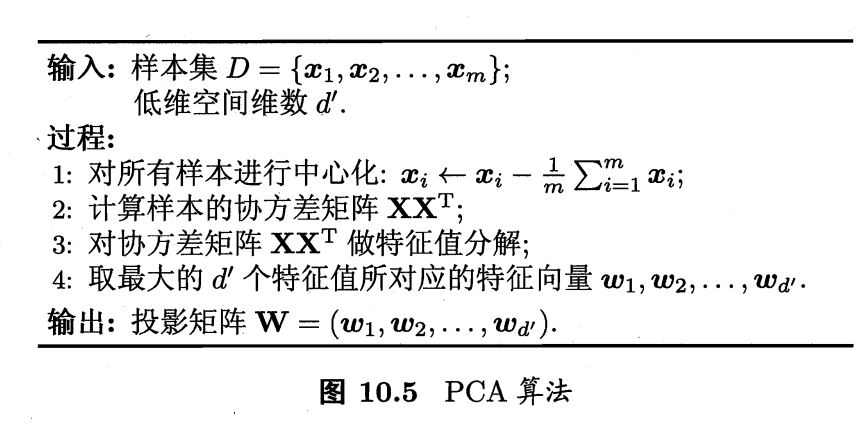

2.PCA:要求:样本投影后之间的距离尽量大(方差大),信息保留最多

3.核技巧降维:要求:不关注是如何作线性变换的,关注的是线性变换后样本间的内积,用一个核函数来表示,也就是说直接定义了降维后空间的内积运算

4.流形学习:通过在局部建立映射关系,再将其拓展到整个全局

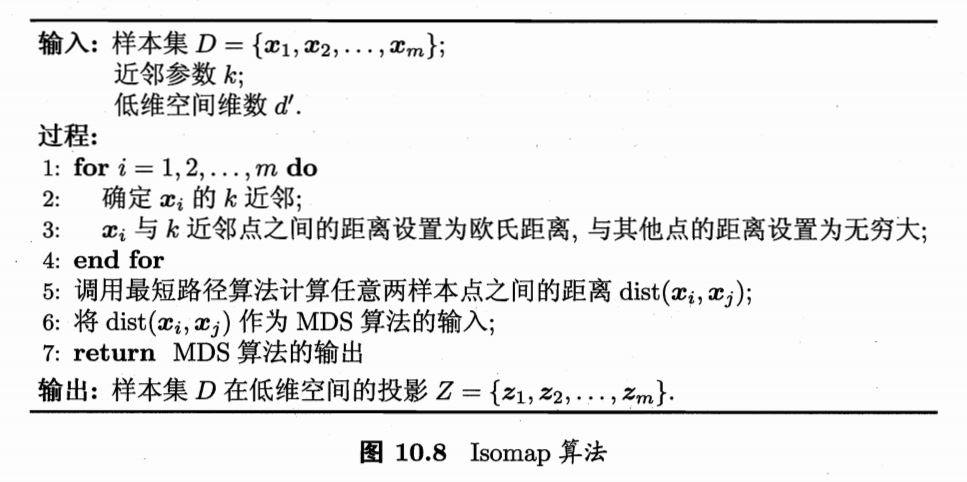

(1)等度量映射(Isomap):基于高维空间的距离计算不适用于低维空间(因为少量某些维度上面的计算),但是在局部看来,距离计算是相似的,因此对于每个数据点计算其近邻点的距离(局部距离),再将其拓展到整个高维空间(最短路径),则得到低维空间中的样本表示,再用学习器去学习高维到低维的映射

(2)局部线性嵌入:保持邻域内样本之间的线性关系,每一个数据点都可以由其近邻点的线性加权组合构造得到