总结:逻辑回归是在线性回归的基础上套用了一个逻辑函数。线性回归是进行回归预测,逻辑回归是用来分类,即离散。线性回归是在整个实数空间进行回归,逻辑回归把整个回归限定在实数范围0,1的回归,以某一阈值作为分类判别

逻辑回归中逻辑函数:

线性回归的模型是求出输出特征向量Y和输入样本矩阵X之间的线性关系系数θ,满足Y=Xθ。此时我们的Y是连续的,所以是回归模型。如果我们想要Y是离散的话,怎么办呢?一个可以想到的办法是,我们对于这个Y再做一次函数转换,变为g(Y)。如果我们令g(Y)的值在某个实数区间的时候是类别A,在另一个实数区间的时候是类别B,以此类推,就得到了一个分类模型。如果结果的类别只有两种,那么就是一个二元分类模型了。逻辑回归的出发点就是从这来的。

例子中:x轴为肿瘤的大小,y轴为肿瘤为恶性的概率;当如1.b图中按0.5的概率划分的时候,会把单独绿色圈的大尺寸的肿瘤化为良性的,就会出现严重的误诊情况;由上可以知道线性回归的鲁棒性很差,例如在图1.b的数据集上建立回归,因最右边噪点的存在,使回归模型在训练集上表现都很差。这主要是由于线性回归在整个实数域内敏感度一致,而分类范围,需要在[0,1]。逻辑回归就是一种减小预测范围,将预测值限定为[0,1]间的一种回归模型;

https://blog.csdn.net/lisi1129/article/details/70939659

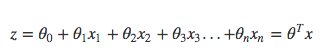

线性回归的公式如下:

而对于Logistic Regression来说,其思想也是基于线性回归(Logistic Regression属于广义线性回归模型)。其公式如下:

被称作sigmoid函数,我们可以看到,Logistic Regression算法是将线性函数的结果映射到了sigmoid函数中。

https://blog.csdn.net/programmer_wei/article/details/52072939

如何去求逻辑回归? --- 极大释然估计

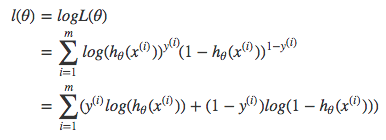

假设样本之间是相互独立的,释然函数为:

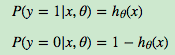

我们知道,按照第二节二元逻辑回归的定义,假设我们的样本输出是0或者1两类(服从伯努利分布,或者说0、1分布)。那么我们有:

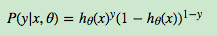

把这两个式子写成一个式子,就是:

可以这样理解,当y为0的时候,前面的指数就为1;当y为1的时候,后面的指数就为1

可以这样理解,当y为0的时候,前面的指数就为1;当y为1的时候,后面的指数就为1

这个就是样本的概率分布(或者说释然函数),释然函数一般求log,也就变成:

求得释然函数就可以用梯度下降去求解

https://blog.csdn.net/Flying_sfeng/article/details/78002564

https://www.cnblogs.com/pinard/p/6029432.html

https://blog.csdn.net/programmer_wei/article/details/52072939