离散型随机变量对应着机器学习里面的分类问题。

连续型随机变量对应着机器学习里面的回归问题。

3.中的第一行解释:Y=b的所有情况都加起来。

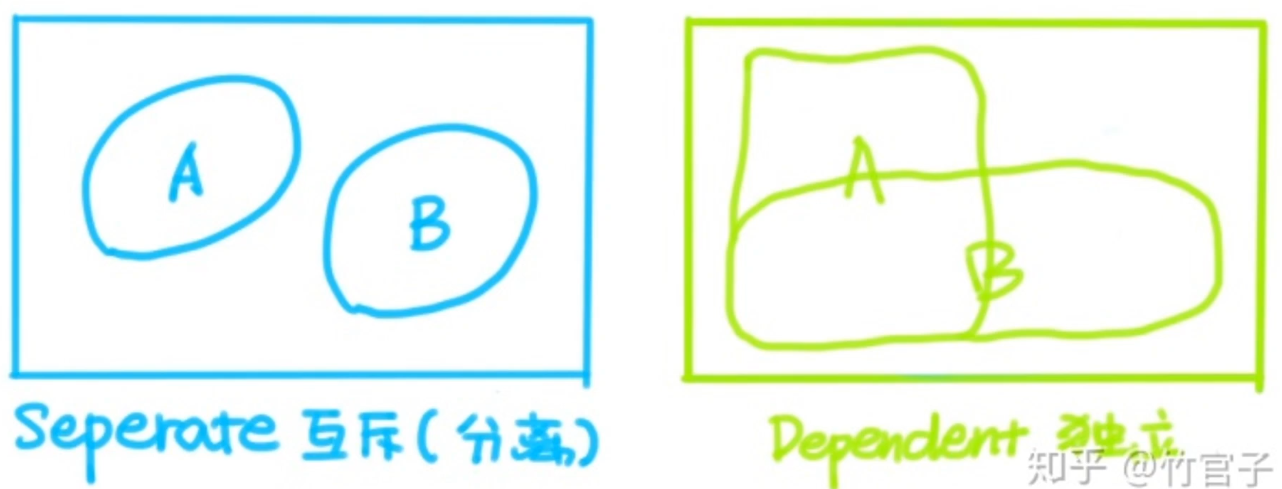

互斥事件:掷骰子,出现3点和出现6点是互斥事件。

相互独立事件:明天会不会下雨和小明此时有没有在玩电脑游戏。这两个事件是相互独立的,这两件事情之间没有关系。它们同时发生的概率是这两件事情单独发生的概率的乘积。

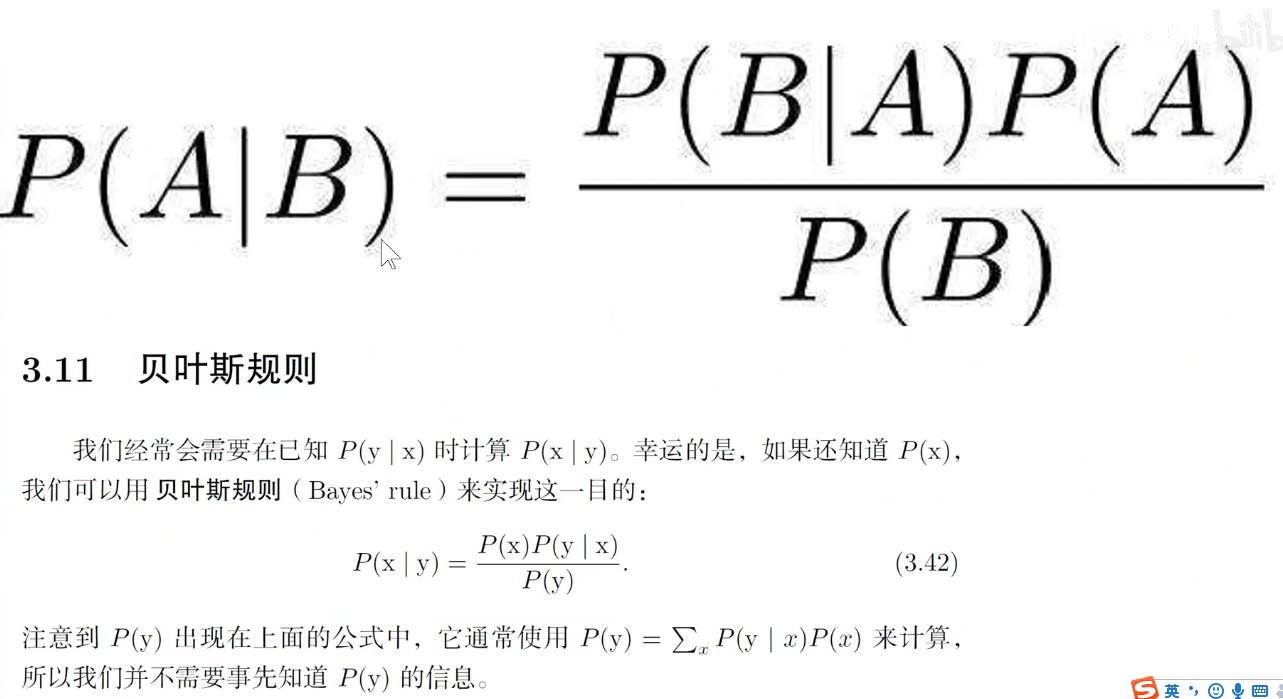

通过这个公式实现了条件概率的交换。左边是B事件发生的条件下A事件发生的概率。右边含有A事件发生的条件下B事件发生的概率。

Pc是先验概率,就是通过大范围的调查和采样可以获取的概率。P(c|x)是后验概率,贝叶斯公式就是根据先验概率、似然概率和证据因子来求后验证概率。

伯努利分布:

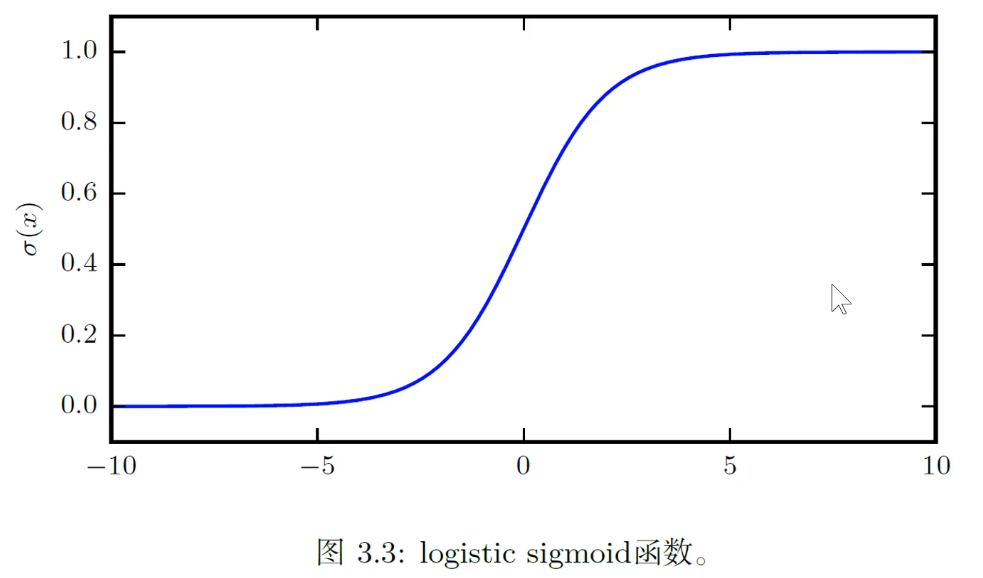

sigmoid函数:四个贸易的 sigmoid()函数的作用是把任何的一个输入变成一个0-1之间的概率值。

sigmoid()函数的作用是把任何的一个输入变成一个0-1之间的概率值。

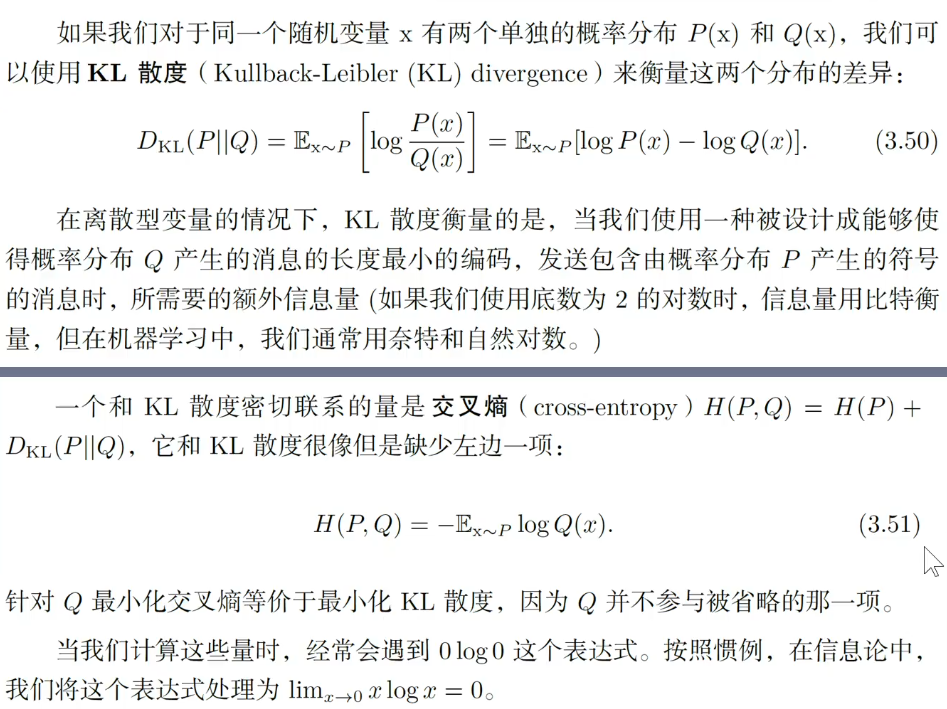

公式3.48:对一个概率先求对数,然后再加上一个负号。概率值越接近于零,它的值就越大。