https://arxiv.org/pdf/2109.00301.pdf

本文特点:无限长期记忆、任意长度上下文

本文进行了3个实验:

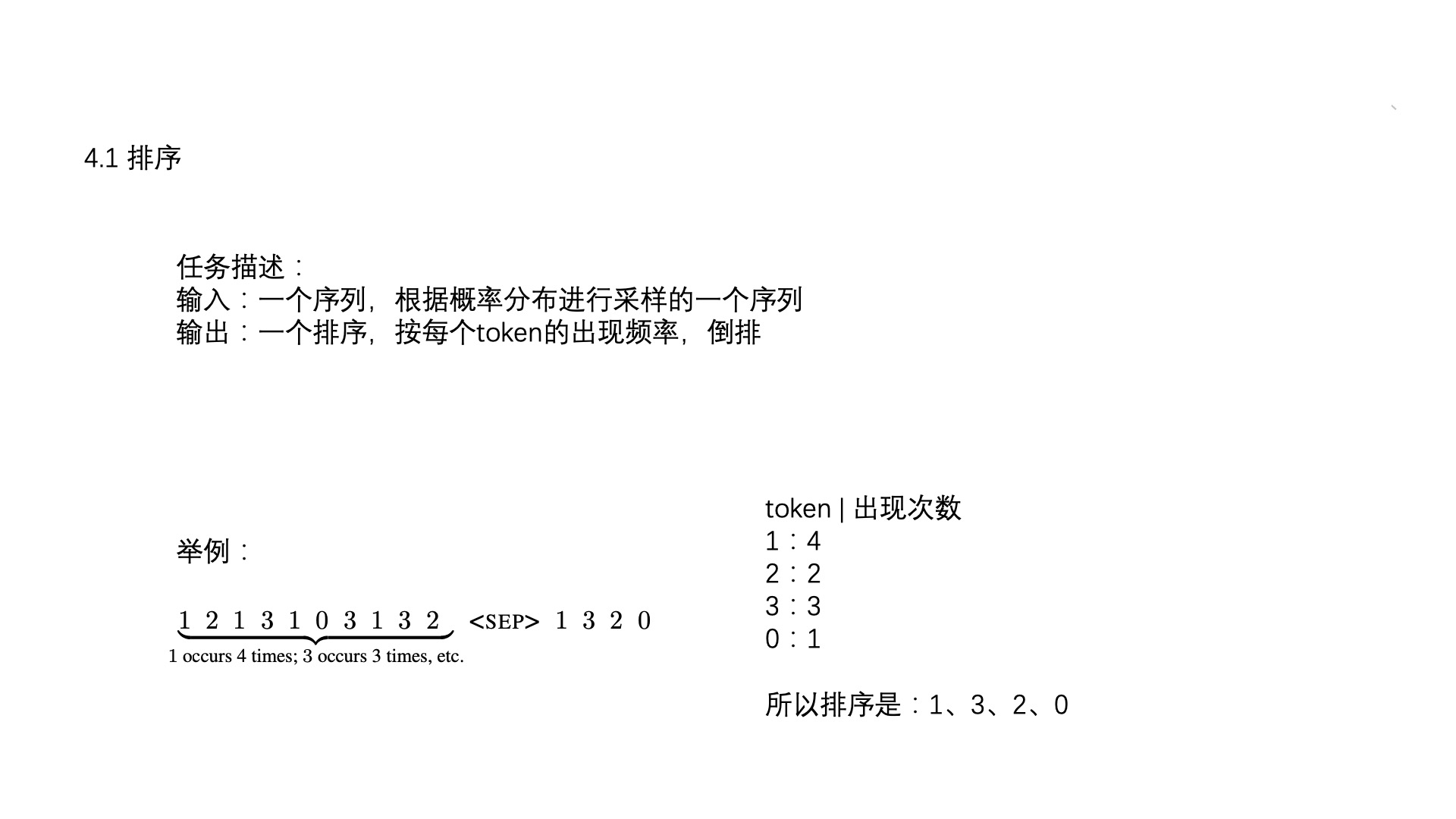

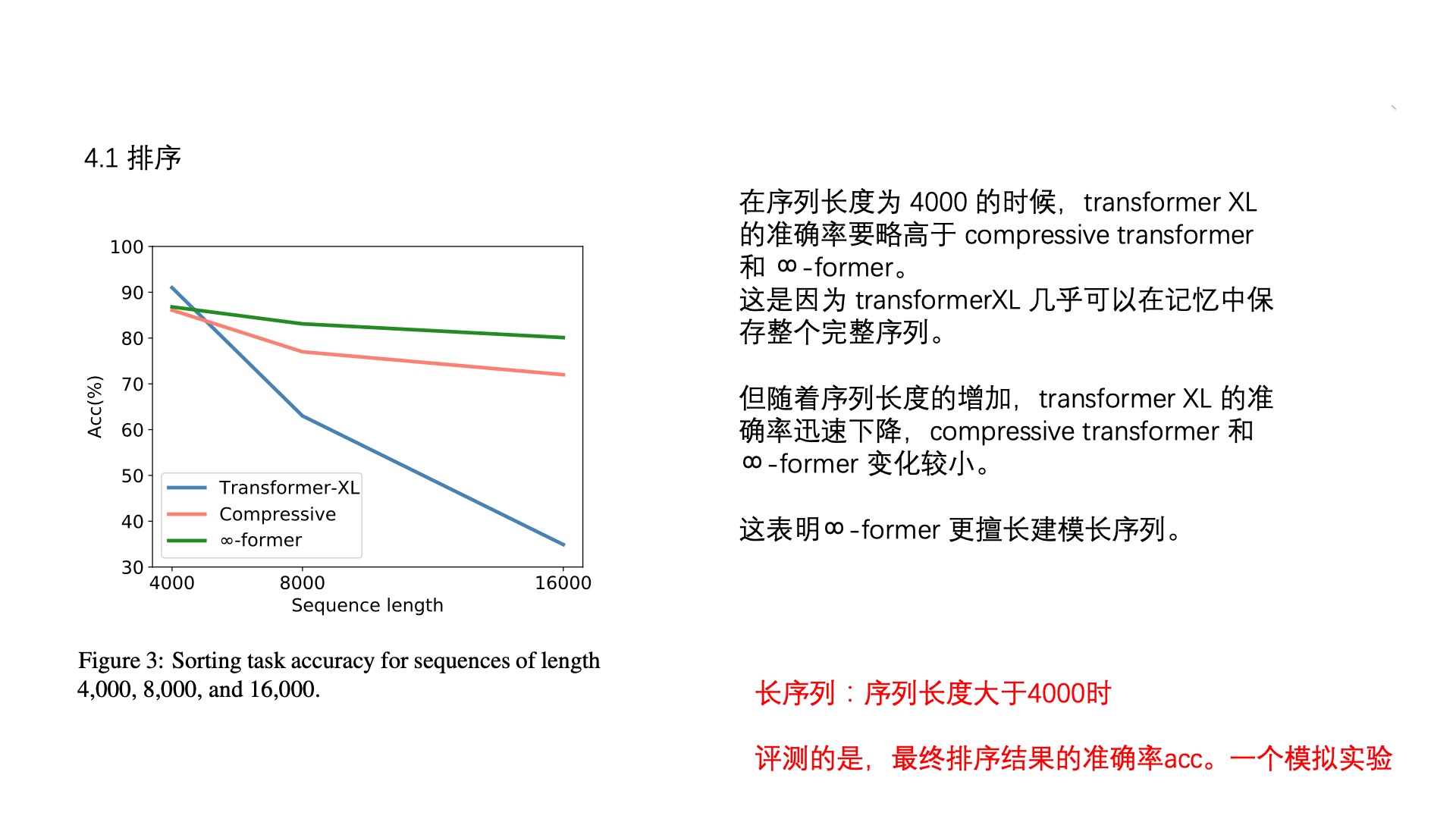

(1)综合实验,长度4000、8000、16000,预测token排序的准确率

(2)语言建模,在Wikitext-103 ,LTM取150 Gaussian RBFs, STM取150,记忆阈值900。

困惑度比Transformer-XL 和Compressive Transformer有提高。

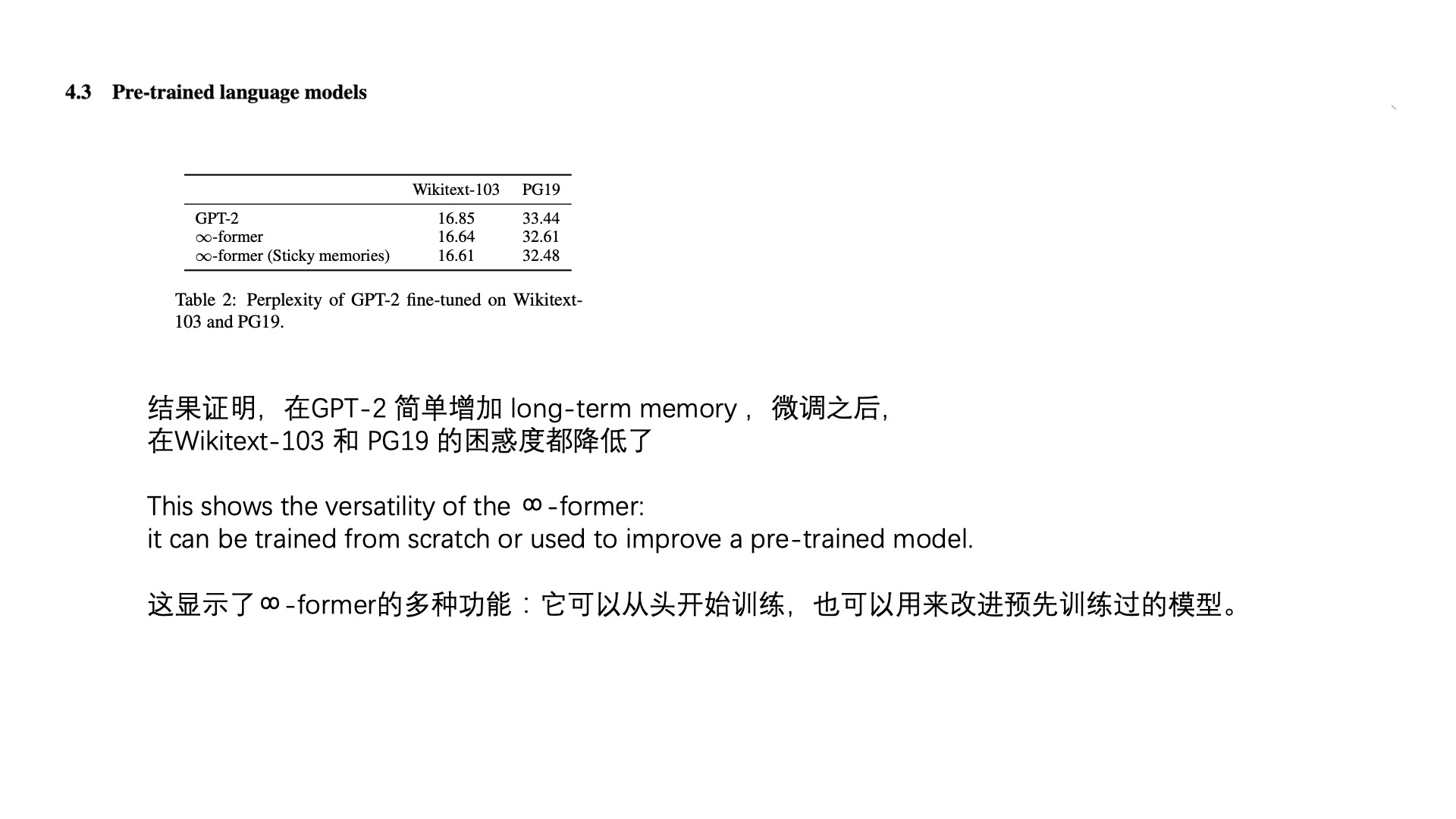

(3)微调,在Wikitext-103 和PG-19 ,给GPT-2 small 增加长期记忆,困惑度也降低了。