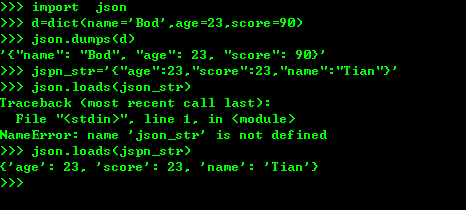

一、pthon 序列化json格式

1、将python内置对象转换成json 模块,dumps()方法返回的是一个str,内容是标准的JSON,dump()方法可以直接吧JSON写入一个file-like-object,要把JSON反序列化为python对象,使用loads()或者对立的方法,

2、多线程和多进程 (multiprocessing)

3、常见的模块

datetime模块包含一个datetime的类。通过 from datetime import datetime 导入的才是datetime 这个类

from datetime import datetime dt=datetime(215,4,15,21,12) dt.timestamp()

collections模块 ,namedtuple是一个函数,它用来创建一个定义的tuple对象,规定了tuple的元素个数,并可以使用属性而不是缩影来引用tuple的元素。

from collextions import namedtuple Point=namedtuple("Point",['x','y']) p=Point(a,2) p.x

deque函数,为了实高效的插入和删除双向列表,适合队列和栈:

from collections import deque q=deque(['a','v','f']) q.append('x') q.appendleft('f') deque 实现了appendleft() 和popleft()

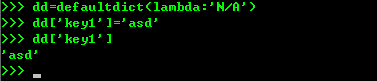

defaultdict使用dict时如果 可以不存在,就会抛出keyError,

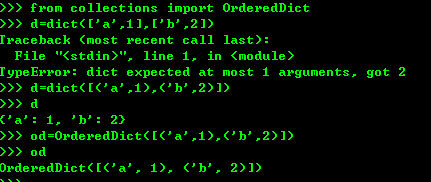

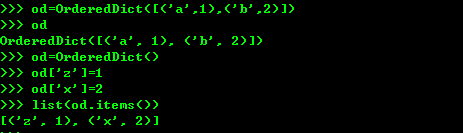

使用dict的时候。key是无序的 ,但是对dict做迭代,无法确定key的顺序,如果要保持key的顺序,使用OrderedDict

OrderedDict的key会按照插入的顺序排列,不是key本身排列

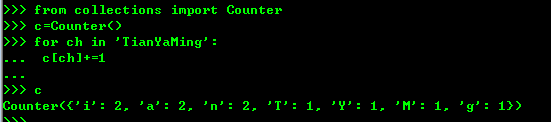

counter是一个简单的计数器,统计字符出现的个数

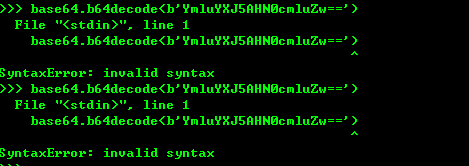

base64编码机制,标准的base64编码可能出现字符+ 或者—号,在URl中不允许出现,所以又有一种url safe的base64编码 把+ 或者-号编程-和_

struct模块提供了一个解决bytes其他二进制数据类型转换 ,struct的pack函数把任意的数据类型转换成bytes....。pack的第一个参数是处理指令,I表示4字节无符号整数,后面的参数个数和要处理的指令一致。unpack把bytes变成相应的数据类型

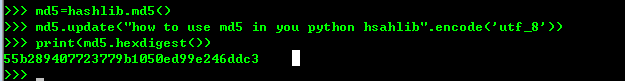

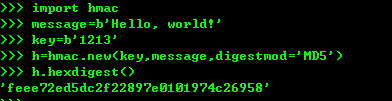

4、python提供了常见的MD5和SHA1 等算法,摘要算法又叫哈希算法 散列算法。它是把任意长度的数据转换成一个固定长度的数据通常用十六进制的字符串表示。摘要算法是通过摘要函数f() 对任意长度的数据data 计算出长度固定的digest目的就是防止原始数据被人篡改。,而且对原始数据做了一个bit的修改,就会导致计算出来摘要完全不同。

如果数据较大可以多次调用hashlib模块中的MD5函数计算结果是一样的。

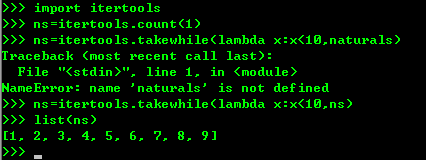

5、python内的模块itertools提供了操作迭代对象的函数,

import itertools naturals=itertools.count(1)

for n in naturals: print(n)

因为count()函数会创建一个无限的迭代器,上述计算会无限的迭代下去。

另一个函数循环迭代的就是cycle()函数。

import itertools

cs=itertools.sycle('ABC')

for c in cs: print(c) 这样就会一直持续循环输出ABC

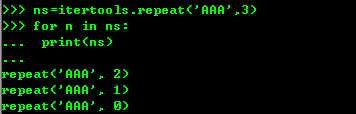

还有一个重复函数就是repeat函数。

ns=itertools.repeat('A',3)

for n in ns:

无限循环只有在for迭代时候才会无限制的迭代下去,如果只是创建一个迭代对象,他不会实现把无限个元素 生成出来,是时候是哪个也不会在内存中创建无限循环的元素,但是通常使用takewhile()函数对判断条件截取出一个有限的循环。

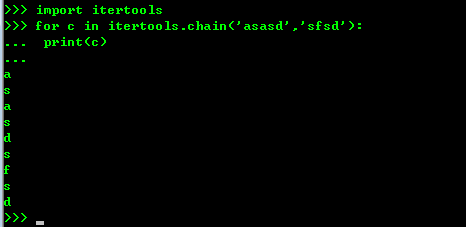

chain()函数可以把一组迭代对象串联起来,形成一个更大的迭代器。

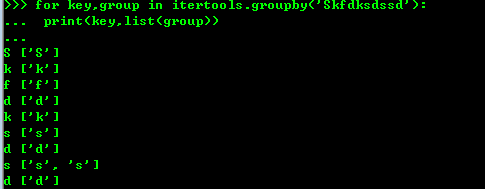

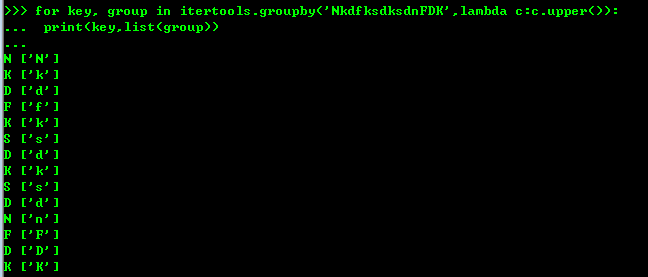

groupby()函数把迭代器中相邻的重复的元素挑出来放到一起

6、contextlib模块, 在python中必须关闭文件,但是使用with参数就不用。

try: f = open('/path/to/file', 'r') f.read() finally: if f: f.close()

可以直接改写成这样的形式, with open('/path/file','r')as f: f.read() 就可以不必在担心文件的关闭

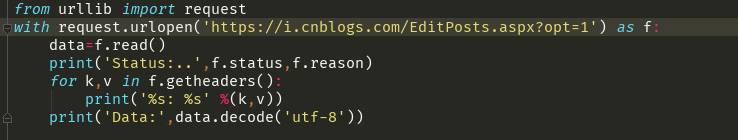

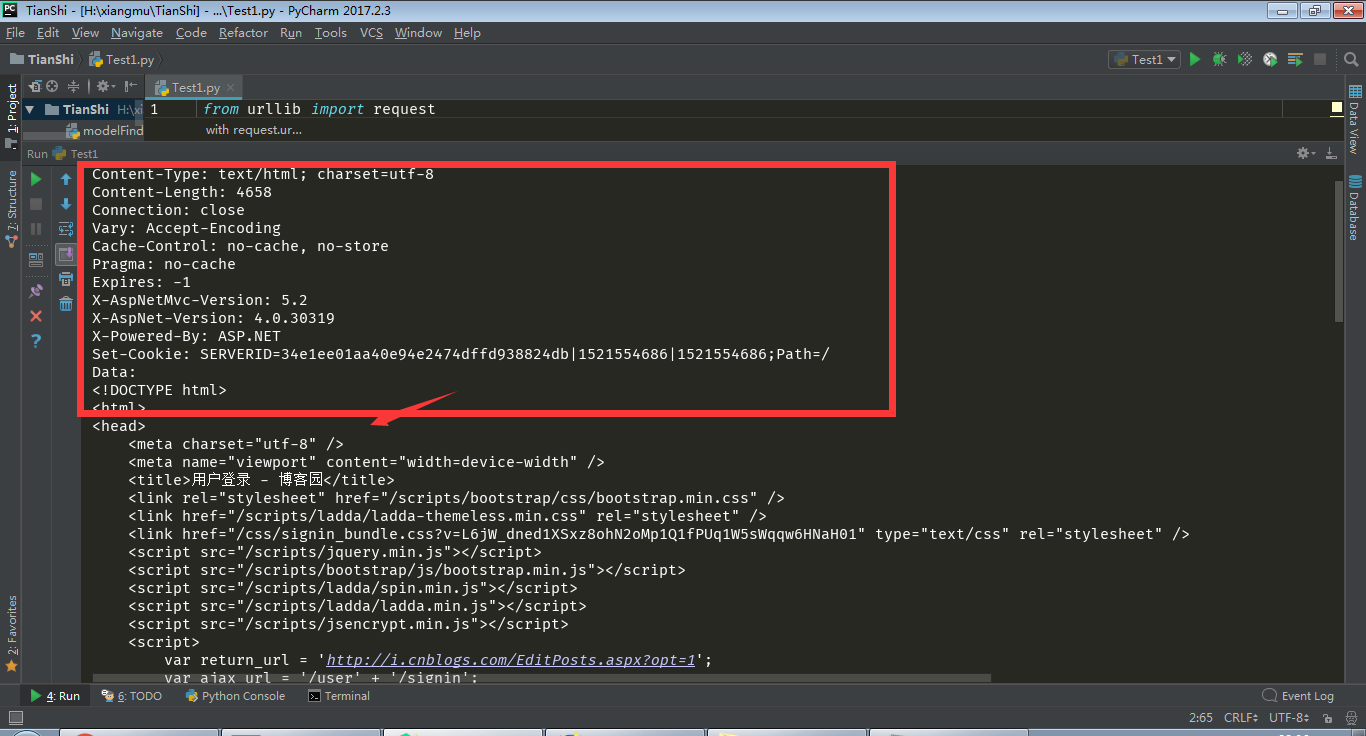

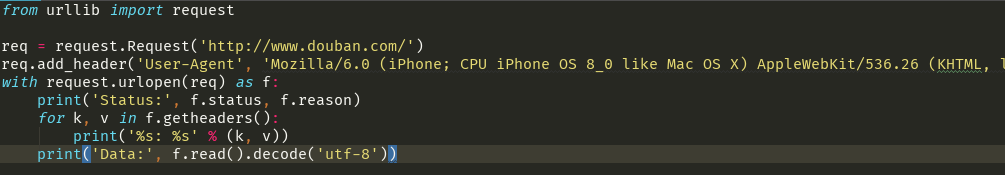

7、简单的网站抓取获得

要是伪装成一台iPhone6区访问网页抓取网页内容

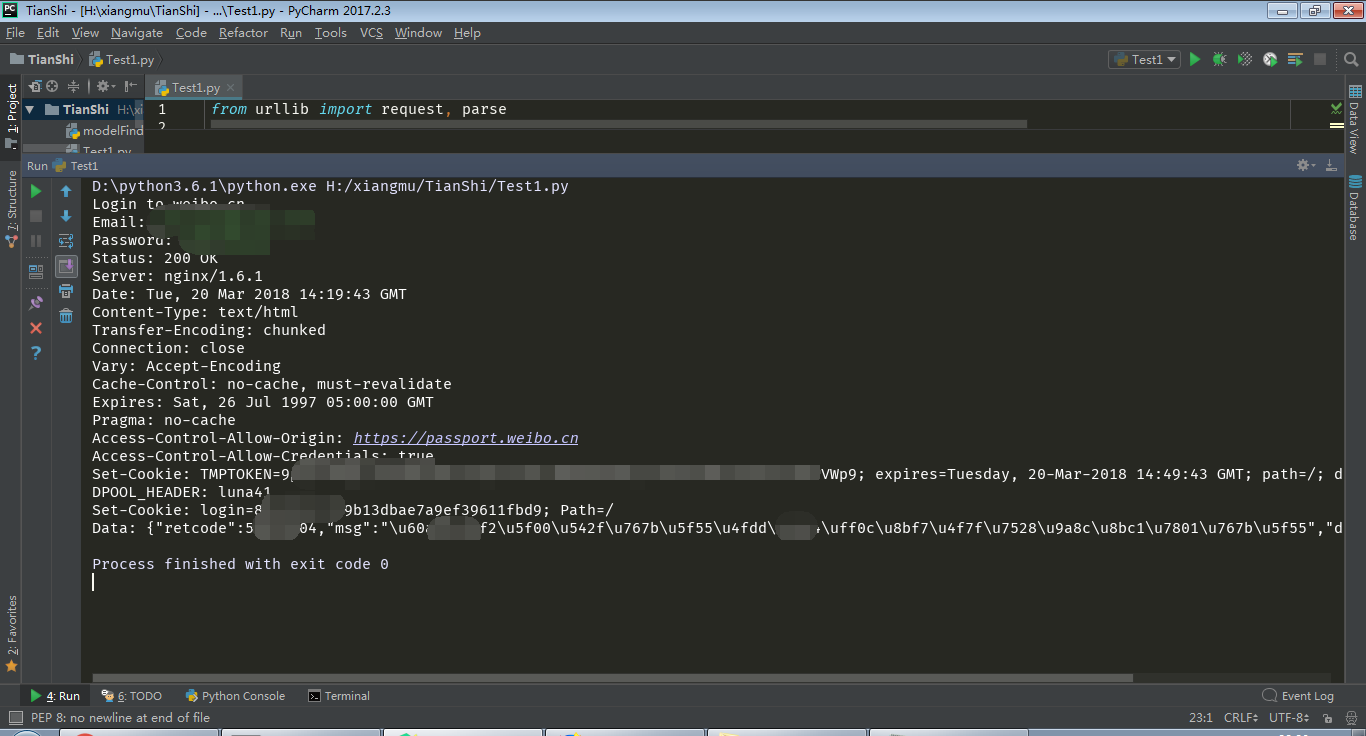

模拟微博登陆