sqoop目前有两个版本sqoop1和sqoop2,这里安装的是sqoop1版本

1)将软件上传到spark1节点

2)修改权限

[root@spark1 sqoop]# chmod u+x sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz

3)解压安装

[root@spark1 sqoop]# tar -zxvf sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz

4)重命名

[root@spark1 sqoop]# mv sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz sqoop-1.4

5)配置环境变量

[root@spark1 sqoop]# vi /etc/profile

export SQOOP_HOME=/usr/sqoop/sqoop-1.4

export PATH=$PATH:$SQOOP_HOME/bin

export LOGDIR=$SQOOP_HOME/logs #一定要加上这个

6)使环境变量生效并验证是否配置成功

[root@spark1 sqoop-1.4]# source /etc/profile

[root@spark1 sqoop-1.4]# which sqoop

7)修改配置文件 sqoop-env.sh

[root@spark1 conf]# mv sqoop-env-template.sh sqoop-env.sh

#重命名

[root@spark1 conf]# vi sqoop-env.sh

#Set path to where bin/hadoop is available

export HADOOP_COMMON_HOME=/usr/hadoop/hadoop-2.6.0

#Set path to where hadoop-*-core.jar is available

export HADOOP_MAPRED_HOME=/usr/hadoop/hadoop-2.6.0

#Set the path to where bin/hive is available

export HIVE_HOME=/usr/hive/hive-1.2

暂时没安装hbase和zookeeper就不修改了

8)将所需要的mysql驱动包拷贝到Sqoop/lib下

#先在网上下载驱动包mysql-connector-java-5.1.10.jar

[root@spark1 sqoop]# cp mysql-connector-java-5.1.10.jar /usr/sqoop/sqoop-1.4/lib

9)测试sqoop

显示mysql下所有数据库

[root@spark1 sqoop]# sqoop list-databases --connect jdbc:mysql://spark1:3306 --username root

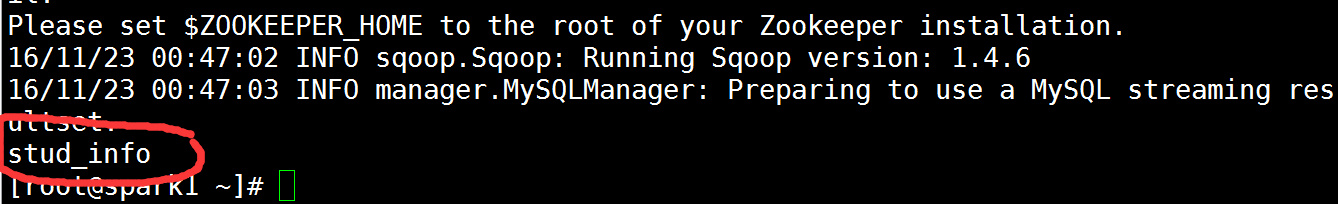

查看mysql wujiadong数据库中的表

[root@spark1 ~]# sqoop list-tables --connect jdbc:mysql://spark1:3306/wujiadong -username root

注释

1)因为暂时没安装hbase和zookeeper,没修改sqoop中的配置文件内容,运行时出现警示,不过问题不大。

2)命令sqoop list-databases --connect jdbc:mysql://spark1:3306 --username root --password xxx中

username和password使mysql的用户名和密码,我因为没去设置mysql的密码,所以直接无密码登录