一、下载kafka安装包

下载路径:http://kafka.apache.org/downloads

并上传到linux机器中

解压到指定目录:

tar -zxvf kafka2.11/ -C /opt/soft/

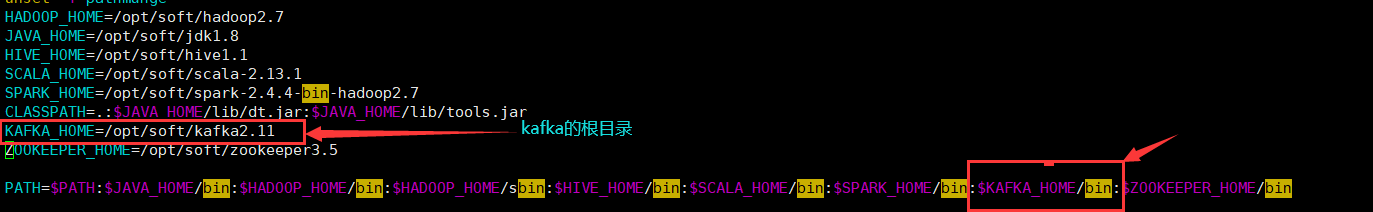

二、添加环境变量

vim /etc/profile

加入下图环境变量:

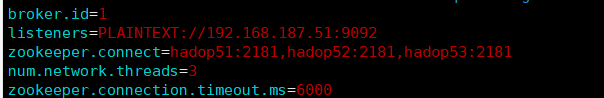

三、修改kafka配置文件

进入kafka的根目录的config: cd /opt/soft/kafka2.11/config/ 打开server.properties: vim server.properties 插入以下代码: (1)、配置 broker 的ID broker.id=1 //第一个kafka配置为 1,第二个配置为2,以此类推 (2)、打开监听端口 listeners=PLAINTEXT://192.168.195.51:9092 //尽量写ip地址,以免造成错误 (3)、修改 log 的目录、在指定的位置创建好文件夹logs log.dirs=/opt/soft/kafka2.11/logs (4)、修改 zookeeper.connect尽量写ip地址,以免造成错误(集群的机器)

zookeeper.connect=hadop51:2181,hadop52:2181,hadop53:2181

(5)、网络线程数量

num.network.threads=3

(6)Zookeeper每6秒监视kafka是否还活着

zookeeper.connection.timeout.ms=6000(默认)

![]()

四、分发到各个子节点

scp –rp /opt/soft/kafka2.11 root@hadop52: /opt/soft

scp –rp /opt/soft/kafka2.11 root@hadop53: /opt/soft

把环境变量的配置文件也分发过去:

scp –rp /etc/profile root@hadop52: /etc

scp –rp /etc/profile root@hadop53: /etc

然后在每台机器更新环境变量:

source profile

五、每台机器启动kafka之前需启动zookeeper,然后启动kafka

这里写一下启动zookeeper的命令,免得以后忘了:

zkServer.sh start

再启动kafka:

kafka-server-start.sh $KAFKA_HOME/config/server.properties & 打印日志启动

kafka-server-start.sh -daemon $KAFKA_HOME/config/server.properties & 不打印日志启动

通过jps命令查看是否启动成功

六、测试

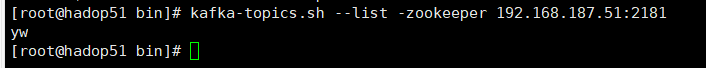

通过创建一个topic(名字为test)来测试是否能成功运行,随便选择一个节点运行:

kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic yw

列出kafka:

kafka-topics.sh --list -zookeeper 192.168.187.51:2181。有刚刚的测试topic名,表示创建成功。