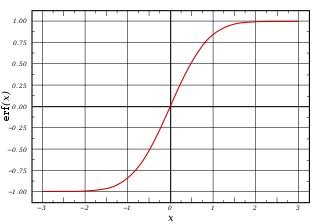

sigmoid(z):

sigmoid(z)=1/(1+exp(-z))

z为通过神经网络对样本i的计算值

样本i的最终答案要么是0,要么是1

sigmoid的函数图像为

可以看到其值域为(0,1)

sigmoid(z)表示这个样本为正样本的概率

在大部分情况下,我们的概率要么特别趋近与0,特别趋近与1。

接下来是L(y^i,yi)=L(y^i,yi)=-yi*log(y^i)+(1-yi)*log(1-y^i)

这个函数是表示y^i与yi的差距

虽然我们可以简单的用abs(y^i-yi)来表示,或者再算一个方差什么的但是这样没有放大差距

但是yi要么是0,要么是1

若yi=0

L(y^i,yi)=L(y^i,yi)=log(1-y^i)

若yi=1

L(y^i,yi)=L(y^i,yi)=-log(y^i)

这样就放大了差距

最后的函数J(W,b)=1/n*( L(y^1,y1) + L(y^2,y2) + .....+L(y^n,yn))

其实就是对训练集的每个样本求一个平均值而已这个没什么说的