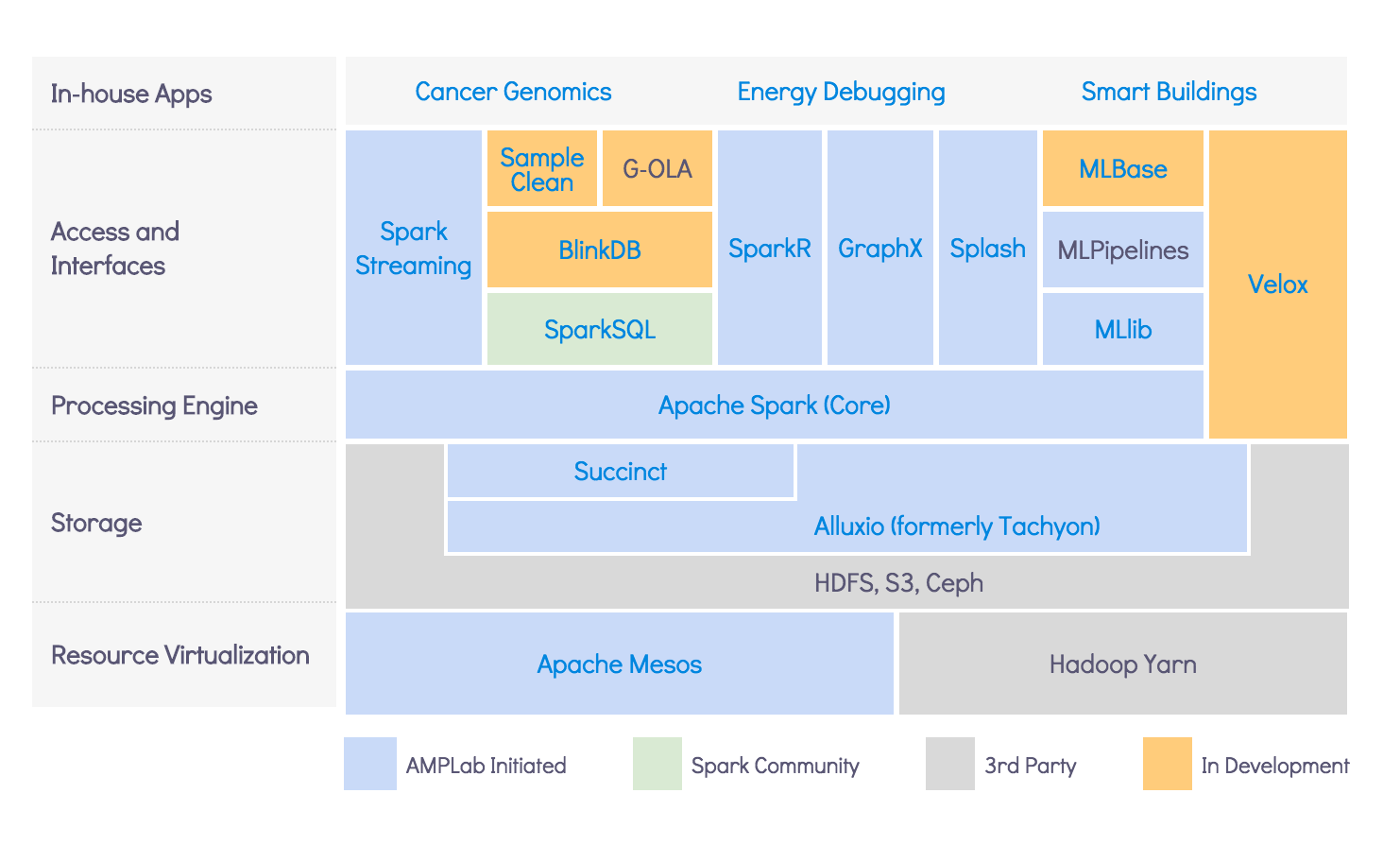

Spark组件是基于分布式资源引擎层(Yarn等)和分布式存储层(HDFS等)之上的一个组件,Spark本质上是一个计算引擎,负责计算的,根据不同计算场景划分出了SQL、Streaming、MLib、GraphX、R等模块,这些模块各自处理适合各自特点的计算场景。Spark Core作为Spark技术栈的底层,提供如Spark初始化、数据模型、远程调用、内存模型、存储体系、序列化、安全、Web UI、计算调度体系、广播变量、IO、运行模式等等的核心功能和解决各模块的公共需求,是Spark的核心层,为其他各模块提供支持服务。