本节使用docker安装FastDFS。

本节是在node01和node02两台主机上安装部署FastDFS双节点。

node01 ip:192.168.178.7 安装tracker1,storage1

node02 ip:192.168.178.10 安装tracker2,storage2

若要扩展更多tracker或storage节点,也是类似操作。

1. 拉取 fastdfs docker 镜像

docker pull morunchang/fastdfs

2. 安装fastdfs tracker

分别在node01和node02上安装tracker

在node01和node02上分别执行以下操作。

注:以下操作指令在node01中执行,在node02操作时,将tracker1改为tracker2。

(1) 创建文件夹

mkdir -p /apps/fastdfs/tracker1/data /apps/fastdfs/tracker1/conf

(2) FastDFS 跟踪器配置:tracker.conf

vim /apps/fastdfs/tracker1/conf/tracker.conf

配置文件内容

# 启动配置文件 disabled=false # 绑定IP,常用于服务器有多个IP但只希望一个IP提供服务,如果不填则表示所有的(一般不填就OK) bind_addr= # 设置tracker的端口号 port=22122 # 连接超时时间,针对socket套接字函数connect connect_timeout=30 # tracker server的网络超时,单位为秒。发送或接收数据时,如果在超时时间后还不能发送或接收数据,则本次网络通信失败。 network_timeout=30 # 设置tracker的数据文件和日志目录(需预先创建) base_path=/data/fast_data # 系统提供服务时的最大连接数。对于V1.x,因一个连接由一个线程服务,也就是工作线程数。 # 对于V2.x,最大连接数和工作线程数没有任何关系 max_connections=256 accept_threads=1 # V2.0引入的这个参数,工作线程数,通常设置为CPU数 work_threads=4 # 上传组(卷) 的方式 0:轮询方式 1: 指定组 2: 平衡负载(选择最大剩余空间的组(卷)上传) # 这里如果在应用层指定了上传到一个固定组,那么这个参数被绕过 store_lookup=2 # 当上一个参数设定为1 时 (store_lookup=1,即指定组名时),必须设置本参数为系统中存在的一个组名。 # 如果选择其他的上传方式,这个参数就没有效了。 store_group=group1 # 选择哪个storage server 进行上传操作(一个文件被上传后,这个storage server就相当于这个文件的storage server源,会对同组的storage server推送这个文件达到同步效果) # 0: 轮询方式 # 1: 根据ip 地址进行排序选择第一个服务器(IP地址最小者) # 2: 根据优先级进行排序(上传优先级由storage server来设置,参数名为upload_priority) store_server=0 # 选择storage server 中的哪个目录进行上传。storage server可以有多个存放文件的base path(可以理解为多个磁盘)。 # 0: 轮流方式,多个目录依次存放文件 # 2: 选择剩余空间最大的目录存放文件(注意:剩余磁盘空间是动态的,因此存储到的目录或磁盘可能也是变化的) store_path=0 # 选择哪个 storage server 作为下载服务器 # 0: 轮询方式,可以下载当前文件的任一storage server # 1: 哪个为源storage server 就用哪一个 (前面说过了这个storage server源 是怎样产生的) 就是之前上传到哪个storage server服务器就是哪个了 download_server=0 # storage server 上保留的空间,保证系统或其他应用需求空间。可以用绝对值或者百分比(V4开始支持百分比方式)。 # (指出 如果同组的服务器的硬盘大小一样,以最小的为准,也就是只要同组中有一台服务器达到这个标准了,这个标准就生效,原因就是因为他们进行备份) reserved_storage_space = 10% # 选择日志级别 log_level=info # 操作系统运行FastDFS的用户组 (不填 就是当前用户组,哪个启动进程就是哪个) run_by_group= # 操作系统运行FastDFS的用户 (不填 就是当前用户,哪个启动进程就是哪个) run_by_user= # 可以连接到此 tracker server 的ip范围(对所有类型的连接都有影响,包括客户端,storage server) # allow_hosts=10.0.1.[1-15,20] # allow_hosts=host[01-08,20-25].domain.com allow_hosts=* # 同步或刷新日志信息到硬盘的时间间隔,单位为秒 # 注意:tracker server 的日志不是时时写硬盘的,而是先写内存。 # 默认是10s sync_log_buff_interval = 10 # 检测 storage server 存活的时间隔,单位为秒。 # storage server定期向tracker server 发心跳,如果tracker server在一个check_active_interval内还没有收到storage server的一次心跳,那边将认为该storage server已经下线。所以本参数值必须大于storage server配置的心跳时间间隔。通常配置为storage server心跳时间间隔的2倍或3倍。 check_active_interval = 120 # 线程栈的大小。FastDFS server端采用了线程方式。更正一下,tracker server线程栈不应小于64KB,不是512KB。 # 线程栈越大,一个线程占用的系统资源就越多。如果要启动更多的线程(V1.x对应的参数为max_connections,V2.0为work_threads),可以适当降低本参数值。 thread_stack_size = 64KB # 这个参数控制当storage server IP地址改变时,集群是否自动调整。注:只有在storage server进程重启时才完成自动调整。 storage_ip_changed_auto_adjust = true # V2.0引入的参数。存储服务器之间同步文件的最大延迟时间,缺省为1天。根据实际情况进行调整 # 注:本参数并不影响文件同步过程。本参数仅在下载文件时,判断文件是否已经被同步完成的一个阀值(经验值) storage_sync_file_max_delay = 86400 # V2.0引入的参数。存储服务器同步一个文件需要消耗的最大时间,缺省为300s,即5分钟。 # 注:本参数并不影响文件同步过程。本参数仅在下载文件时,作为判断当前文件是否被同步完成的一个阀值(经验值) storage_sync_file_max_time = 300 # V3.0引入的参数。是否使用小文件合并存储特性,缺省是关闭的。 use_trunk_file = false # the min slot size, should <= 4KB # default value is 256 bytes # since V3.00 # V3.0引入的参数。 # trunk file分配的最小字节数。比如文件只有16个字节,系统也会分配slot_min_size个字节。 slot_min_size = 256 # the max slot size, should > slot_min_size # store the upload file to trunk file when it's size <= this value # default value is 16MB # since V3.00 # V3.0引入的参数。 # 只有文件大小<=这个参数值的文件,才会合并存储。如果一个文件的大小大于这个参数值,将直接保存到一个文件中(即不采用合并存储方式)。 slot_max_size = 16MB # the trunk file size, should >= 4MB # default value is 64MB # since V3.00 # V3.0引入的参数。 # 合并存储的trunk file大小,至少4MB,缺省值是64MB。不建议设置得过大。 trunk_file_size = 64MB # default value is false # 是否提前创建trunk file。只有当这个参数为true,下面3个以trunk_create_file_打头的参数才有效。 trunk_create_file_advance = false # the time format: HH:MM # default value is 02:00 # 提前创建trunk file的起始时间点(基准时间),02:00表示第一次创建的时间点是凌晨2点。 trunk_create_file_time_base = 02:00 # default value is 38400 (one day) # 创建trunk file的时间间隔,单位为秒。如果每天只提前创建一次,则设置为86400 trunk_create_file_interval = 86400 # default value is 0 # 提前创建trunk file时,需要达到的空闲trunk大小 # 比如本参数为20G,而当前空闲trunk为4GB,那么只需要创建16GB的trunk file即可。 trunk_create_file_space_threshold = 20G # trunk初始化时,是否检查可用空间是否被占用 # 默认是false trunk_init_check_occupying = false # 是否无条件从trunk binlog中加载trunk可用空间信息 # FastDFS缺省是从快照文件storage_trunk.dat中加载trunk可用空间, # 该文件的第一行记录的是trunk binlog的offset,然后从binlog的offset开始加载 trunk_init_reload_from_binlog = false trunk_compress_binlog_min_interval = 0 # 是否使用server ID作为storage server标识 use_storage_id = false # since V4.00 # use_storage_id 设置为true,才需要设置本参数 # 在文件中设置组名、server ID和对应的IP地址 storage_ids_filename = storage_ids.conf id_type_in_filename = ip # default value is false # since V4.01 # 存储从文件是否采用symbol link(符号链接)方式 # 如果设置为true,一个从文件将占用两个文件:原始文件及指向它的符号链接。 store_slave_file_use_link = false # default value is false # since V4.02 # 是否定期轮转error log,目前仅支持一天轮转一次 rotate_error_log = false # rotate error log time base, time format: Hour:Minute # Hour from 0 to 23, Minute from 0 to 59 # default value is 00:00 # since V4.02 # error log定期轮转的时间点,只有当rotate_error_log设置为true时有效 error_log_rotate_time=00:00 # rotate error log when the log file exceeds this size # 0 means never rotates log file by log file size # default value is 0 # since V4.02 # error log按大小轮转 # 设置为0表示不按文件大小轮转,否则当error log达到该大小,就会轮转到新文件中 rotate_error_log_size = 0 # 保留日志文件的天数 # 0表示不删除旧的日志文件 # default值为0 log_file_keep_days = 0 # 如果使用连接池 # default value为false # 从V4.05开始 use_connection_pool = false # 空闲时间超过此时间的连接将被关闭 # unit:秒 # 默认值为3600 # 从V4.05开始 connection_pool_max_idle_time = 3600 # HTTP服务是否不生效 http.disabled=false # 设置http端口号 http.server_port=8080 # check storage HTTP server alive interval seconds # <= 0从不检查 # 默认值为30 http.check_alive_interval=30 # check存储HTTP服务器活动类型,值为: # tcp:仅使用HTTP端口连接到storge服务器, # 不要求并得到回复 # http:storage check alive url必须返回http状态200 # default value是tcp http.check_alive_type=tcp # 注意:存储嵌入HTTP服务器支持uri:/status.html http.check_alive_uri=/status.html # use "# include" directive to include http other settiongs ## include http.conf # 如果加载http.conf的配置文件 去掉第一个#

(3) 运行tracker1的docker容器

docker run -d --name tracker1 --net=host --restart always -v /etc/localtime:/etc/localtime -v /apps/fastdfs/tracker1/data:/data/fast_data/ -v /apps/fastdfs/tracker1/conf/tracker.conf:/etc/fdfs/tracker.conf morunchang/fastdfs sh tracker.sh

(4) 查看docker日志是否启动正常

docker logs tracker1

(5) 开启防火墙端口

# 开启防火墙端口:22122 # 编辑文件:-A INPUT -p tcp -m state --state NEW -m tcp --dport 22122 -j ACCEPT vim /etc/sysconfig/iptables # 重启防火墙 systemctl restart iptables.service

3. 安装fastdfs storage

在node01和node02上安装storage。

在node01和node02上分别执行以下操作

注意:以下操作指令在node01中执行,在node02操作时,将storage1改为storage2。

(1) 创建文件夹

mkdir -p /apps/fastdfs/storage1/data /apps/fastdfs/storage1/conf

(2) FastDFS 存储配置:storage.conf

vim /apps/fastdfs/storage1/conf/storage.conf

配置内容

# false为生效,true不生效 disabled=false # 指定此 storage server 所在组(卷) # 如果注释或者删除这个参数,而从tracker那里获取分组信息 # 则 use_storage_id参数必须设为true 在 tracker.conf 配置文件中 # storage_ids.conf文件必须正确配置 group_name=group1 # 绑定ip地址,空值为主机上全部地址 # bind_addr通常是针对server的。当指定bind_addr时,本参数才有效。 # 本storage server作为client连接其他服务器(如tracker server、其他storage server),是否绑定bind_addr。 bind_addr= client_bind=true # 存储服务端口 port=23002 # 连接超时时间,针对socket套接字函数connect # 默认是30s connect_timeout=30 # storage server 网络超时时间,单位为秒。发送或接收数据时, # 如果在超时时间后还不能发送或接收数据,则本次网络通信失败 # 默认是30s network_timeout=30 # 心跳间隔时间,单位为秒 (这里是指主动向tracker server 发送心跳) heart_beat_interval=30 # storage server向tracker server报告磁盘剩余空间的时间间隔,单位为秒 stat_report_interval=60 # storage存储data和log的根路径,必须提前创建好 base_path=/data/fast_data # 服务器支持的最大并发连接 # 默认为256 # 更大的值 意味着需要使用更大的内存 max_connections=256 # 发送/接收 数据的缓冲区大小 # 此参数必须大于8KB # 设置队列结点的buffer大小。工作队列消耗的内存大小 = buff_size * max_connections # 设置得大一些,系统整体性能会有所提升。 # 消耗的内存请不要超过系统物理内存大小。另外,对于32位系统,请注意使用到的内存不要超过3GB buff_size = 256KB # 接受线程数 默认为1 accept_threads=1 # V2.0引入的这个参数,工作线程数 <=max_connections # 此参数 处理 网络的 I/O # 通常设置为CPU数 work_threads=4 # 磁盘是否 读写分离 # false为读写混合 true为读写分离 # 默认读写分离 disk_rw_separated = true # 针对每个个存储路径的读线程数,缺省值为1 # 读写混合时 此值设为0 # 读写分离时,系统中的读线程数 = disk_reader_threads * store_path_count # 读写混合时,系统中的读写线程数 = (disk_reader_threads + disk_writer_threads) * store_path_count disk_reader_threads = 1 # 针对每个个存储路径的写线程数,缺省值为1 # 读写混合时 此值设为0 # 读写分离时,系统中的写线程数 = disk_writer_threads * store_path_count # 读写混合时,系统中的读写线程数 = (disk_reader_threads + disk_writer_threads) * store_path_count disk_writer_threads = 1 # 同步文件时,如果从binlog中没有读到要同步的文件,休眠N毫秒后重新读取。0表示不休眠,立即再次尝试读取。 # 出于CPU消耗考虑,不建议设置为0。如何希望同步尽可能快一些,可以将本参数设置得小一些,比如设置为10ms # 必须 > 0, 默认值是200ms sync_wait_msec=50 # 同步上一个文件后,再同步下一个文件的时间间隔,单位为毫秒,0表示不休眠,直接同步下一个文件 sync_interval=0 # 时间格式:Hour:Minute # 存储每天同步的开始时间 (默认是00:00开始) # 一般用于避免高峰同步产生一些问题而设定 sync_start_time=00:00 # 时间格式:Hour:Minute # 存储每天同步的结束时间 (默认是23:59结束) # 一般用于避免高峰同步产生一些问题而设定 sync_end_time=23:59 # 同步完N个文件后,把storage的mark文件同步到磁盘 # 注:如果mark文件内容没有变化,则不会同步 write_mark_file_freq=500 # 存放文件时storage server支持多个路径(例如磁盘) # 这里配置存放文件的基路径数目,通常只配一个目录 store_path_count=1 # 逐一配置store_path的路径,索引号基于0。注意配置方法后面有0,1,2 ......,需要配置0到store_path - 1。 # 如果不配置base_path0,那边它就和base_path对应的路径一样。 # 路径必须存在 store_path0=/data/fast_data # N*N 个 目录会自动创建 在 每个磁盘路径下 # 值 可以设为1-256 默认256 # FastDFS存储文件时,采用了两级目录。这里配置存放文件的目录个数 (系统的存储机制) # 如果本参数只为N(如:256),那么storage server在初次运行时,会自动创建 N * N 个存放文件的子目录。 subdir_count_per_path=256 # tracker_server 的地址列表 要写端口的 (再次提醒是主动连接tracker_server ) # 有多个tracker server时,每个tracker server写一行 tracker_server=192.168.178.7:22122 tracker_server=192.168.178.10:22122 # 日志级别 log_level=debug # 操作系统运行FastDFS的用户组 (不填就是当前用户组,哪个启动进程就是哪个) run_by_group= # 操作系统运行FastDFS的用户 (不填就是当前用户,哪个启动进程就是哪个) run_by_user= # "*" means match all ip addresses, can use range like this: 10.0.1.[1-15,20] or # host[01-08,20-25].domain.com, for example: # allow_hosts=10.0.1.[1-15,20] # allow_hosts=host[01-08,20-25].domain.com # 允许连接本storage server的IP地址列表 (不包括自带HTTP服务的所有连接) # 可以配置多行,每行都会起作用 allow_hosts=* # 文件在data目录下分散存储策略。 # 0: 轮流存放,在一个目录下存储设置的文件数后(参数file_distribute_rotate_count中设置文件数),使用下一个目录进行存储。 # 1: 随机存储,根据文件名对应的hash code来分散存储 file_distribute_path_mode=0 # 当上面的参数file_distribute_path_mode配置为0(轮流存放方式)时,本参数有效。 # 当一个目录下的文件存放的文件数达到本参数值时,后续上传的文件存储到下一个目录中。 file_distribute_rotate_count=100 # 当写入大文件时,每写入N个字节,调用一次系统函数fsync将内容强行同步到硬盘。0表示从不调用fsync # 其它值表示 写入字节为此值时,调用fsync函数 fsync_after_written_bytes=0 # 同步或刷新日志信息到硬盘的时间间隔,单位为秒 # 注意:storage server 的日志信息不是时时写硬盘的,而是先写内存 sync_log_buff_interval=10 # 同步binglog(更新操作日志)到硬盘的时间间隔,单位为秒 # 本参数会影响新上传文件同步延迟时间 sync_binlog_buff_interval=10 # 把storage的stat文件同步到磁盘的时间间隔,单位为秒。 # 注:如果stat文件内容没有变化,不会进行同步 sync_stat_file_interval=300 # 线程栈的大小。FastDFS server端采用了线程方式。 # 对于V1.x,storage server线程栈不应小于512KB;对于V2.0,线程栈大于等于128KB即可。 # 线程栈越大,一个线程占用的系统资源就越多。 # 对于V1.x,如果要启动更多的线程(max_connections),可以适当降低本参数值。 thread_stack_size=512KB # 本storage server作为源服务器,上传文件的优先级 # 可以为负数。值越小,优先级越高 # 这里就和 tracker.conf 中store_server= 2时的配置相对应了 upload_priority=10 # 网卡别名前缀 在linux上 你可以通过ifconfig -a 看到它 # 多个别名需要用逗号隔开 # 空值表示根据操作系统类型自动设置 if_alias_prefix= ### 去重配置 ### # 是否检测上传文件已经存在。如果已经存在,则不存储文件内容 # FastDHT 建立一个符号链接 以节省磁盘空间。 # 这个应用要配合FastDHT 使用,所以打开前要先安装FastDHT # 1或yes 是检测, 0或no 是不检测 check_file_duplicate=0 # 检查文件重复时,文件内容的签名方式: # hash: 4个hash code # md5:MD5 file_signature_method=hash # 存储文件符号连接的命名空间 # check_file_duplicate 参数必须设置为 true / on key_namespace=FastDFS # 与FastDHT servers 的连接方式 (是否为持久连接) ,默认是0(短连接方式) # 可以考虑使用长连接(值为1),这要看FastDHT server的连接数是否够用 keep_alive=0 ### 日志配置 ### # 是否将文件操作记录到access log use_access_log = true # 是否定期轮转access log,目前仅支持一天轮转一次 rotate_access_log = false # 时间格式:Hour:Minute # access log定期轮转的时间点,只有当rotate_access_log设置为true时有效 access_log_rotate_time=00:00 # 是否定期轮转error log,目前仅支持一天轮转一次 rotate_error_log = false # 时间格式:Hour:Minute # error log定期轮转的时间点,只有当rotate_error_log设置为true时有效 error_log_rotate_time=00:00 # access log按文件大小轮转 # 设置为0表示不按文件大小轮转,否则当access log达到该大小,就会轮转到新文件中 rotate_access_log_size = 0 # error log按文件大小轮转 # 设置为0表示不按文件大小轮转,否则当error log达到该大小,就会轮转到新文件中 rotate_error_log_size = 0 # 是否保留日志文件 # 0 为不删除旧日志文件 log_file_keep_days = 0 # 文件同步的时候,是否忽略无效的binlog记录 file_sync_skip_invalid_record=false # 是否使用连接池 use_connection_pool = false # 关闭 闲置连接的 时间 # 默认3600秒 connection_pool_max_idle_time = 3600 # 如果存储服务器域名是空的 则使用ip地址 # storage server上web server域名,通常仅针对单独部署的web server # 这样URL中就可以通过域名方式来访问storage server上的文件了 # 这个参数为空就是IP地址的方式。 http.domain_name= # 存储服务器 使用的web端口 http.server_port=9101

(3) nginx配置文件

vim /apps/fastdfs/storage1/conf/nginx.conf

配置文件内容:

worker_processes 1; error_log /data/fast_data/logs/nginx-error.log; events { worker_connections 1024; } http { include mime.types; default_type application/octet-stream; log_format main '$remote_addr - $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for"'; access_log /data/fast_data/logs/nginx-access.log main; sendfile on; keepalive_timeout 65; server { #监听的端口, 与storage.conf中的http.server_port值一致 listen 9101; #nginx安装机器的ip,可以是具体的ip,也可以是localhost server_name localhost; location / { root html; index index.html index.htm; } location ~ /group1/M00 { #/data/fast_data与图片上传的路径一致 root /data/fast_data/data; ngx_fastdfs_module; } error_page 500 502 503 504 /50x.html; location = /50x.html { root html; } } }

(4) fastdfs-nginx-module 配置文件:mod_fastdfs.conf

vim /apps/fastdfs/storage1/conf/mod_fastdfs.conf

内容:

connect_timeout=30 network_timeout=30 base_path=/data/fast_data load_fdfs_parameters_from_tracker=true storage_sync_file_max_delay = 86400 use_storage_id = false storage_ids_filename = storage_ids.conf # tracker 服务器的 IP 地址以及端口号 tracker_server=192.168.178.7:22122 tracker_server=192.168.178.10:22122 # storage 服务器的端口号 storage_server_port=23002 # 当前服务器的 group 名 group_name=group1 # 文件 url 中是否有 group 名 url_have_group_name = true # 存储路径个数,需要和 store_path 个数匹配 store_path_count=1 # 存储路径 store_path0=/data/fast_data # 日志级别 log_level=info log_filename= response_mode=proxy if_alias_prefix= flv_support = true flv_extension = flv # 设置组的个数 # set the group count # set to none zero to support multi-group # set to 0 for single group only # groups settings section as [group1], [group2], ..., [groupN] # default value is 0 # since v1.14 group_count = 0 #include http.conf

(5) 写入/apps/fastdfs/storage1/conf/storage.sh

#!/bin/sh /data/fastdfs/storage/fdfs_storaged /etc/fdfs/storage.conf /etc/nginx/sbin/nginx tail -f /data/fast_data/logs/storaged.log

(6) FastDFS 客户端配置:client.conf

vim /apps/fastdfs/storage1/conf/client.conf

内容为:

# connect timeout in seconds # default value is 30s connect_timeout=30 # network timeout in seconds # default value is 30s network_timeout=30 # the base path to store log files base_path=/data/fastdfs/test # tracker_server can ocur more than once, and tracker_server format is # "host:port", host can be hostname or ip address tracker_server=192.168.178.7:22122 tracker_server=192.168.178.10:22122 #standard log level as syslog, case insensitive, value list: ### emerg for emergency ### alert ### crit for critical ### error ### warn for warning ### notice ### info ### debug log_level=info # if use connection pool # default value is false # since V4.05 use_connection_pool = false # connections whose the idle time exceeds this time will be closed # unit: second # default value is 3600 # since V4.05 connection_pool_max_idle_time = 3600 # if load FastDFS parameters from tracker server # since V4.05 # default value is false load_fdfs_parameters_from_tracker=false # if use storage ID instead of IP address # same as tracker.conf # valid only when load_fdfs_parameters_from_tracker is false # default value is false # since V4.05 use_storage_id = false # specify storage ids filename, can use relative or absolute path # same as tracker.conf # valid only when load_fdfs_parameters_from_tracker is false # since V4.05 storage_ids_filename = storage_ids.conf #HTTP settings http.tracker_server_port=80 #use "#include" directive to include HTTP other settiongs ##include http.conf

(7) 运行docker容器

docker run -d --name storage1 --net=host --restart always -v /etc/localtime:/etc/localtime -v /apps/fastdfs/storage1/data:/data/fast_data/ -v /apps/fastdfs/storage1/conf/storage.sh:/storage.sh -v /apps/fastdfs/storage1/conf/storage.conf:/etc/fdfs/storage.conf -v /apps/fastdfs/storage1/conf/nginx.conf:/etc/nginx/conf/nginx.conf -v /apps/fastdfs/storage1/conf/mod_fastdfs.conf:/etc/fdfs/mod_fastdfs.conf -v /apps/fastdfs/storage1/conf/client.conf:/data/fastdfs/conf/client.conf morunchang/fastdfs sh storage.sh

(8) 查看docker日志是否正常

docker logs storage1

(9) 开启防火墙端口:23002、9101

# 开启防火墙端口:23002、9101 # -A INPUT -p tcp -m state --state NEW -m tcp --dport 23002 -j ACCEPT # -A INPUT -p tcp -m state --state NEW -m tcp --dport 9101 -j ACCEPT vim /etc/sysconfig/iptables # 重启防火墙 systemctl restart iptables.service

4. 验证fastdfs是否安装成功

说明:以下操作在node01中进行。

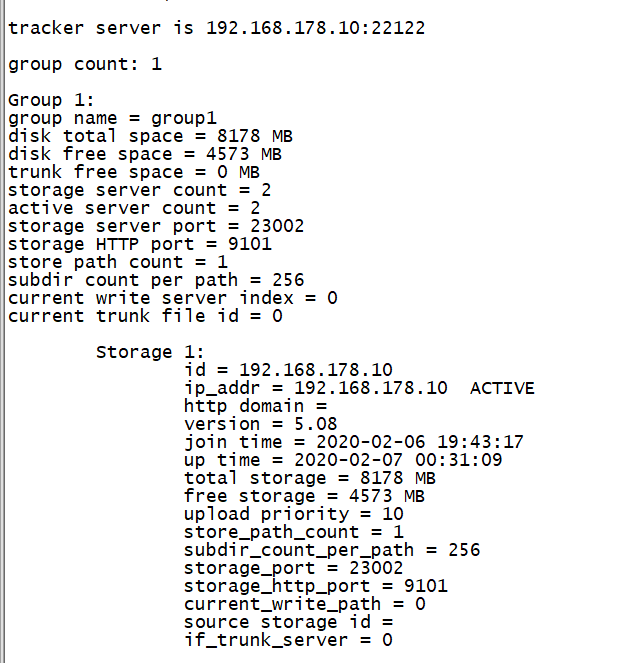

(1) 查看FastDFS监控状态

docker exec -it storage1 fdfs_monitor /data/fastdfs/conf/client.conf

参数说明:

tracker_server_count:2 --表示2个Tracker Server

tracker server is 198.168.1.121:22122 --表示Leader Tracker

group count: 1 --表示有1个group

group name = group1 --组名称是group1

storage server count = 2 --组内有2个storage

active server count = 2 --活动的storage有2个

storage server port = 23002 --storage的端口

storage HTTP port = 9101 --storage的文件访问端口

store path count = 1 --storage只挂了一个存储目录

total_upload_count = 11 --总共上传了多少个文件

total_upload_bytes = 691405 --总共上传了多少字节

success_upload_bytes = 691405 --成功上传了多少字节

total_download_count = 2 --总共下载了多少文件(使用java客户端)

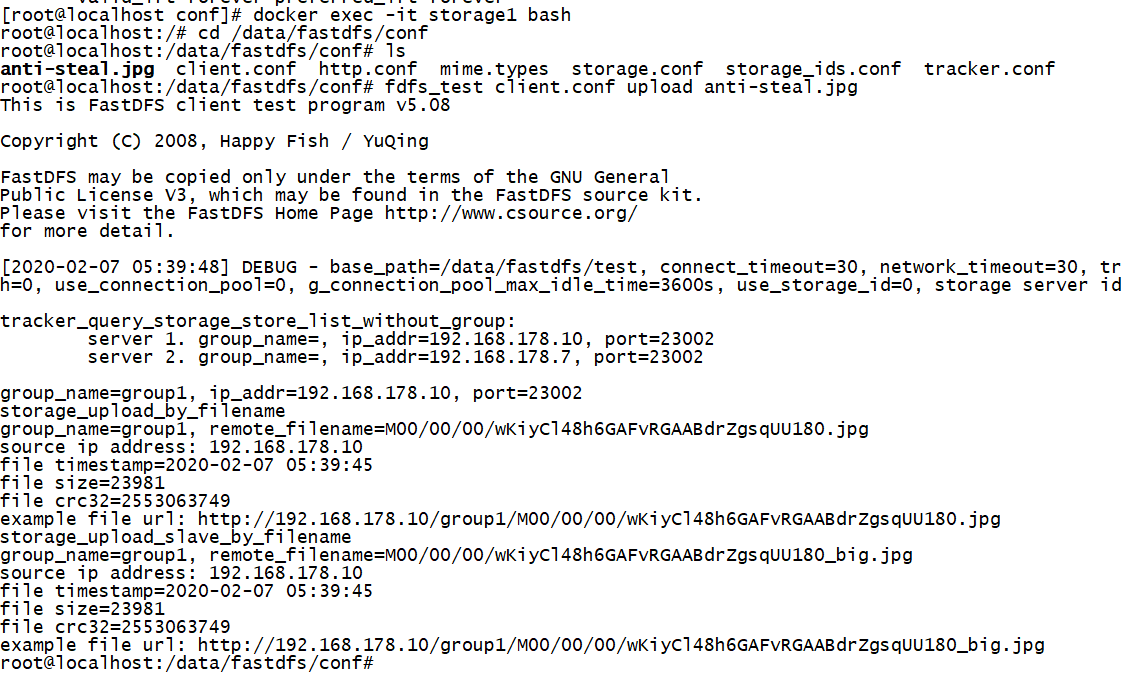

(2) 上传文件到FastDFS

docker exec -it storage1 bash cd /data/fastdfs/conf # anti-steal.jpg是/data/fastdfs/conf目录下的一个文件 fdfs_test client.conf upload anti-steal.jpg

文件上传成功后,会提示文件访问地址,同时会自动同步到storage2,因此也可以通过storage2的IP,访问文件。

由于storage1的http端口配置为9101,所以真正的访问地址是:

(示例地址)http://192.168.178.7:9101/group1/M00/00/00/wKiyC148bKSAXxjvAABdrZgsqUU172_big.jpg

storage2的访问地址是:

(示例地址)http://192.168.178.10:9101/group1/M00/00/00/wKiyC148bKSAXxjvAABdrZgsqUU172_big.jpg

(3) 下载文件

curl http://192.168.178.7:9101/group1/M00/00/00/wKiyC148bKSAXxjvAABdrZgsqUU172_big.jpg

curl http://192.168.178.10:9101/group1/M00/00/00/wKiyC148bKSAXxjvAABdrZgsqUU172_big.jpg

能下载文件就表示fastdfs同步文件成功,也表示fastdfs安装配置成功。

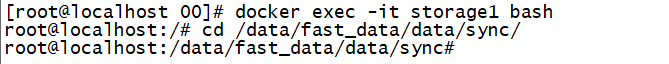

(4) 统计Storage文件数量

进入storage的data目录,执行以下指令:

cd /apps/fastdfs/storage1/data/data ls -lR|grep "^-"|wc -l

或者进入data目录下的sync目录,执行以下指令:

cat binlog.000 | wc -l

binlog.000保存了storage中所有文件名。