昨天一块osd硬盘不幸去世了,经过一番努力后新硬盘挂载进rook ceph cluster,并且ceph自动开始进行数据均衡。今天打开后发现Health是ERROR状态,难道新硬盘数据均衡出现问题了?

1、进入ceph tools pod

kubectl -n rook-ceph exec -it $(kubectl -n rook-ceph get pod -l "app=rook-ceph-tools" -o jsonpath='{.items[0].metadata.name}') bash

2、检测ceph状态

ceph health detail

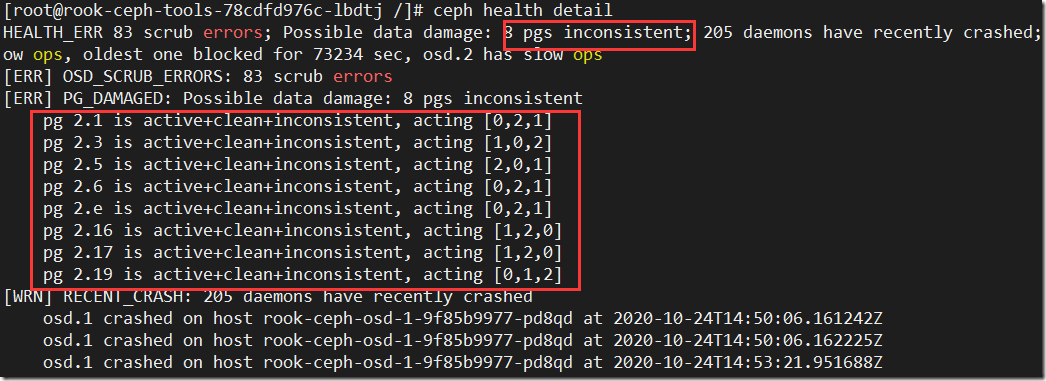

好吧,是真的出问题了,只不过这种属于小问题,8个pg不一至。但是也要及时处理不然小问题堆积的多最终也成大问题

3、使用ceph命令使数据同步,我们先对pg 2.1执行处理

ceph pg repair 2.1

ceph health detail

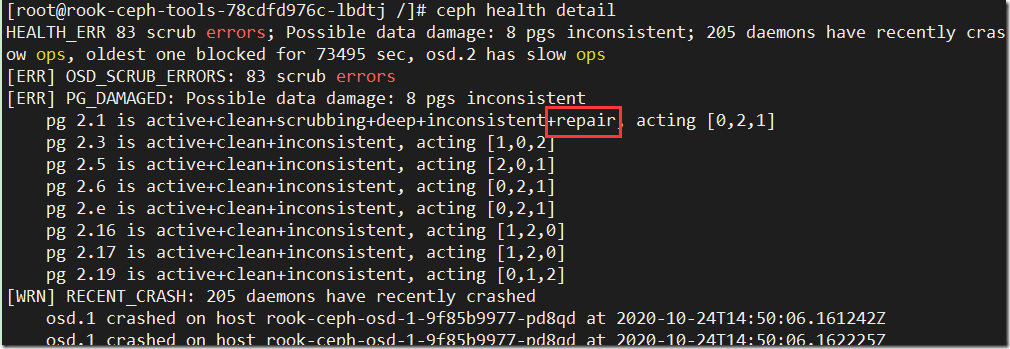

使用repair命令后,隔几秒再使用health查看就可以看到pg 2.1的状态已经有一个repair,进入数据同步状态

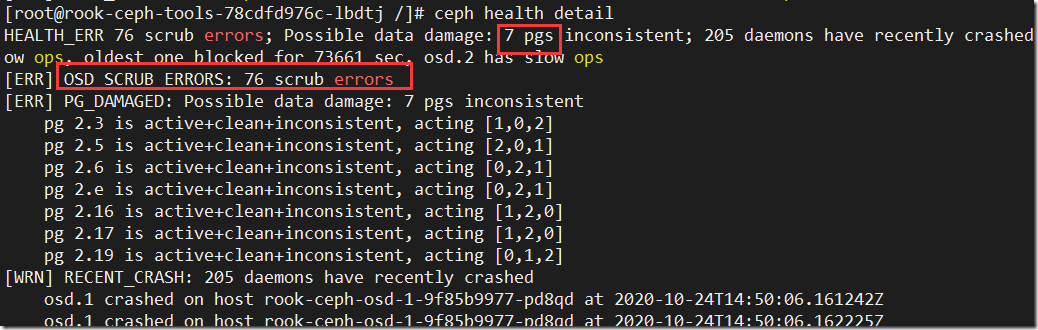

4、过段时间等待修复结束后我们再查看,发现不同步的pg已经变成了7个,有问题的scrub也减到了77个,pg 2.1也从异步列表中消失