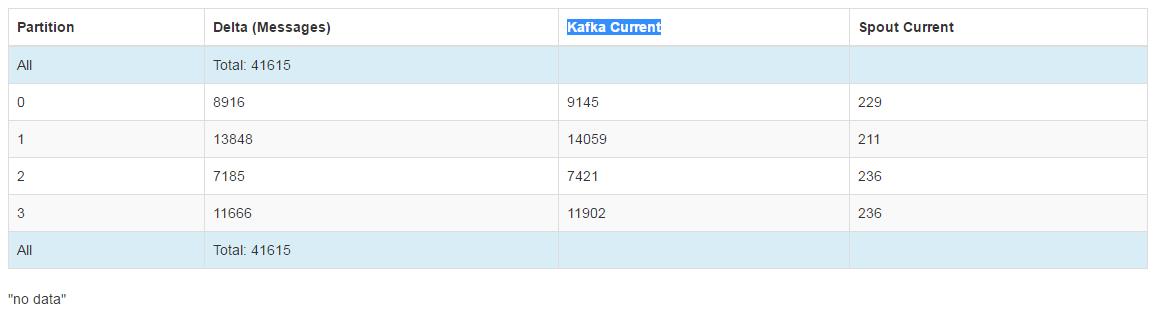

1.下面是一个topic数据出现堵塞的情况示图。

如图所示,delta列表示当前分区未处理的数据条数,kafka current表示推送到topic的数据量,spout current表示已经处理的数据量。

这种情况有几种可能:数据有问题,配置文件有问题,代码有问题,显然这些都是废话,差不多也就这几总,这里只是说一下找错的的几个方向,如果你刷新页面发现慢慢的delta变小,spout current慢慢变大,

这可能是数据量过大,处理的慢,试着把配置文件内的work改大,work根据配置文件内的bolt数量和实际work的使用情况设置。

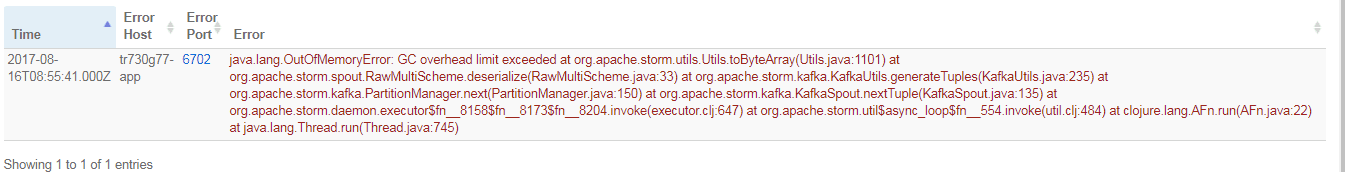

2.下面是一个strom任务出现的报错示图。

明确提示jvm内存溢出,内存不够用,应该是一次从数据库拉过来的数据量太大导致的。

修改对应的topology配置文件,调整两个参数,把他们变大。

<property>

<name>hbase.manualFlushLimit</name>

<value>1</value>

</property>

<property>

<name>hbase.writeBufferSize</name>

<value>1024</value>

</property>