Author

一作 Cristian Bucila 总共三作,都是Cornell大学的, 2006年,还有没有深度网络,都是传统的机器学习方法,以及人工神经网络

Abstract

ensemble模型很费空间,时间,而且费计算力,所以设计把大的,多个复杂模型压缩到小的,更快的模型,基本上能得到性能提升

Introduction

用人工神经网络mimic由 ensemble selection 学到的function, 为什么使用人工神经网络,因为它是通用的universal approximators, 不是在原始的小数据集上训练,而是由原始的ensemble模型来标记大量的unlabel数据,然后让神经网络在这个大数据集上训练,也就是让神经网络做出的预测与ensemble 模型相似,比神经网络直接在原始的小数据集上训练得到的效果好很多

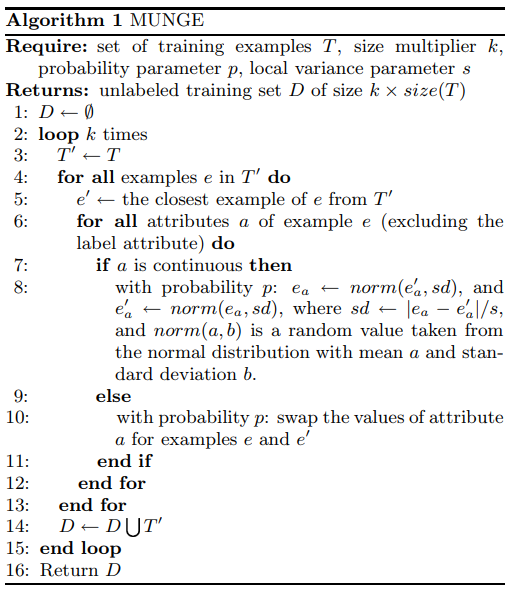

唯一的困难是需要大量的未标记数据,提出了一个新的方法合成新数据 MUNGE, 使用新的数据,我们可以用千分之一小的模型和千倍的速度训练模型,得到与大模型近似的性能。

Model Compression

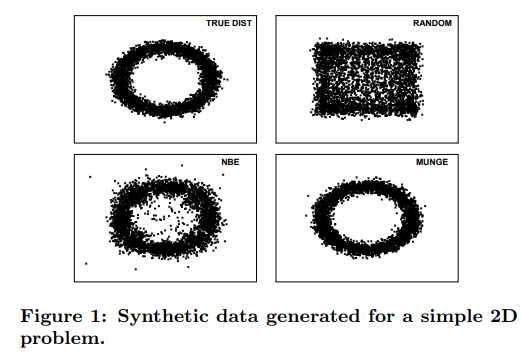

被mimic的模型是已知的. 如何产生大量的额pseudo data: Random, NBE(Naive Bayes Estimation) 本文提出的MUNGE