看了论文,我一直对于1X1卷积核不理解,因为它看起来只是将原来的矩阵分别乘了一个数,原来的矩阵并没有变化

看了一篇博文以后,理解了1X1卷积核的意义

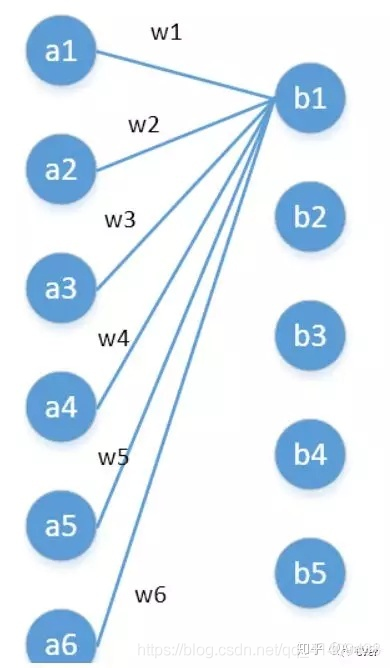

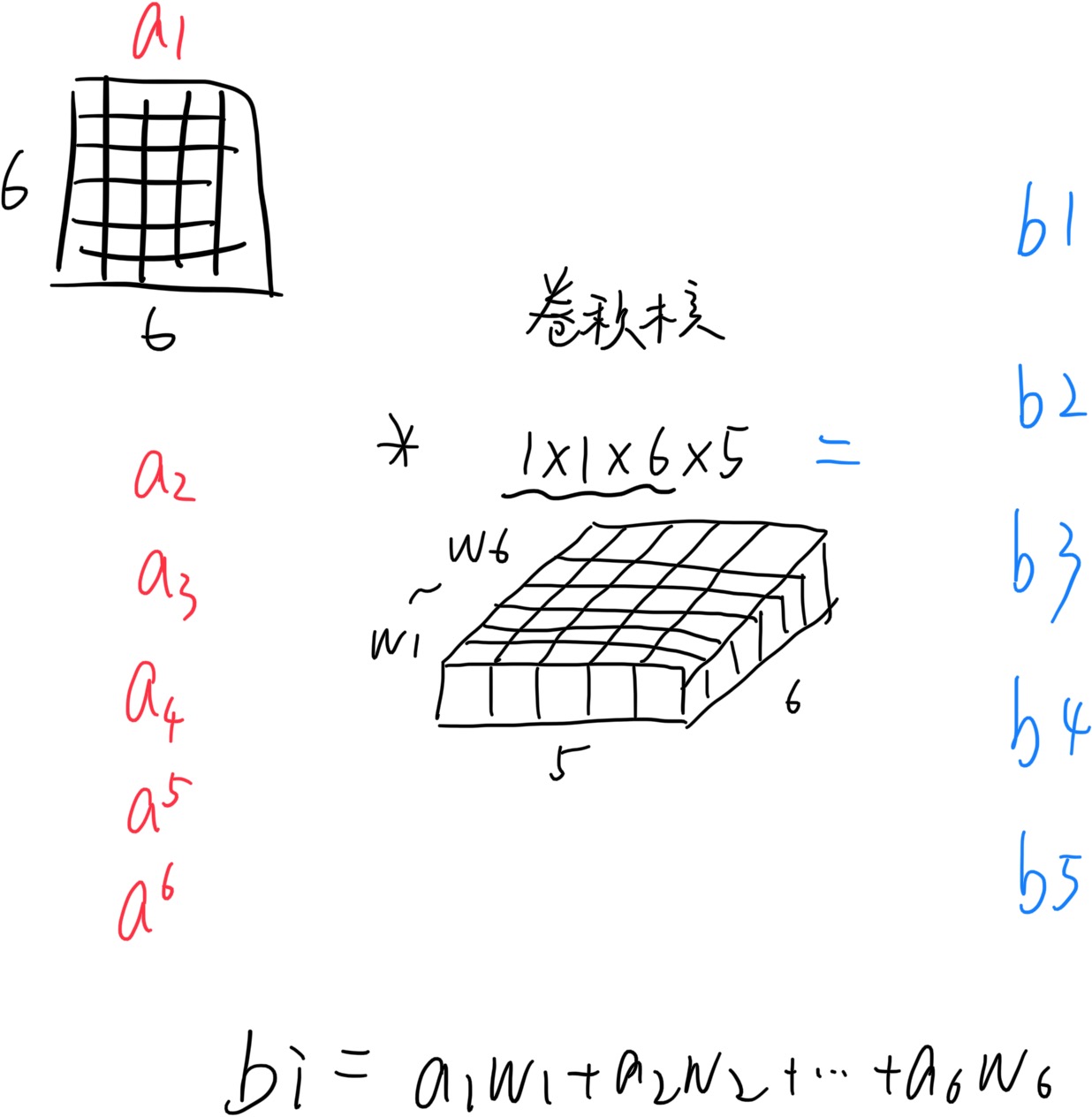

其实1x1卷积,可以看成一种全连接(full connection)。例如,

第一层有6个神经元,分别是a1—a6,通过全连接之后变成5个,分别是b1—b5,第一层的六个神经元要和后面五个实现全连接,本图中只画了a1—a6连接到b1的示意,可以看到,在全连接层b1其实是前面6个神经元的加权和,权对应的就是w1—w6,到这里就很清晰了。第一层的6个神经元其实就相当于输入特征里面那个通道数:6,而第二层的5个神经元相当于1*1卷积之后的新的特征通道数:5。 w1—w6是一个卷积核的权系数,若要计算b2—b5,显然还需要4个同样尺寸的卷积核。

作用:

降维/升维

增加非线性

跨通道信息交互

参考:https://blog.csdn.net/qq_41409438/article/details/105376075?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522160519439819195264724907%2522%252C%2522scm%2522%253A%252220140713.130102334..%2522%257D&request_id=160519439819195264724907&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~sobaiduend~default-4-105376075.pc_v1_rank_blog_v1&utm_term=1X1%E5%8D%B7%E7%A7%AF%E6%A0%B8&spm=1018.2118.3001.4450