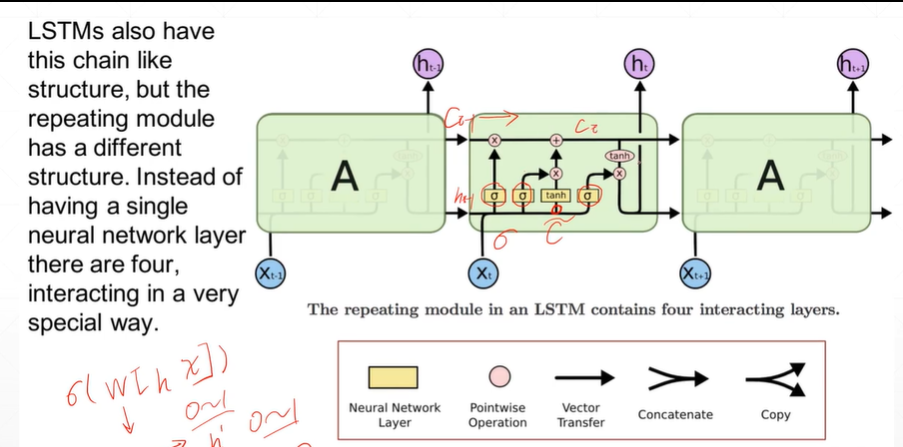

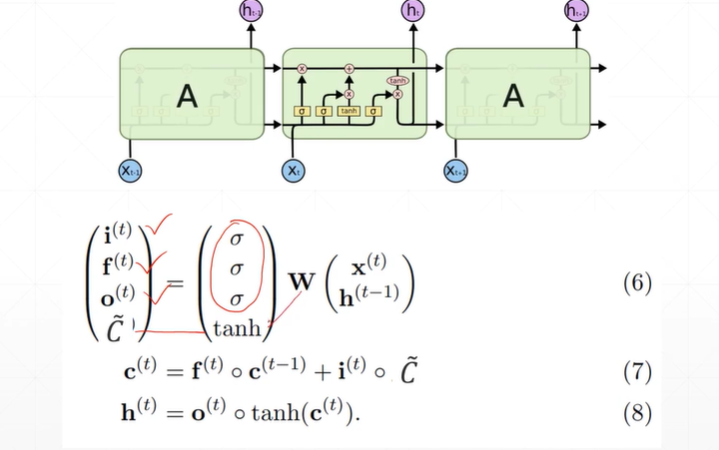

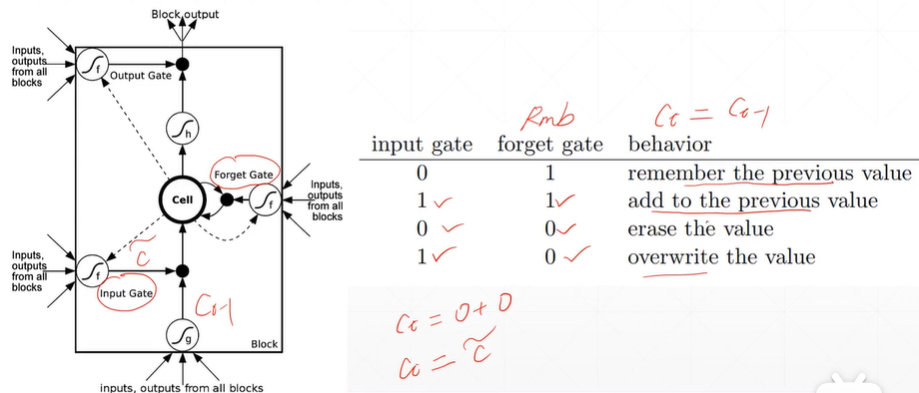

1:LSTM记忆单元

2:LSTM记忆单元的3道门

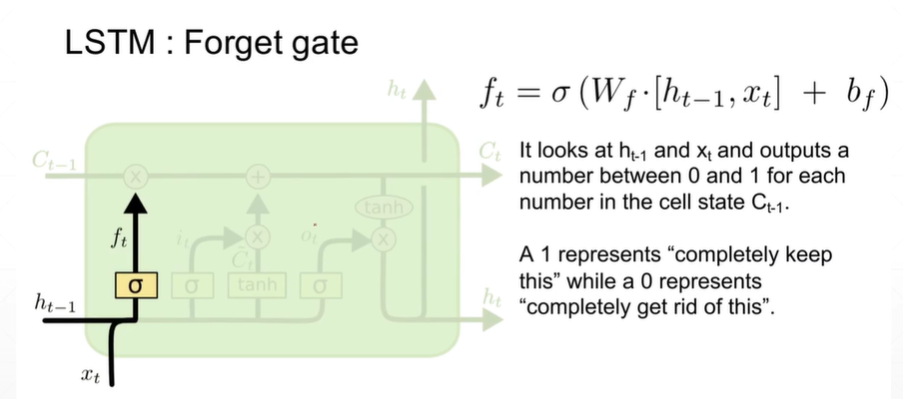

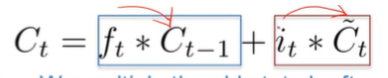

(2.1)遗忘门

[注]f_t是遗忘门(可以理解为记忆单元的保留门)的开度由于经过了sigmoid函数取值在[0,1]之间。σ为sigmoid函数

【注】 为记忆单元(注:记忆单元不再是h_t)

为记忆单元(注:记忆单元不再是h_t)

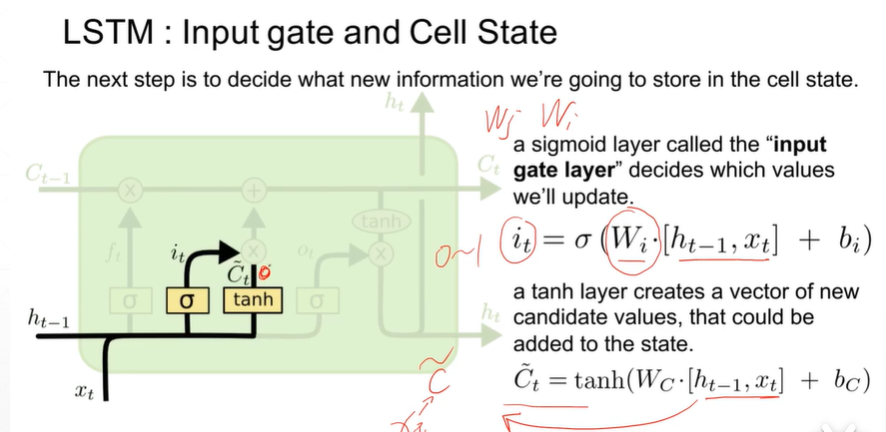

(2.2)输入门

【注】i_t为输入门的开度,取值在【0,1】之间。σ为sigmoid函数

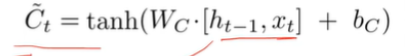

【注】 为新的输入(注:新的输入来自x_t但是不是x_t)

为新的输入(注:新的输入来自x_t但是不是x_t)

(2.3)输出门

[注] 为输出门。记忆单元的内容会有选择的输出。

为输出门。记忆单元的内容会有选择的输出。

[注]o_t为输出门的开度取值在【0,1】之间,σ为sigmoid函数。

3:LSTM表达式表达3道门

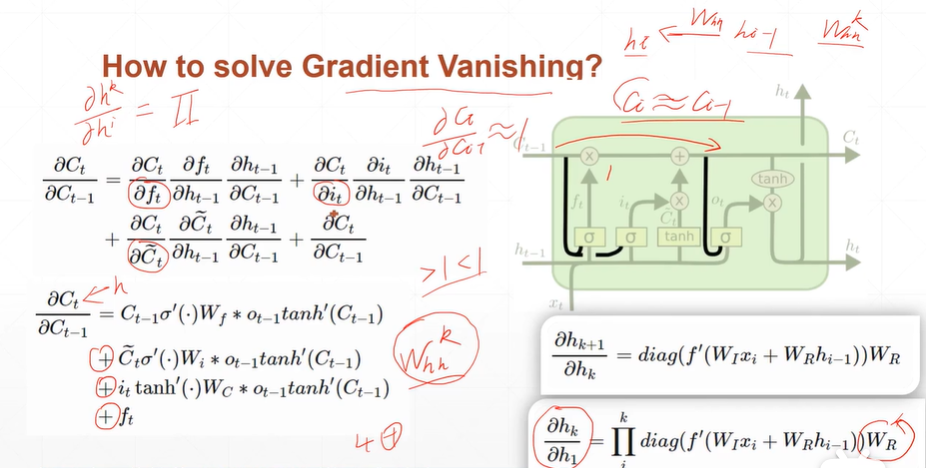

4:如何解决了梯度消失的情况?

[注]从数学角度:消除了Whh**k的出现,从逻辑的角度:是h_t不再是通过Whh的累积,而是有选择的进行。当遗忘门的开度为0时,Ct==Ct-1。