一、申请注册科大用户和下载SDK(里面的appid要和自己的一样才可以使用)

详细步骤就不写了,注册网址:http://www.xfyun.cn

二、注册完之后,点击创建应用-选择要使用的平台和选择自己所要实现的功能,点击下载sdk即可。

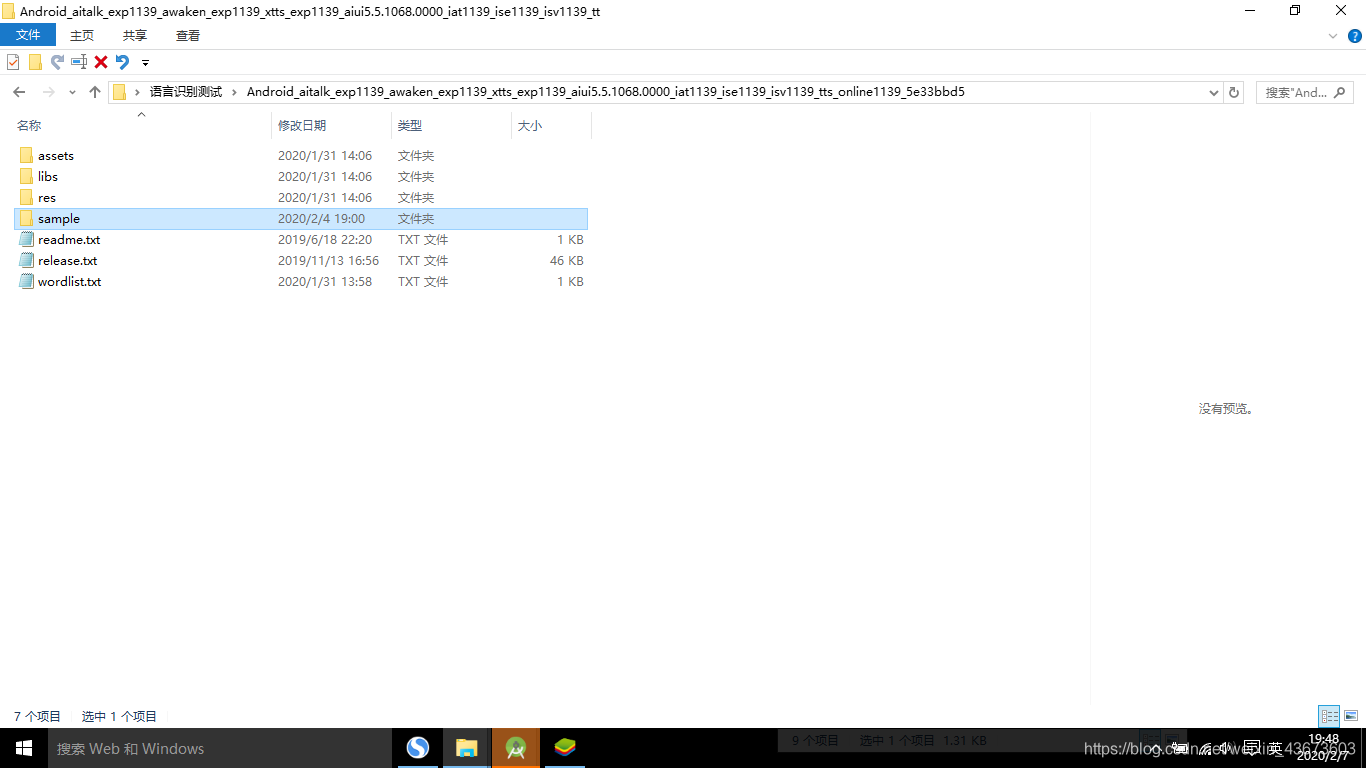

下载完解压压缩包如下图:

三、把sample里面的demo通过我们的开发工具打开,我用的是androidStudio,所以导入步骤为:

方法一(导入project方式):

打开Android Studio,在菜单栏File—>new—>import project当前解压sdk路径,使用离线服务能力选择导入mscV5PlusDemo,导入成功之后sync编译下,编译无误可连接手机,开启手机USB开发调试模式,直接在Android Studio运行导入的mscV5PlusDemo,最后生成的apk可直接安装在对应的手机上,如果编译时出现“ERROR: Plugin with id ‘com.android.application’ not found.”错误,请在build.gradle文件中添加以下代码。

buildscript {

repositories {

google()

jcenter()

}

dependencies {

//版本号请根据自己的gradle插件版本号自行更改

classpath 'com.android.tools.build:gradle:3.4.0'

// NOTE: Do not place your application dependencies here; they belong

// in the individual module build.gradle files

}

}

方法二(导入module方式):

打开Android Studio,在菜单栏File—>new—>import module当前解压sdk路径,使用离线服务能力选择导入mscV5PlusDemo,导入成功之后sync编译下,编译无误可连接手机,开启手机USB开发调试模式,直接在Android Studio运行导入的mscV5PlusDemo,最后生成的apk可直接安装在对应的手机上。

至此利用官方提供的例子我们可以感受一下语言识别的魅力,而下面我们我们可以通过参考官方的例子来进行开发。

自我开发

一、创建一个新工程:

创建一个新的空项目。

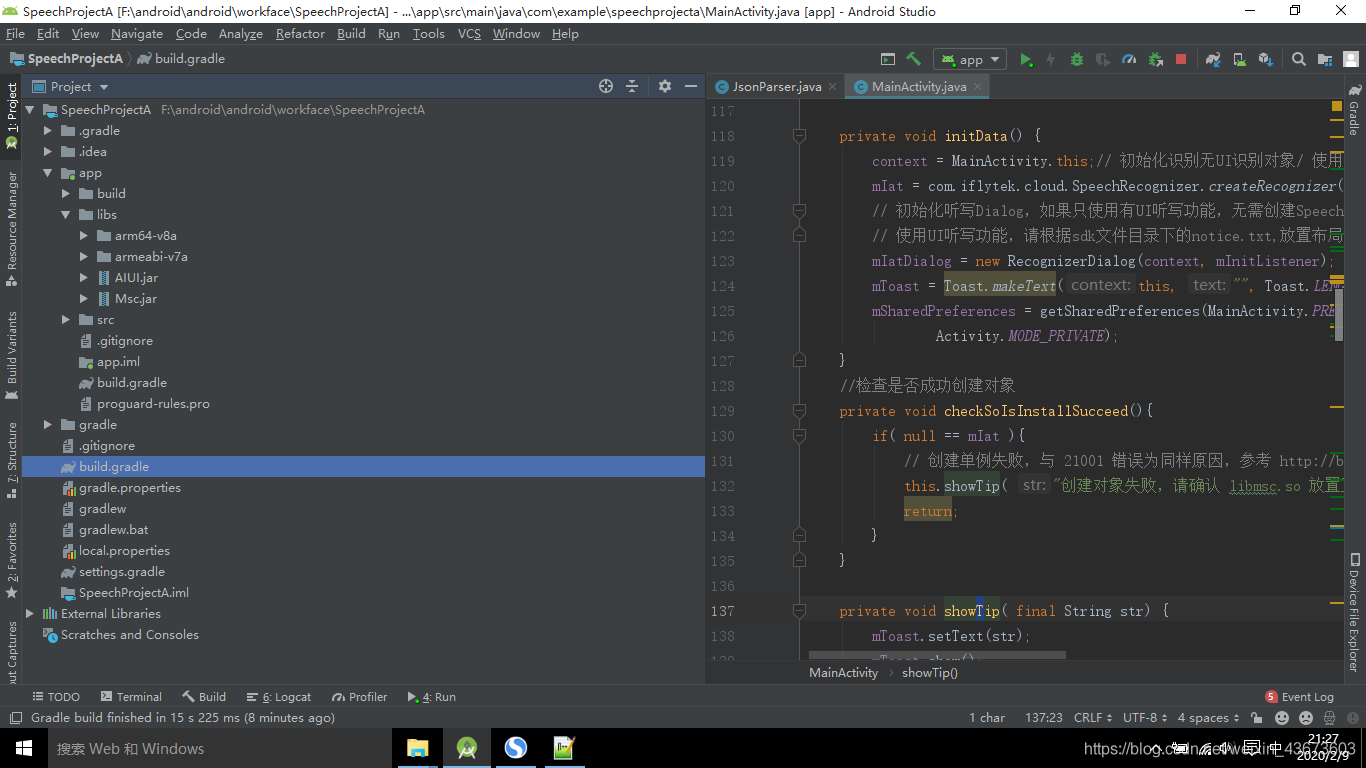

二、创建以下目录结构:

将下载好的SDK中 libs 目录下的 Msc.jar包引入到工程中(参见http://blog.csdn.net/highboys/article/details/51549679,此外,因为本Demo中会用到json的东西,所以还得自己去网上下一个Gson的jar包,一并引进去)。之后在main目录下新建一个jniLibs目录,将 SDK中 libs 目录下的armeabi 拷进去:

权限以及所需包:(Manifest文件)

<?xml version="1.0" encoding="utf-8"?>

<manifest xmlns:android="http://schemas.android.com/apk/res/android"

package="com.example.speechprojecta">

<uses-permission android:name="android.permission.RECORD_AUDIO" />

<uses-permission android:name="android.permission.INTERNET" />

<uses-permission android:name="android.permission.ACCESS_NETWORK_STATE" />

<uses-permission android:name="android.permission.ACCESS_WIFI_STATE" />

<uses-permission android:name="android.permission.CHANGE_NETWORK_STATE" />

<uses-permission android:name="android.permission.READ_PHONE_STATE" />

<uses-permission android:name="android.permission.ACCESS_FINE_LOCATION" />

<uses-permission android:name="android.permission.READ_CONTACTS" />

<uses-permission android:name="android.permission.WRITE_EXTERNAL_STORAGE" />

<uses-permission android:name="android.permission.READ_EXTERNAL_STORAGE" />

<application

android:name=".MyApplication"

android:allowBackup="true"

android:icon="@mipmap/ic_launcher"

android:label="@string/app_name"

android:roundIcon="@mipmap/ic_launcher_round"

android:supportsRtl="true"

android:theme="@style/AppTheme">

<activity android:name=".MainActivity">

<intent-filter>

<action android:name="android.intent.action.MAIN" />

<category android:name="android.intent.category.LAUNCHER" />

</intent-filter>

</activity>

</application>

</manifest>

LogUtil类:

package com.example.speechprojecta;

import android.text.TextUtils;

import android.util.Log;

class LogUtil {

public static String tagPrefix = "";

public static boolean showV = true;

public static boolean showD = true;

public static boolean showI = true;

public static boolean showW = true;

public static boolean showE = true;

public static boolean showWTF = true;

/**

* 得到tag(所在类.方法(L:行))

* @return

*/

private static String generateTag() {

StackTraceElement stackTraceElement = Thread.currentThread().getStackTrace()[4];

String callerClazzName = stackTraceElement.getClassName();

callerClazzName = callerClazzName.substring(callerClazzName.lastIndexOf(".") + 1);

String tag = "%s.%s(L:%d)";

tag = String.format(tag, new Object[]{callerClazzName, stackTraceElement.getMethodName(), Integer.valueOf(stackTraceElement.getLineNumber())});

//给tag设置前缀

tag = TextUtils.isEmpty(tagPrefix) ? tag : tagPrefix + ":" + tag;

return tag;

}

public static void v(String msg) {

if (showV) {

String tag = generateTag();

Log.v(tag, msg);

}

}

public static void v(String msg, Throwable tr) {

if (showV) {

String tag = generateTag();

Log.v(tag, msg, tr);

}

}

public static void d(String msg) {

if (showD) {

String tag = generateTag();

Log.d(tag, msg);

}

}

public static void d(String msg, Throwable tr) {

if (showD) {

String tag = generateTag();

Log.d(tag, msg, tr);

}

}

public static void i(String msg) {

if (showI) {

String tag = generateTag();

Log.i(tag, msg);

}

}

public static void i(String msg, Throwable tr) {

if (showI) {

String tag = generateTag();

Log.i(tag, msg, tr);

}

}

public static void w(String msg) {

if (showW) {

String tag = generateTag();

Log.w(tag, msg);

}

}

public static void w(String msg, Throwable tr) {

if (showW) {

String tag = generateTag();

Log.w(tag, msg, tr);

}

}

public static void e(String msg) {

if (showE) {

String tag = generateTag();

Log.e(tag, msg);

}

}

public static void e(String msg, Throwable tr) {

if (showE) {

String tag = generateTag();

Log.e(tag, msg, tr);

}

}

public static void wtf(String msg) {

if (showWTF) {

String tag = generateTag();

Log.wtf(tag, msg);

}

}

public static void wtf(String msg, Throwable tr) {

if (showWTF) {

String tag = generateTag();

Log.wtf(tag, msg, tr);

}

}

}

主activity:

package com.example.speechprojecta;

import androidx.appcompat.app.AppCompatActivity;

import android.app.Activity;

import android.content.Context;

import android.content.SharedPreferences;

import android.os.Bundle;

import android.os.Environment;

import android.view.View;

import android.widget.Button;

import android.widget.EditText;

import android.widget.Toast;

import com.iflytek.cloud.ErrorCode;

import com.iflytek.cloud.InitListener;

import com.iflytek.cloud.RecognizerListener;

import com.iflytek.cloud.RecognizerResult;

import com.iflytek.cloud.SpeechConstant;

import com.iflytek.cloud.SpeechError;

import com.iflytek.cloud.SpeechRecognizer;

import com.iflytek.cloud.ui.RecognizerDialog;

import com.iflytek.cloud.ui.RecognizerDialogListener;

import org.json.JSONException;

import org.json.JSONObject;

import java.util.ArrayList;

import java.util.HashMap;

import java.util.LinkedHashMap;

public class MainActivity extends AppCompatActivity {

private Context context;//public static final String PREFER_NAME = "com.voice.recognition";

public static final String PREFER_NAME = "com.example.speechprojecta";// 语音听写对象

private SpeechRecognizer mIat;// 语音听写UI

private RecognizerDialog mIatDialog;// 用HashMap存储听写结果

private HashMap<String, String> mIatResults = new LinkedHashMap<String, String>();

private Toast mToast;

private Button btStart,btStop,btCancel;

private EditText etContent;

private SharedPreferences mSharedPreferences;

private int ret = 0; // 函数调用返回值// 引擎类型

private String mEngineType = SpeechConstant.TYPE_CLOUD;

/**

* 初始化监听器。

*/

private InitListener mInitListener = new InitListener() {

@Override

public void onInit(int code) {

LogUtil.v("SpeechRecognizer init() code = " + code);

if (code != ErrorCode.SUCCESS) {

showTip("初始化失败,错误码:" + code);

}

}

};

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

initData();

findViewById();

setOnclickListener();//按钮点击事件处理

}

private void setOnclickListener() {

//开始监听按钮事件

btStart.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

checkSoIsInstallSucceed();

etContent.setText(null);// 清空显示内容

mIatResults.clear();

// 设置参数

setParam();

boolean isShowDialog = mSharedPreferences.getBoolean(

getString(R.string.pref_key_iat_show), true);

if (isShowDialog) {

// 显示听写对话框

mIatDialog.setListener(mRecognizerDialogListener);

mIatDialog.show();

showTip(getString(R.string.text_begin));

} else {

// 不显示听写对话框

ret = mIat.startListening(mRecognizerListener);

if (ret != ErrorCode.SUCCESS) {

showTip("听写失败,错误码:" + ret);

} else {

showTip(getString(R.string.text_begin));

}

}

}

});

btStop.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

checkSoIsInstallSucceed();

}

});

btCancel.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

checkSoIsInstallSucceed();

}

});

}

private void findViewById(){

btStart = (Button) findViewById(R.id.btn_start);

btStop = (Button) findViewById(R.id.btn_stop);

btCancel = (Button) findViewById(R.id.btn_cancel);

etContent = (EditText) findViewById(R.id.et_content);

}

private void initData() {

context = MainActivity.this;// 初始化识别无UI识别对象/ 使用SpeechRecognizer对象,可根据回调消息自定义界面;

mIat = com.iflytek.cloud.SpeechRecognizer.createRecognizer(context, mInitListener);

// 初始化听写Dialog,如果只使用有UI听写功能,无需创建SpeechRecognizer

// 使用UI听写功能,请根据sdk文件目录下的notice.txt,放置布局文件和图片资源

mIatDialog = new RecognizerDialog(context, mInitListener);

mToast = Toast.makeText(this, "", Toast.LENGTH_SHORT);

mSharedPreferences = getSharedPreferences(MainActivity.PREFER_NAME,

Activity.MODE_PRIVATE);

}

//检查是否成功创建对象

private void checkSoIsInstallSucceed(){

if( null == mIat ){

// 创建单例失败,与 21001 错误为同样原因,参考 http://bbs.xfyun.cn/forum.php?mod=viewthread&tid=9688

this.showTip( "创建对象失败,请确认 libmsc.so 放置正确,且有调用 createUtility 进行初始化" );

return;

}

}

private void showTip( final String str) {

mToast.setText(str);

mToast.show();

}

//设置参数

public void setParam() {

mIat.setParameter(SpeechConstant.PARAMS, null); // 清空参数

mIat.setParameter(SpeechConstant.ENGINE_TYPE, mEngineType); // 设置听写引擎

mIat.setParameter(SpeechConstant.RESULT_TYPE, "json"); // 设置返回结果格式

String lag = mSharedPreferences.getString("iat_language_preference",

"mandarin");

if (lag.equals("en_us")) {

// 设置语言

mIat.setParameter(SpeechConstant.LANGUAGE, "en_us");

} else {

// 设置语言

mIat.setParameter(SpeechConstant.LANGUAGE, "zh_cn");

// 设置语言区域

mIat.setParameter(SpeechConstant.ACCENT, lag);

}

// 设置语音前端点:静音超时时间,即用户多长时间不说话则当做超时处理

mIat.setParameter(SpeechConstant.VAD_BOS, mSharedPreferences.getString("iat_vadbos_preference", "4000"));

// 设置语音后端点:后端点静音检测时间,即用户停止说话多长时间内即认为不再输入, 自动停止录音

mIat.setParameter(SpeechConstant.VAD_EOS, mSharedPreferences.getString("iat_vadeos_preference", "1000"));

// 设置标点符号,设置为"0"返回结果无标点,设置为"1"返回结果有标点

mIat.setParameter(SpeechConstant.ASR_PTT, mSharedPreferences.getString("iat_punc_preference", "1"));

// 设置音频保存路径,保存音频格式支持pcm、wav,设置路径为sd卡请注意WRITE_EXTERNAL_STORAGE权限

// 注:AUDIO_FORMAT参数语记需要更新版本才能生效

mIat.setParameter(SpeechConstant.AUDIO_FORMAT,"wav");

mIat.setParameter(SpeechConstant.ASR_AUDIO_PATH, Environment.getExternalStorageDirectory()+"/msc/iat.wav");

}

//识别回调函数

private RecognizerDialogListener mRecognizerDialogListener = new RecognizerDialogListener() {

public void onResult(RecognizerResult results, boolean isLast) {

printResult(results);

String text1 = JsonParser.parseIatResult(results.getResultString());

System.out.println(text1);

String tt="开灯";

// Toast.makeText(context, text1, Toast.LENGTH_LONG).show();

if (text1.equals(tt)){

Toast.makeText(context,"ninhao",Toast.LENGTH_SHORT).show();

}

}

/**

* 识别回调错误.

*/

public void onError(SpeechError error) {

showTip(error.getPlainDescription(true));

}

};

/**

* 听写监听器。

*/

private RecognizerListener mRecognizerListener = new RecognizerListener() {

@Override

public void onBeginOfSpeech() {

// 此回调表示:sdk内部录音机已经准备好了,用户可以开始语音输入

showTip("开始说话");

}

@Override

public void onError(SpeechError error) {

// Tips:

// 错误码:10118(您没有说话),可能是录音机权限被禁,需要提示用户打开应用的录音权限。

// 如果使用本地功能(语记)需要提示用户开启语记的录音权限。

showTip(error.getPlainDescription(true));

}

@Override

public void onEndOfSpeech() {

// 此回调表示:检测到了语音的尾端点,已经进入识别过程,不再接受语音输入

showTip("结束说话");

}

@Override

public void onResult(RecognizerResult results, boolean isLast) {

LogUtil.v(results.getResultString());

printResult(results);

if (isLast) {

// TODO 最后的结果

}

}

@Override

public void onVolumeChanged(int volume, byte[] data) {

showTip("当前正在说话,音量大小:" + volume);

LogUtil.v("返回音频数据:"+data.length);

}

@Override

public void onEvent(int eventType, int arg1, int arg2, Bundle obj) {

// 以下代码用于获取与云端的会话id,当业务出错时将会话id提供给技术支持人员,可用于查询会话日志,定位出错原因

// 若使用本地能力,会话id为null

// if (SpeechEvent.EVENT_SESSION_ID == eventType) {

// String sid = obj.getString(SpeechEvent.KEY_EVENT_SESSION_ID);

// Log.d(TAG, "session id =" + sid);

// }

}

};

//打印听写识别结果

private void printResult(RecognizerResult results) {

String text = JsonParser.parseIatResult(results.getResultString());

String sn = null;

// 读取json结果中的sn字段

try {

JSONObject resultJson = new JSONObject(results.getResultString());

sn = resultJson.optString("sn");

} catch (JSONException e) {

e.printStackTrace();

}

mIatResults.put(sn, text);

StringBuffer resultBuffer = new StringBuffer();

for (String key : mIatResults.keySet()) {

resultBuffer.append(mIatResults.get(key));

}

etContent.setText(resultBuffer.toString());

etContent.setSelection(etContent.length());

}

@Override

protected void onDestroy() {

super.onDestroy();

if (null != mIat) {

// 退出时释放连接

mIat.cancel();

mIat.destroy();

}

}

}

识别效果:

ps:请使用真机测试。测试时要连网,这个是联网识别的。

实现功能:点击按钮识别语音,如果识别到开灯关键字,则出现Toast提示。