【系统环境】

【安装配置概要】

1、上传hadoop安装文件到主节点机器

2、给文件夹设置权限

3、解压

4、拷贝到目标文件夹

放在/opt文件夹下,目录结构:/opt/hadoop/hadoop-2.6.4

5、配置hadoop系统环境变量

6、配置相关文件:hadoop-env.sh、core-site.xml、hdfs-site.xml,mapred-site.xml、yarn-site.xml、slaves

7、使用scp 拷贝传输hadoop文件夹到其它两台从节点机器上

8、使用scp 拷贝环境变量配置文件到其它两台从节点机器上

9、格式化namenode

10、测试检查

【详细步骤】

1、启用SecureCRT,分别连接主节点和两台从节点机器,以hadoop账号登录主节点master,切换到hadoop账号根目录下

cd ~

rz

浏览并上传hadoop-2.6.4.tar.gz文件

2、1)、解压,解压到hadoop账号根目录下

tar -zxvf hadoop-2.6.4.tar.gz

2)、放到/opt文件夹下,文件夹结构:/opt/hadoop/hadoop-2.6.4,建立/opt/hadoop文件夹

cd /opt

mkdir hadoop

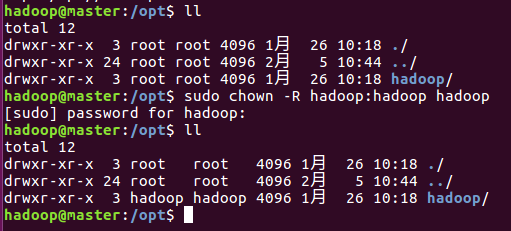

3)、先给/opt文件夹设置权限

sudo chown -R hadoop:hadoop opt

在两台从节点上也分别以hadoop账号登录,设置/opt文件夹的操作权限,不然,后面由主节点拷贝hadoop文件到从节点机器上会权限不够

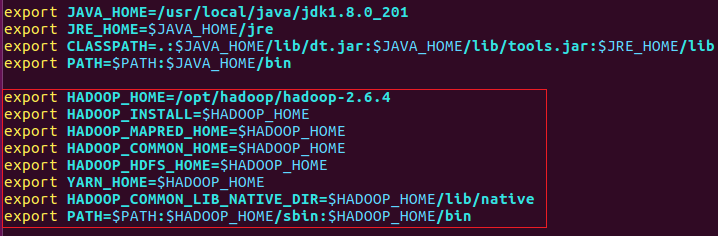

4、配置hadoop的环境变量

vi /etc/profile

增加:

export HADOOP_HOME=/opt/hadoop/hadoop-2.6.4

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

如下图:

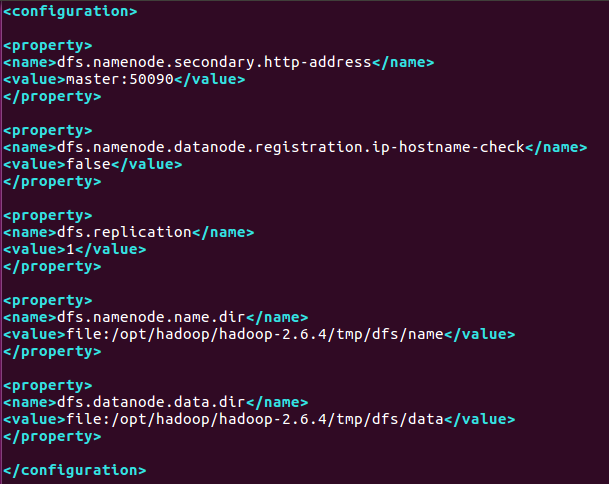

5.配置hadoop相关配置文件

1)、配置hadoop-env.sh

把export JAVA_HOME=${JAVA_HOME}注释掉,改成实际d路径 如下

2)、编辑core-site.xml

3)、编辑hdfs-site.xml

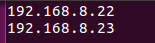

4)、编辑slaves

把从节点的IP地址写到这个文件里

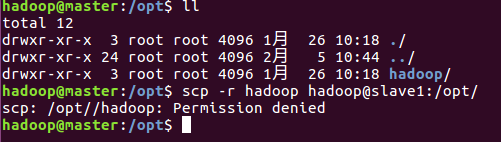

6、使用scp拷贝已经配置好的hadoop文件到其它两台从节点机器上

scp -r hadoop hadoop@slave1:/opt/

报没有权限,需先设置权限

Chown -R hadoop:hadoop hadoop

sudo chown -R 用户名@用户组 目录名

7、在主节点上配置hadoop的环境变量

vi /etc/profile

export JAVA_HOME=/usr/local/java/jdk1.8.0_201

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/opt/hadoop/hadoop-2.6.4

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

8、使用scp拷贝环境变量配置文件到其它两台从节点机器上

scp /etc/profile hadoop:slave1:/etc

并登陆从节点机器,启用环境变量配置

source /etc/profile

使用java -version进行检查

9、格式化namenode

在宿主机上输入:hadoop namenode -format

10、测试检查

1)、输入jps

在主节点:

在从节点:

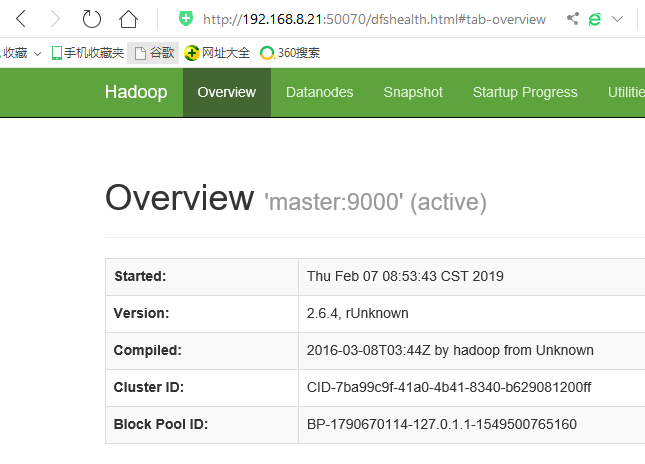

2)、在宿主机浏览器输入:http://master IP:50070

至此,Hadoop的完全分布式环境安装配置完毕。