循环神经网络总结

一、总结

一句话总结:

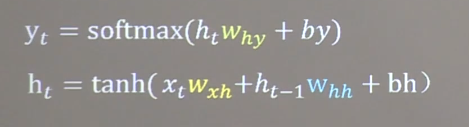

$$y _ { t } = operatorname { softmax } ( h _ { t } w _ { h y } + b y )$$

$$h _ { t } = anh ( x _ { t } w _ { x h } + h _ { t - 1 } w _ { h h } + bh )$$

1、循环神经网络这两个公式如何理解?

|||-begin

$$y _ { t } = operatorname { softmax } ( h _ { t } w _ { h y } + b y )$$

$$h _ { t } = anh ( x _ { t } w _ { x h } + h _ { t - 1 } w _ { h h } + bh )$$

|||-end

就是y=激活(wx+b),只不过对循环神经网络,是 之前状态节点的信息加上当前状态节点的信息,很简单的

二、循环神经网络总结

博客对应课程的视频位置:

其实真的挺简单的,就上面一个图,下面的两个公式,真的很简单

$$y _ { t } = operatorname { softmax } ( h _ { t } w _ { h y } + b y )$$

$$h _ { t } = anh ( x _ { t } w _ { x h } + h _ { t - 1 } w _ { h h } + bh )$$

-------------------------------------

公式仔细的想想其实也很简单:

就是y=wx+b,对应这里的话,就是当前状态的y加上之前状态的y,b的话就合在一起了,

所以是x_t*w_xh+h_(t-1)*w_hh+bh

当前状态:x_t*w_xh

之前状态:h_(t-1)*w_hh

h_(t-1)就是上一轮y,也就是这一轮的x

最后就是加个tanh激活函数,真的非常简单

就是之前状态节点的信息加上当前状态节点的信息

-------------------------------------

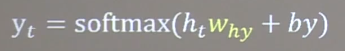

这个公式就更加简单了

y=激活(wx+b)

-------------------------------------

这里可以总结一下:

无论是全连接、还是卷积、还是循环神经网络,基本节点的话都特别简单,

都是y=激活(wx+b)

-------------------------------------

实例