一、前述

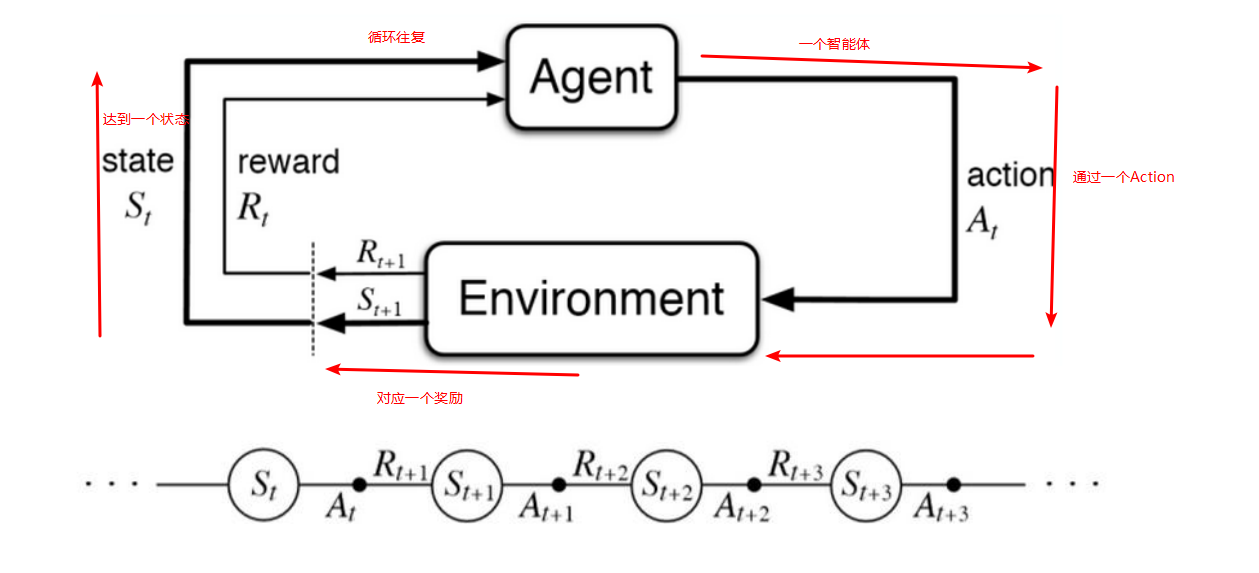

强化学习是学习一个最优策略(policy),可以让本体(agent)在特定环境(environment)中,根据当前的状态(state),做出行动(action),从而获得最大回报(G or return)。

通俗点说:学习系统没有像很多其它形式的机器学习方法一样被告知应该做出什么行为,必须在尝试了之后才能发现哪些行为会导致奖励的最大化,当前的行为可能不仅仅会影响即时奖励,还会影响下一步的奖励以及后续的所有奖励。

二、具体

1、相关定义

智能体 (agent):我们要操控的实物。比如上述中的车。

状态 (state):当前什么样的环境状态。

行为 (action):下一步的操作。

奖励:对不同的操作结果,都有衡量指标,一个奖励值。

策略:一系列相关行为的组合达到最大的一个奖励值,就是一个策略。

强化学习的过程:先行动,再观察 再行动 再观测…

每一个动作(action)都能影响代理将来的状态(state),通过一个标量的奖励(reward)信号来衡量成功,目标:选择一系列行动来最大化未来的奖励。

小车举例:

马尔科夫决策要求:

1.能够检测到理想的状态

2.可以多次尝试

3.系统的下个状态只与当前状态信息有关,而与更早之前的状态无关

在决策过程中还和当前采取的动作有关

马尔科夫决策过程由5个元素构成:

过程:

1.智能体初始状态为S0

2.选择一个动作a0

3.按概率转移矩阵Psa转移到了下一个状态S1

然后。。。

状态价值函数:

Bellman方程: 当前状态的价值和下一步的价值及当前的奖励(Reward)有关价值函数分解为当前的奖励和下一步的价值两部分,类似递归。

在某个状态(state)下最优价值函数的值,就是智能体(agent)在该状态下,所能获得的累积期望奖励值(cumulative expective rewards)的最大值.