1、初始化集群

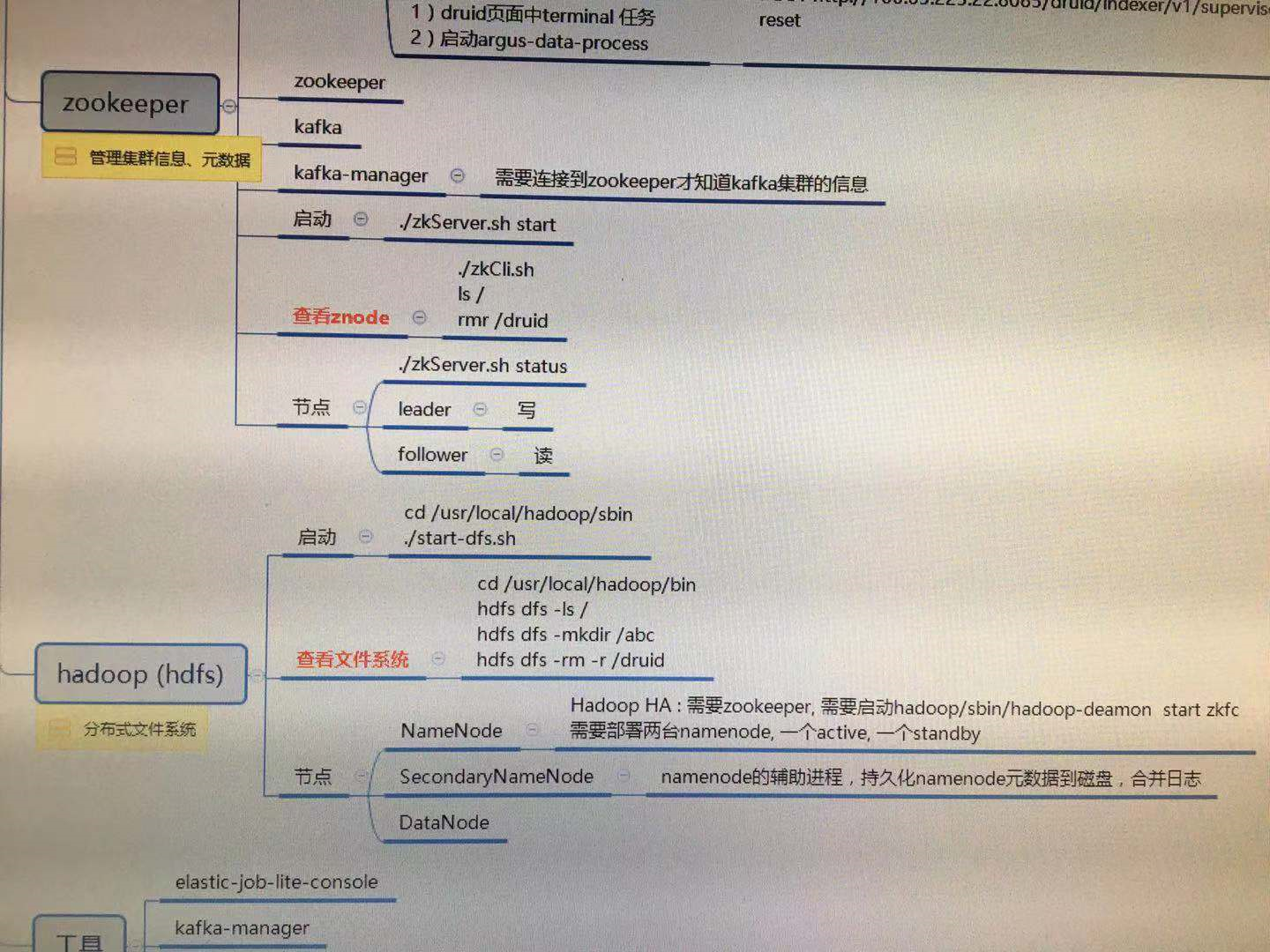

要启动Hadoop集群,需要启动HDFS和YARN两个集群

注意:首次启动HDFS时,必须对其进行格式化操作。本质上是一些清理和准备工作, 因为此时的HDFS在物理上还是不存在的

命令:hdfs namenode -format或hadoop namenode -format

(拓展:多初始化了一次会导致datanode启动失败,解决办法:https://blog.csdn.net/gis_101/article/details/52679914)

cd /usr/local/hadoop/sbin

1)单个节点逐个启动

在主节点上使用以下命令启动HDFS NameNode:

Hadoop-daemon.sh start namenode

在每个从节点上使用以下命令启动HDFS DataNode:

Hadoop-daemon.sh start datanode

2)脚本一键启动

如果配置了etc/hadoop/slaves和ssh免密登陆,则可以实用程序脚本启动所有Hadoop两个集群的相关进程,在主节点上所设定的机器上执行

hdfs:hadoop-2.7.6/sbin/(在sbin目录下执行)start-dfs.sh