说明:该集群的搭建是为了服务于solr集群,请参考我的关于solr集群搭建的博客。

1、创建solr-cloud目录

mkdir /usr/local/solr-cloud

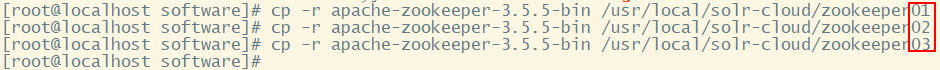

2、将解压的apache-zookeeper-3.5.5-bin复制三份到solr-cloud目录中

cp -r apache-zookeeper-3.5.5-bin /usr/local/solr-cloud/zookeeper01

cp -r apache-zookeeper-3.5.5-bin /usr/local/solr-cloud/zookeeper02

cp -r apache-zookeeper-3.5.5-bin /usr/local/solr-cloud/zookeeper03

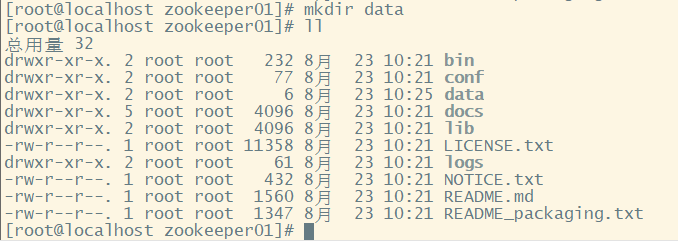

3、进入zookeeper01目录,创建data目录,用于存放zookeeper的数据文件

mkdir data

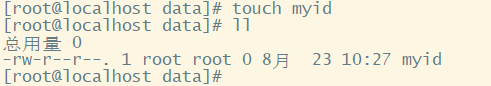

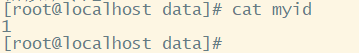

4、进入data目录,创建myid文件,代表着节点的编号

touch myid

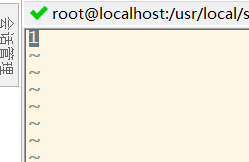

5、编辑myid文件

写入数字1

6、进入conf目录

cp zoo_sample.cfg zoo.cfg

7、编辑zoo.cfg文件

修改dataDir路径为/usr/local/solr-cloud/zookeeper01/data

修改端口clientPort为2182(之前搭建的单机版使用了2181端口)

在文件的最下方加入以下内容:节点列表

server.1=192.168.83.102:2881:3881

server.2=192.168.83.102:2882:3882

server.3=192.168.83.102:2883:3883

说明:clientPort=2182:zookeeper连接客户端的端口号,2881为各节点之间通信的端口号。3881:节点之间投票选举的端口号

8、进入zookeeper02目录

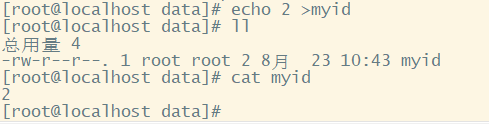

创建data目录,并进入,同样创建myid。在这里使用新的方式创建

echo 2 >myid

9、进入conf目录,复制zoo.cfg文件

cp zoo_sample.cfg zoo.cfg

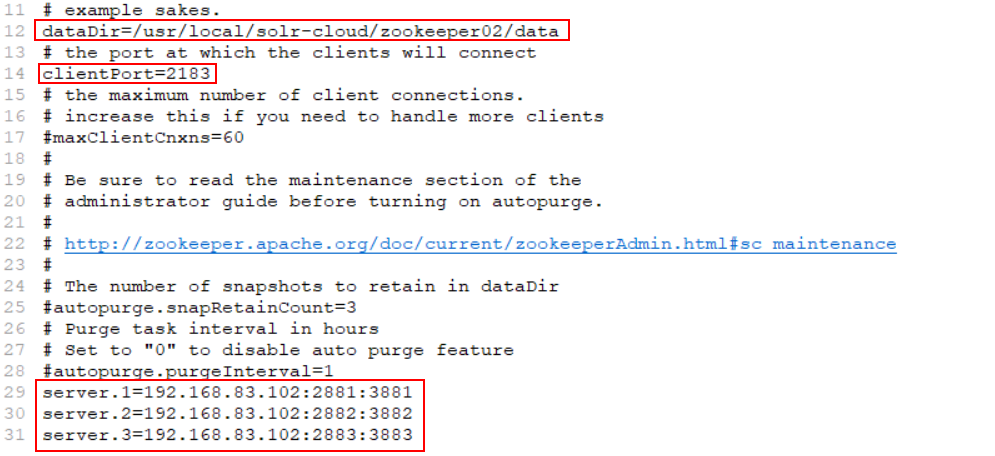

10、编辑zoo.cfg文件

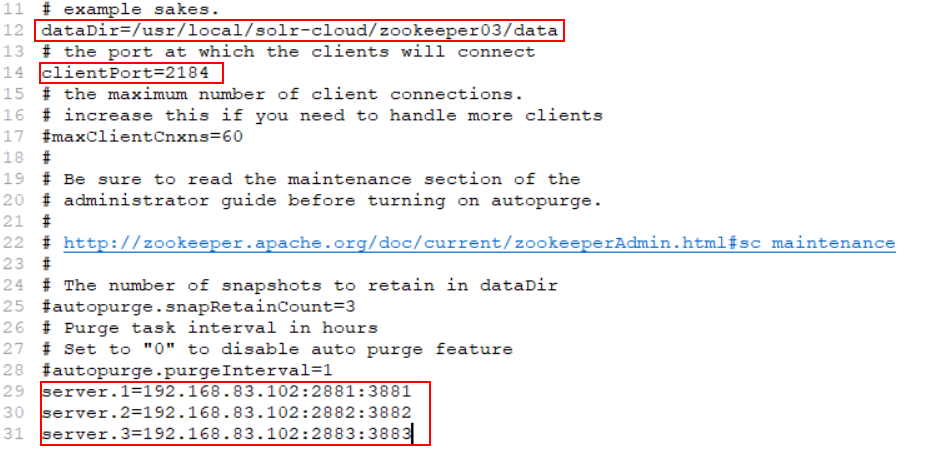

11、进入zookeeper03目录,创建data目录,在data目录中创建myid文件,赋值为3,创建zoo.cfg文件,编辑。操作参考前两步。

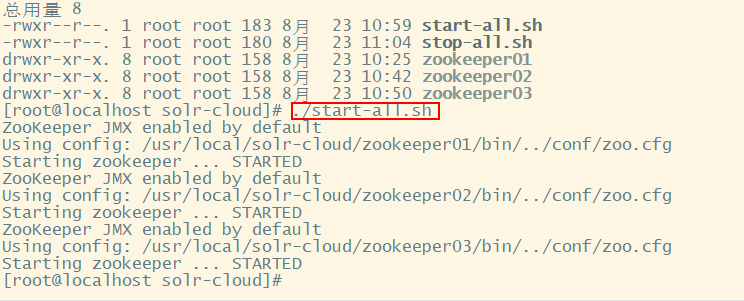

12、启动3个zookeeper节点

在solr-cloud目录下创建启动脚本

vim start-all.sh

写入以下内容

cd /usr/local/solr-cloud/zookeeper01/bin

./zkServer.sh start

cd /usr/local/solr-cloud/zookeeper02/bin

./zkServer.sh start

cd /usr/local/solr-cloud/zookeeper03/bin

./zkServer.sh start

修改脚本权限

chmod u+x start-all.sh

复制启动脚本,命名为stop-all.sh,写入以下内容

cd /usr/local/solr-cloud/zookeeper01/bin

./zkServer.sh stop

cd /usr/local/solr-cloud/zookeeper02/bin

./zkServer.sh stop

cd /usr/local/solr-cloud/zookeeper03/bin

./zkServer.sh stop

启动脚本

./start-all.sh

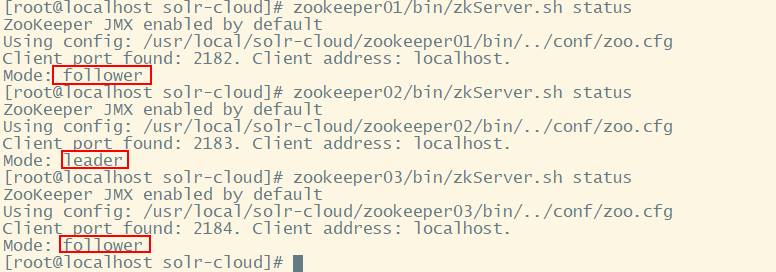

13、查看状态

[root@localhost solr-cloud]# zookeeper01/bin/zkServer.sh status

[root@localhost solr-cloud]# zookeeper02/bin/zkServer.sh status

[root@localhost solr-cloud]# zookeeper03/bin/zkServer.sh status

至此,zookeeper集群已经搭建完成,用法与单机版相同。