由于需求,要把这两个软件进行连接。

SSH服务重启后出现问题

但是重启主机,namenode和重启了奴隶机,datanode之后发现ssh 又出现了问题。

cat /var/log/secure 后又发现了问题。主要问题是,TMD奴隶机重启以后,/etc/hosts 文件居然有问题。

那些地址出错了,所以改回来后,使用 service sshd restart 之后又好了。

于是运行命令:

start-dfs.sh start-yarn.sh mr-jobhistory-daemon.sh start historyserver

kettle安装与hadoop安装以及它们的相互连接。

kettle 6.1 下载之后。

会可能需要修改一下,那个kettle里面的 spoon.bat 文件。

貌似把1024 修改变小之后才能运行,spoon.bat的文件。运行成功以后就是连接hadoop了。

(PS 这个kettle 是在windows 环境下,所以估计hadoop也会是windows 环境下的)

关键还得知道,VM虚拟机的地址以及相关HADOOP的端口号。

其实可以知道,但是由于我的WIN10 主机IP 地址和 虚拟机的固定IP 地址不是同一个网段的。

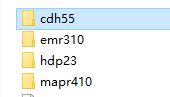

所以我PING不通,另外存在版本问题,我下载的KETTLE 6.1支持的是

这几个版本的HADOOP,然后把hadoop 下面etc/hadoop 的相关xml 文件去替换之后。填上IP 地址和

端口号应该就可以了。但是现在我去改虚拟机的IP,很麻烦,还得改HOSTS。