Redis集群(cluster)

通常,为了提高网站响应速度,总是把热点数据保存在内存中而不是直接从后端数据库中读取。Redis是一个很好的Cache工具。大型网站应用,热点数据量往往巨大,几十G上百G是很正常的事儿。由于内存大小的限制,使用一台 Redis 实例显然无法满足需求,这时就需要使用多台 Redis作为缓存数据库。但是如何保证数据存储的一致性呢,这时就需要搭建redis集群.采用合理的机制,保证用户的正常的访问需求.采用redis集群,可以保证数据分散存储,同时保证数据存储的一致性.并且在内部实现高可用的机制.实现了服务故障的自动迁移.

搭建redis集群

1. 集群搭建计划

主从划分:

3台主机 3台从机共6台 端口划分7000-7005 (为了测试方便, 用6个不同端口的redis进程来代替6台redis服务器)

2. 创建测试目录

创建一个cluster目录, 并在cluster目录中创建6个子目录, 目录名为7000 ~ 7005

3. 配置文件

为了减少配置文件修改量, 我们先修改一个配置文件, 然后复制到其他目录, 改变其端口即可

首先复制redis.conf文件到7000目录中, 然后开始编辑配置文件

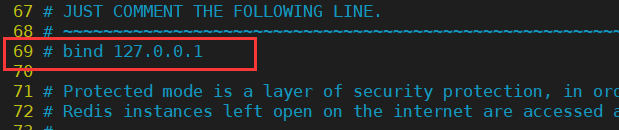

1.注释本地绑定IP地址

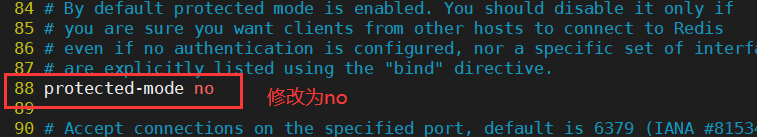

2.关闭保护模式

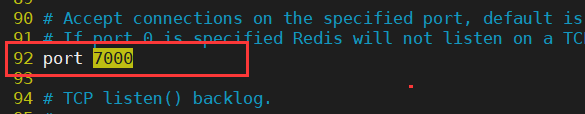

3.修改端口号

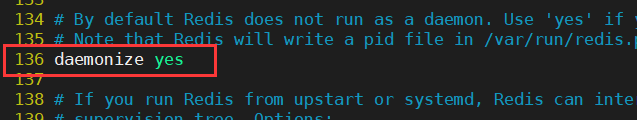

4.启动后台启动

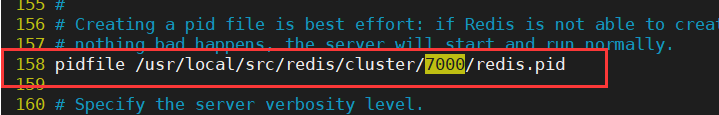

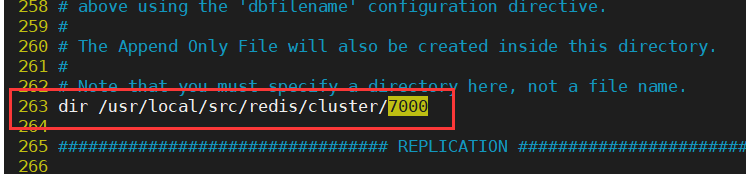

5.修改pid文件

6.修改持久化文件路径

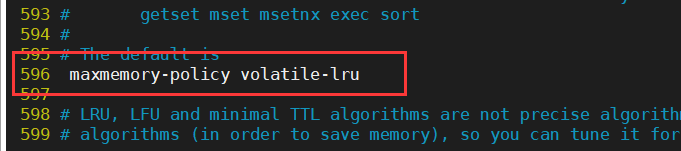

7.设定内存优化策略

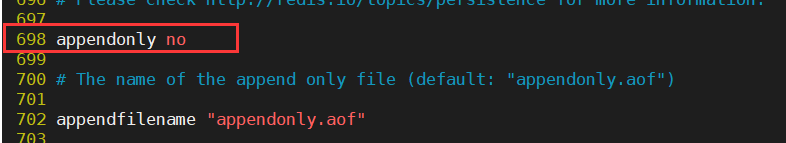

8.关闭AOF模式 (可选, 为了测试方便, 建议关闭AOF模式)

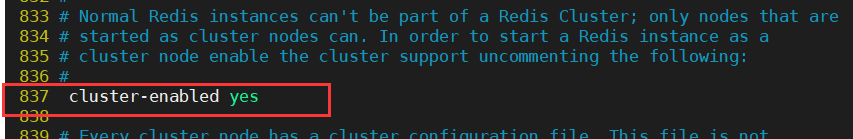

9.开启集群配置

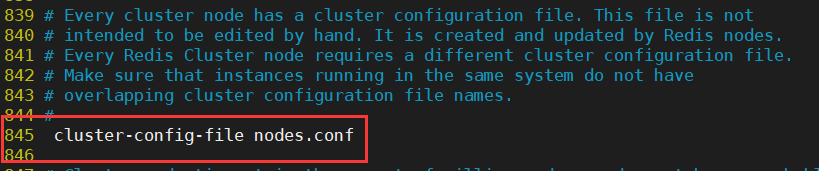

10.开启集群配置文件

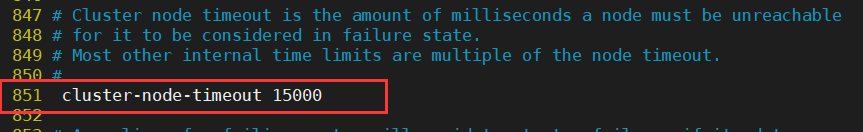

11.修改集群超时时间

修改完成后将7000中的配置文件依次复制到 7001 ~ 7005 目录中

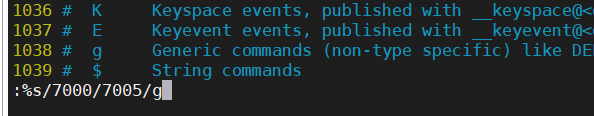

然后分别打开7001 ~ 7005 中的配置文件, 使用查找替换的方式, 分别将7000端口替换为每个目录对应的端口

使用vim查找替换例如: :%s/7000/7001/g

4. 通过脚批量启动/关闭redis

在cluster目录中创建 start.sh 脚本文件, 写入如下内容, 用于批量启动redis

#!/bin/sh

redis-server 7000/redis.conf &

redis-server 7001/redis.conf &

redis-server 7002/redis.conf &

redis-server 7003/redis.conf &

redis-server 7004/redis.conf &

redis-server 7005/redis.conf &

再创建stop.sh脚本文件, 写入如下内容, 用于批量关闭redis

#!/bin/sh

redis-cli -p 7000 shutdown &

redis-cli -p 7001 shutdown &

redis-cli -p 7002 shutdown &

redis-cli -p 7003 shutdown &

redis-cli -p 7004 shutdown &

redis-cli -p 7005 shutdown &

完成后我们试着启动redis集群 sh start.sh

然后使用ps -ef | grep redis 查看是否启动成功

5. 创建redis集群

#5.0版本执行 使用C语言内部管理集群

redis-cli --cluster create --cluster-replicas 1 192.168.35.130:7000 192.168.35.130:7001 192.168.35.130:7002 192.168.35.130:7003 192.168.35.130:7004 192.168.35.130:7005

至此, 集群搭建完毕!

6. 高可用测试

-

关闭redis主机.检查是否自动实现故障迁移.

-

再次启动关闭的主机.检查是否能够实现自动的挂载.

一般情况下 能够实现主从挂载

个别情况: 宕机后的节点重启,可能挂载到其他主节点中(7001-7002) 正确的

Redis集群算法

1. Redis集群工作原理

原理说明:

Redis的所有节点都会保存当前redis集群中的全部主从状态信息.并且每个节点都能够相互通信.当一个节点发生宕机现象.则集群中的其他节点通过PING-PONG检测机制检查Redis节点是否宕机.当有半数以上的节点认为宕机.则认为主节点宕机.同时由Redis剩余的主节点进入选举机制.投票选举链接宕机的主节点的从机.实现故障迁移.

2. Redis集群宕机的条件

说明:当redis主节点宕机之后.没有从节点进行替补,则整个redis集群崩溃!!!

特点:集群中如果主机宕机,那么从机可以继续提供服务,

当主机中没有从机时,则向其它主机借用多余的从机.继续提供服务.如果主机宕机时没有从机可用,则集群崩溃.

答案:9个redis节点,节点宕机5-7次时集群才崩溃.

3. Redis存储的原理(分区)

知识准备:

- 当用户操作redis主机时,从机会自动的实现数据的同步!!! (主从复制)

- Redis集群搭建的主要的目的2个 1.实现内存扩容 2.可以实现Redis的高可用.

- redis中的主机所保存的数据都是不相同的!!!.

- redis集群中的数据存储,不是随机存储,内部有算法的支持. hash槽算法(分区算法)

Redis集群搭建的划分:

存储的原理:

说明: RedisCluster采用此分区,所有的键根据哈希函数(CRC16[key]%16384)映射到0-16383槽内,共16384个槽位,每个节点维护部分槽及槽所映射的键值数据.根据主节点的个数,均衡划分区间.

算法:哈希函数: Hash()=CRC16[key]%16384 CRC16是哈希算法的一种

当向redis集群中插入数据时,首先将key进行计算.之后将计算结果匹配到具体的某一个槽的区间内,之后再将数据set到管理该槽的节点中.

如图所示

4. Redis分区说明

Redis分区只负责 数据应该存储到哪里的问题.至于是否能存储的下 完全由Redis内存决定.

特点:

1.hash(key1)%16384 = 3000

2.hash(key2)%16384 = 3000 key1和key2 都归第一个节点进行管理.

5.Redis hash槽与一致性 hash算法的区别

1.运算位置不同.

1.redis分片机制在业务服务器中完成的运算.

2.redis分区算法在连接Redis之后,由redis进行计算.

2.算法不同 一致性hash算法/hash槽算法.

3.redis分片可以随意的进行数据的保存. redis分区不能随机存储.分区中只能保存属于我的key.

6.Redis面试题

1.Redis集群中的主机最多 多少台? 16384个.

Redis集群内存多少最多可以扩展到原有redis多少倍.

2.Redis中存储的数据最多16384个??? 不对的. 16384只是分区的大小.至于能存储多少数据,完全由内存决定.

7.Redis集群宕机条件说明

说明: redis集群中 只要有一台Redis 主机宕机. 则整个Redis集群崩溃(可以进行高可用)

问题分析:

- 如果有6台Redis搭建集群,问: 最少宕机多少台Redis集群崩溃???

宕机2台集群崩溃 - 如果搭建9台Redis.3台主机, 问 :最少宕机Redis台 集群奔溃???

宕机5台集群崩溃

补充说明:如果想让集群尽可能不宕机,则适当增加从节点的数量. 2-3个从即可.

8.什么是脑裂现象

说明:在集群的机制中,由主机进行选举,当主机在进行选举时如果连续3次出现平票的结果时,则可能引发脑裂现象.

问题:出现脑裂现象的概率是多少? 答: 1/8=12.5%

如何有效降低脑裂现象: 可以通过增加主机的数量来有效降低脑裂的发生

springboot整合redis集群

1. 编辑properties配置文件

redis.properties文件内容如下

# 配置Redis集群

redis.nodes=192.168.126.129:7000,192.168.126.129:7001,192.168.126.129:7002,192.168.126.129:7003,192.168.126.129:7004,192.168.126.129:7005

2. 编辑配置类

@Configuration //标识我是配置类

@PropertySource("classpath:/properties/redis.properties")

public class RedisConfig {

/**

* 引入redis集群配置

*/

@Value("${redis.nodes}")

private String nodes; //node,node,node

@Bean

public JedisCluster jedisCluster(){

String[] strNodes = nodes.split(","); //[node1,nod2,nod3.....

Set<HostAndPort> set = new HashSet<>();

for(String node : strNodes){ //node=host:port

String host = node.split(":")[0];

int port = Integer.parseInt(node.split(":")[1]);

set.add(new HostAndPort(host,port));

}

return new JedisCluster(set);

}

}

如果配置了AOP, 修改AOP中的依赖注入即可, 改为注入JedisCluster对象