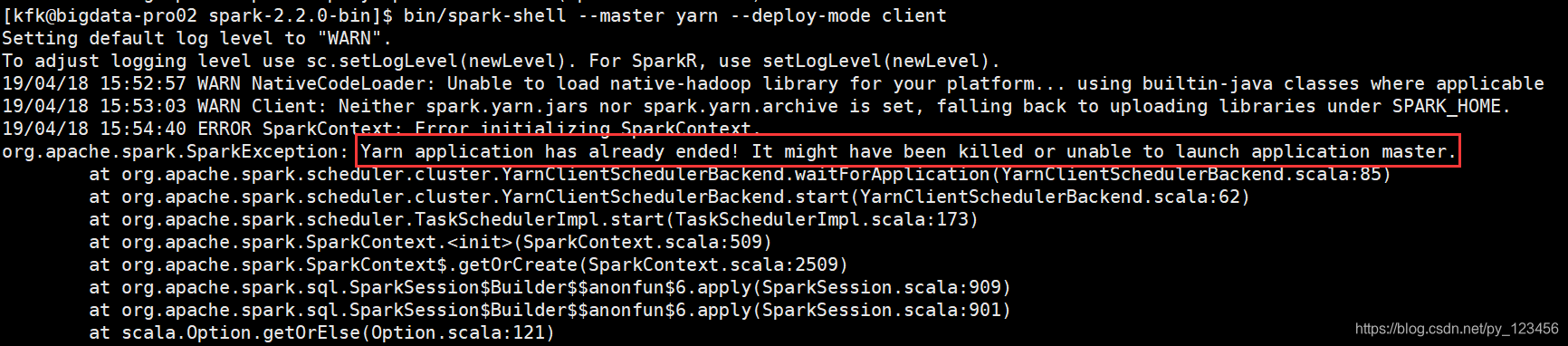

Spark on Yarn模式运行错误:

#报错

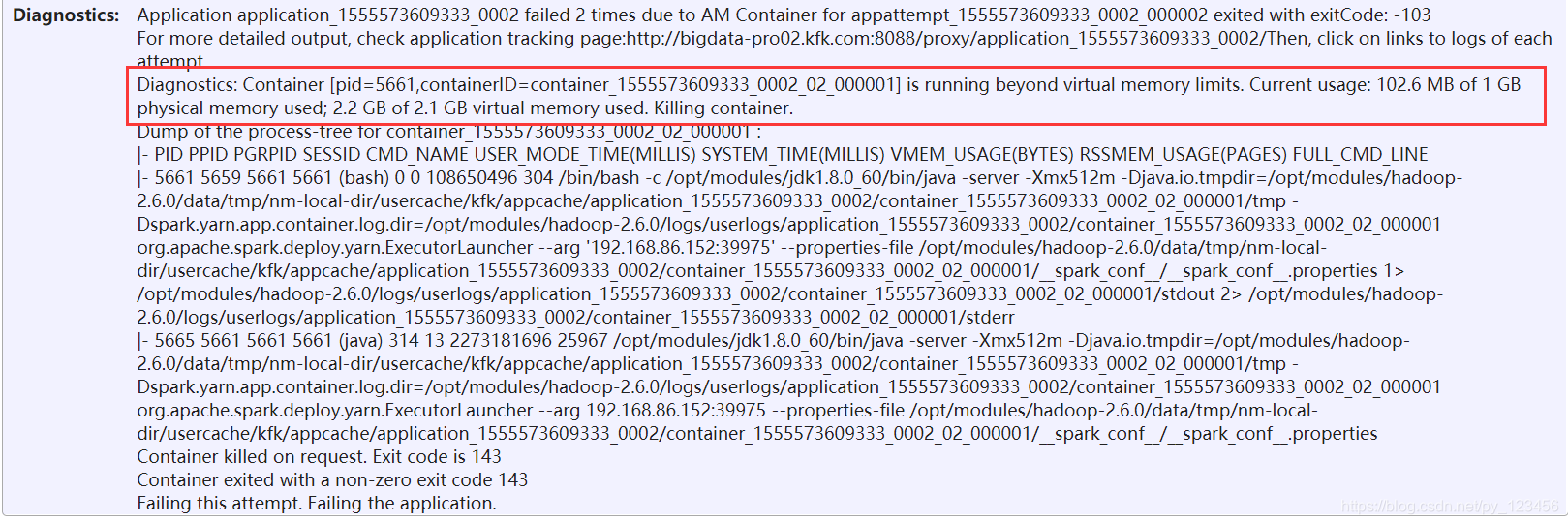

查看8088页面上的工作日志

错误原因:在执行任务时检测到虚拟机的内存太小,2.2g的虚拟内存实际值,超过了2.1g的上限,不能满足该任务所需的内存要求,于是Yarn就干掉了执行此任务的contrainer。

解决办法:

在yarn-site.xml文件中加入以下两项配置:

然后分发到另外两个节点去(分发之前先停掉yarn服务):

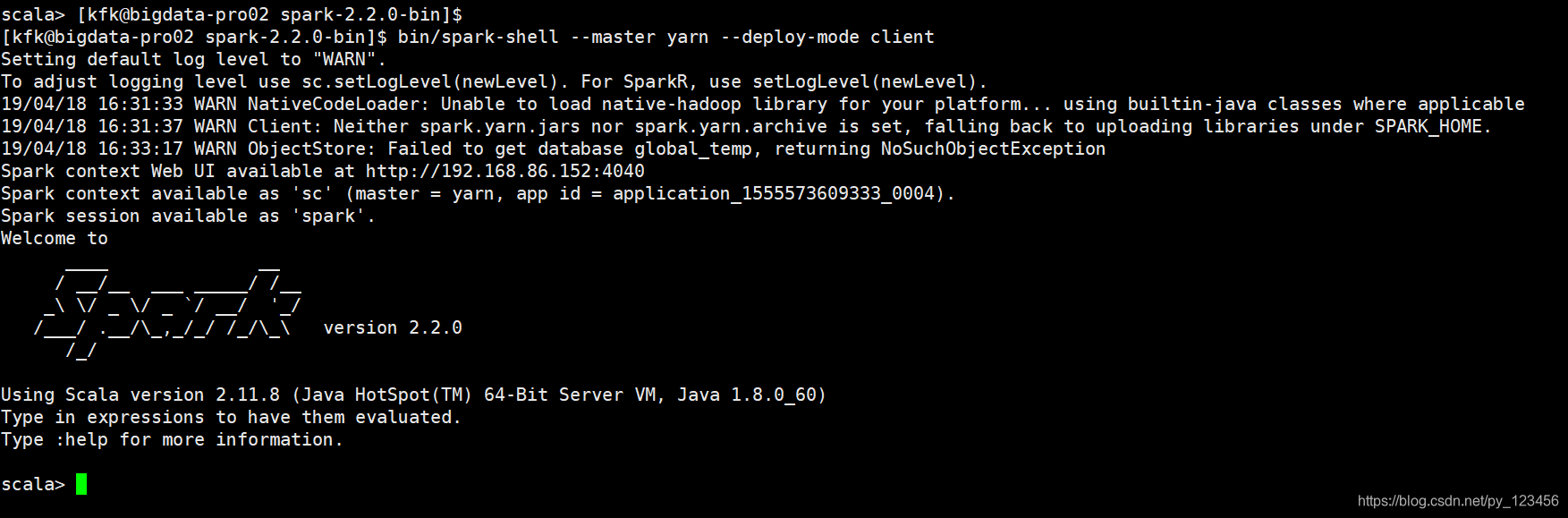

#重新启动yarn和spark

成功!

以上就是博主为大家介绍的这一板块的主要内容,这都是博主自己的学习过程,希望能给大家带来一定的指导作用,有用的还望大家点个支持,如果对你没用也望包涵,有错误烦请指出。如有期待可关注博主以第一时间获取更新哦,谢谢!同时也欢迎转载,但必须在博文明显位置标注原文地址,解释权归博主所有!