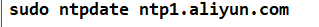

补充:同步一下三台服务器的时间啦~~

=======================================================================================================================================

Hadoop安装(完全分布式安装)

1、先在一台机器上安装 其他的远程发送

2、我们这里假设hadoop01是namenode datanode

hadoop02是secondarynamenode datanode

hadoop03是resourcemanager datanode

我们现在hadoop01上进行操作

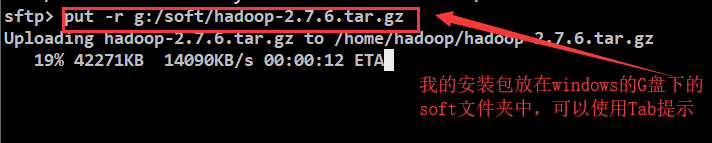

1、上传hadoop压缩包

2、解压缩

1)创建apps文件夹

2),将上传的hadoop压缩包放入apps中

mv hadoop-2.7.6.tar.gz apps/

3)解压 hadoop

tar -zxvf hadoop-2.7.6.tar.gz

3、修改配置文件( 在 /home/hadoop/apps/hadoop-2.7.6/etc/hadoop/ 目录下)

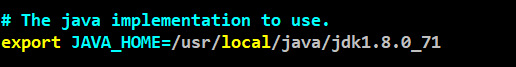

3.1 vim hadoop-env.sh

3.2 vim core-site.xml

加在<configuration>标签中间

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/data/hadoopdata</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop01:9000</value>

</property>

3.3 vim hdfs-site.xml

<property> <name>dfs.namenode.name.dir</name> <value>/home/hadoop/data/hadoopdata/name</value> <description>为了保证元数据的安全一般配置多个不同目录</description> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hadoop/data/hadoopdata/data</value> <description>datanode 的数据存储目录</description> </property> <property> <name>dfs.replication</name> <value>2</value> <description>HDFS 的数据块的副本存储个数</description> </property> <property> <name>dfs.secondary.http.address</name> <value>hadoop02:50090</value>

<description>secondarynamenode 运行节点的信息,和 namenode 不同节点</description>

</property>

3.4

我们先把 mapred-site.xml.template 复制一份 名字就叫作

mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

vim mapred-site.xml

<property> <name>mapreduce.framework.name</name> <value>yarn</value> </property>

3.5 vim yarn-site.xml

<property> <name>yarn.resourcemanager.hostname</name> <value>hadoop03<alue> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle<alue> <description>YARN 集群为 MapReduce 程序提供的 shuffle 服务</description> </property>

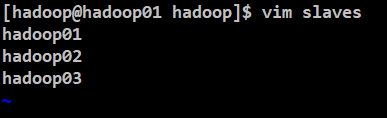

3.6 vim slaves

删除原来的localhost

加入下面三个 中间不可以有空格 不可以有空行

敲完第一个直接回车(中间不可以有空格)

敲完第二个直接回车

敲完第三个保存

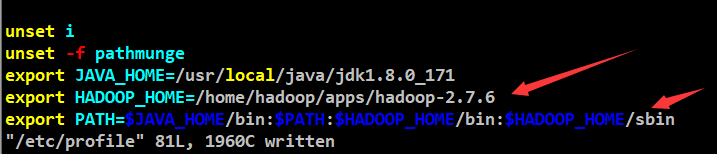

4、配置hadoop环境变量

sudo vim /etc/profile

export JAVA_HOME=/usr/local/javak1.8.0_73

export HADOOP_HOME=/home/hadoop/apps/hadoop-2.7.6

export PATH=$JAVA_HOME/bin:$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile 重新加载一下配置文件

验证:hadoop version

5、远程发送到其他两个节点

scp -r hadoop-2.7.6 hadoop02:$PWD

scp -r hadoop-2.7.6 hadoop03:$PWD

sudo scp /etc/profile hadoop02:/etc/

sudo scp /etc/profile hadoop03:/etc/

最后每个服务器都要

source /etc/profile

验证我们其他两台服务器是否成功

hadoop version

6.如果三台服务器都搭建好的话执行下面的操作

(1)初始化

只需要在一台机器上执行,一定在namenode节点上的 hdfs的主节点上

我们这里假设hadoop01是namenode 所以在hadoop01上执行这个命令

hadoop namenode -format

(2)启动hdfs 在hadoop01 上执行

start-dfs.sh

(3)启动yarn(在hadoop03上执行 假设hadoop03是resourcemanager yarn的主节点)

start-yarn.sh

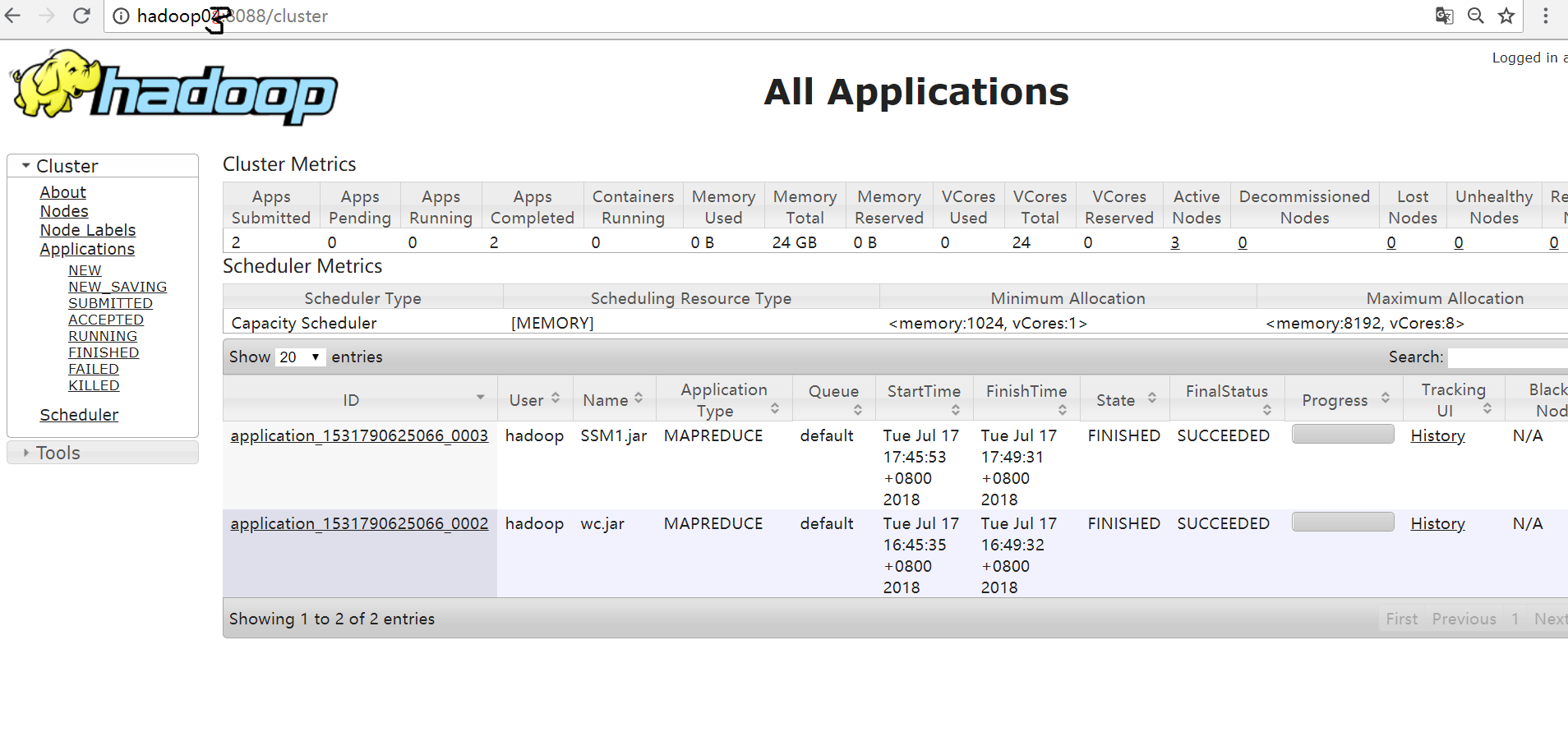

7、验证

在浏览器中输入:

hadoop01:50070

hadoop03:8088