使用视盘分割示例

1、 导出到移动端模型,使用paddleLite示例,运行崩溃

2、 使用OPT命令

./opt --model_file=./inference_model/__model__ --param_file=./inference_model/__params__ --valid_targets=arm --optimize_out_type=naive_buffer --optimize_out=tttt

生成模型后,使用示例运行,弹出窗口,再点预测程序会崩溃。

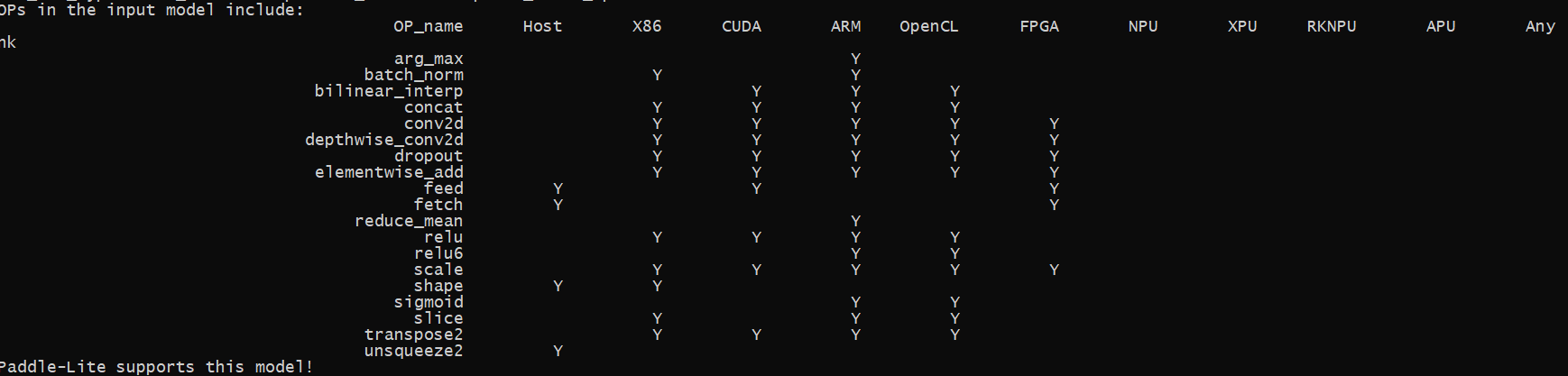

3、使用 --print_model_ops=true 命令检测

看起来正常,目前官方技术人员也不知道原因。

4、另外小度熊分拣使用的是实例分割模式,无法导出移动端模型

官方解释:maskrcnn一般用resnet50,不过不能导出移动端模型。

基于以上各种问题,准备上(NVIDIA)Jetson NANO Developer KIT B01 硬件了