1.用VMware建立两台虚拟机(Centos6.5)系统,并设立主机名为node1与node2

2.设置虚拟机网络两台都是设置为如图:

3.修改两台虚拟机的/etc/hosts的文件为 (其中192.168.159.129是node1的IP,192.168.159.130为node2的IP)

node1修改为:

192.168.159.129 localhost node1 localhost4 localhost4.localdomain4

::1 localhost node1 localhost6 localhost6.localdomain6

192.168.159.130 node2

node2修改为:

192.168.159.130 localhost node1 localhost4 localhost4.localdomain4

::1 localhost node1 localhost6 localhost6.localdomain6

192.168.159.129 node1

4.安装JDK并配置环境变量

5.把下载好的hadoop-1.2.1-tar.gz放到root目录下

6.执行解压命令解压

tar -zxvf hadoop-1.2.1-tar.gz

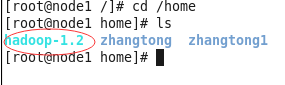

7.解压出来的由于目录比较长最好加个软链

ln -sf /root/hadoop-1.2.1 /home/hadoop-1.2

折样/home目录下就会出现

以后直接访问home下的hadoop-1.2就会直接到安装的hadoop-1.2.1目录

8.在node1上运行命令 cd /home/hadoop-1.2/conf进入hadoop配置文件目录修改配置文件

a.运行vi core-site.xml修改为

<configuration> <property> <name>fs.default.name</name> <value>hdfs://node1:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/opt/hadoop-1.2</value> </property> </configuration>

注:hdfs://node1:9000为hdfs的访问地址 node1是主机名或可为ip地址但不能写localhsot因为外部访问不到

/opt/hadoop-1.2为hdfs的工作目录(可以不设)默认为hadoop的tmp目录下(重启后数据就会消失下次还得重新格式化)

b.运行 vim hdfs-site.xml修改

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration>

这里配置的是block的副本数因为有两台虚拟机所以副本数设置为1

c.运行 vi slaves

node2

这里配置的是datanode的主机

d.运行 vi masters

node2

配置SecondaryNameNode在node2主机上

e.运行 vi hadoop-env.sh修改你的java环境地址

export JAVA_HOME=/opt/jdk1.7.0_79

9.把你hadoop-1.2.1-tar.gz放到node2上和node1相同的目录并解压

10 在node1上的切换到hadoop-1.2的conf目录下

运行 scp ./*root@node2:/home/hadoop-1.2

把配置文件拷贝到node2上使node1和node2拥有相同的配置信息

11.在node1上格式化hadoop

切换到bin目录运行 ./hadoop namenode -format

配置成功

12.设置免密码登录ssh