目录:

·Yarn资源队列权限控制

·Hive表与Hdfs文件权限同步控制

·独立Hdfs文件权限控制

一、 Yarn资源队列权限控制

1.首先为了后面的测试,在集群所有节点上创建fayson1和fayson2两个用户。

"useradd fayson1"

"useradd fayson2"

2.从Cloudera Manager进入“动态资源池配置”

3.设置根root队列的ACL

保存

4.新建队列fayson1

点击“创建”,然后设置ACL

点击“创建”

注意:这里设置fayson2组可以管理fayson1这个队列

5.同样的方式新建fayson2队列

注意:这里管理访问策略不设置,默认集成父队列root的用户/组。

6.点击“刷新动态资源池”,不用重启集群。

4.队列ACL测试

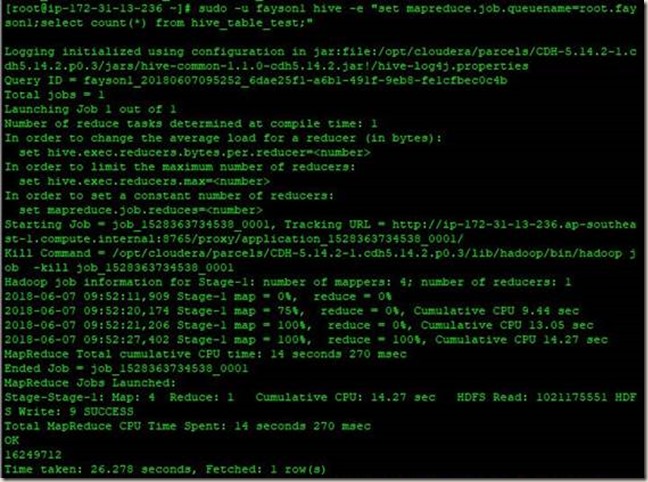

1.使用fayson1用户往队列root.fayson1队列提交作业。

sudo -u fayson1 hive -e "set mapreduce.job.queuename=root.fayson1;select count(*) from hive_table_test;"

运行成功,说明用户可以往自己有权限的队列里提交作业。

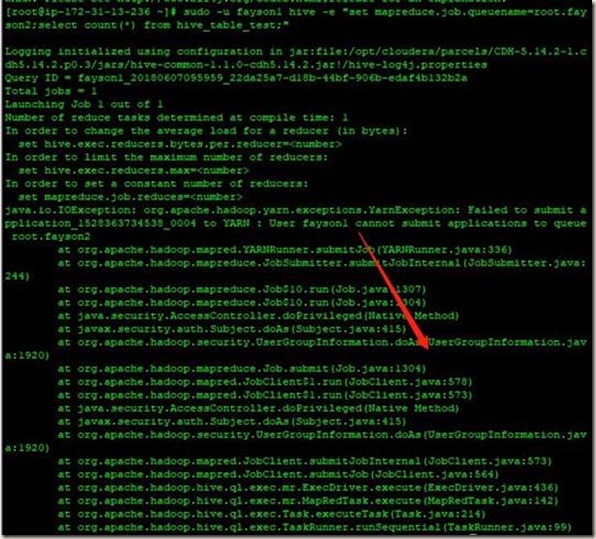

2.使用fayson1往root.fayson2队列里提交作业

sudo -u fayson1 hive -e "set mapreduce.job.queuename=root.fayson2;select count(*) from hive_table_test;"

报错,说明用户不能往自己没权限的队列里提交作业。

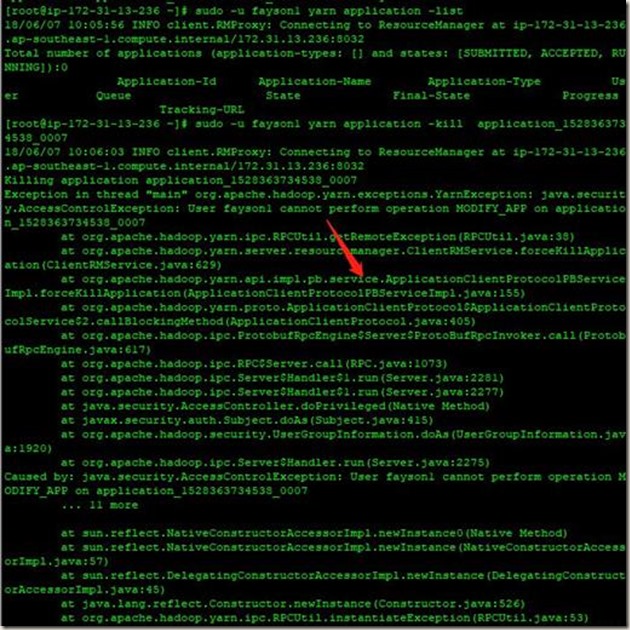

3.使用fayson2往root.fayson2队列里提交作业,然后使用fayson1用户kill该作业。

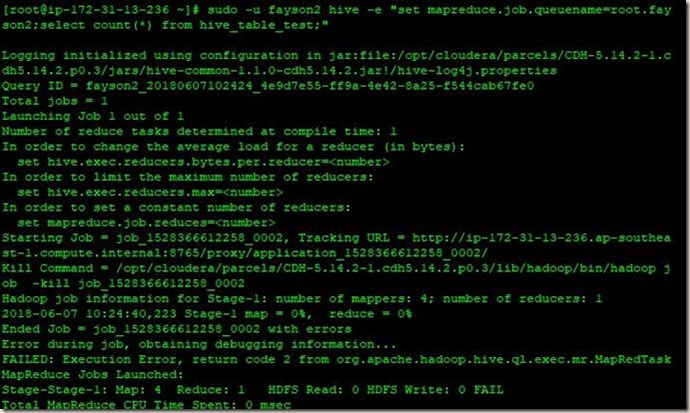

sudo -u fayson2 hive -e "set mapreduce.job.queuename=root.fayson2;select count(*) from hive_table_test;"

sudo -u fayson1 yarn application -list

sudo -u fayson1 yarn application -kill application_1528363734538_0007

首先启动作业

再开启一个终端用fayson1用户kill该作业

发现kill作业失败,打开刚开始提交作业的终端发现作业成功执行完毕。

说明如果用户没有队列的管理访问权限,没办法kill该队列里的作业。

4.在“创建队列并进行ACL设置”中,对于root.fayson2队列的“管理访问控制”设置为空,默认继承父队列root的用户/组。

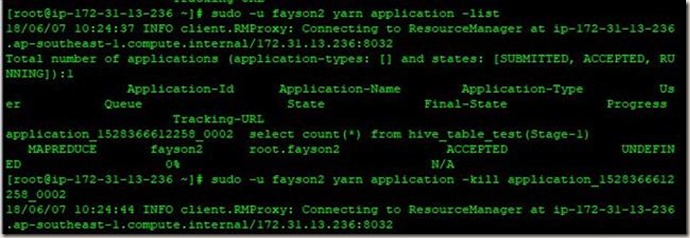

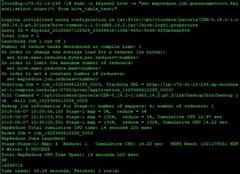

使用fayson2往root.fayson2队列提交一个任务,并且使用fayson2用户kill该作业

sudo -u fayson2 hive -e "set mapreduce.job.queuename=root.fayson2;select count(*) from hive_table_test;"

sudo -u fayson2 yarn application –list;

sudo -u fayson2 yarn application -kill application_1528366612258_0002;

发现kill作业成功,即使该用户/组不在队列的“管理访问控制”里,但是只要是自己提交的作业就能kill自己的作业。

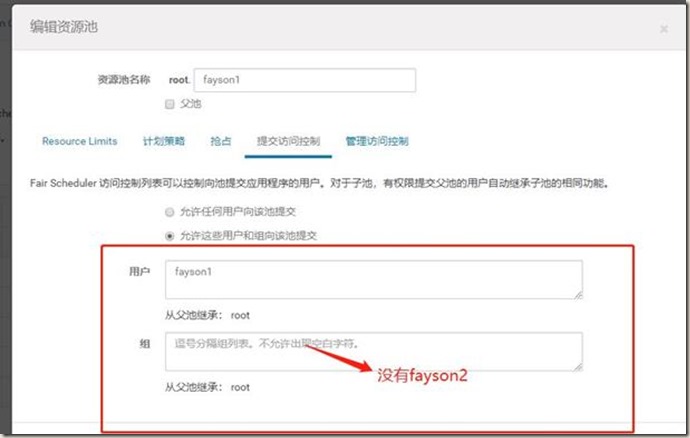

5.在 “创建队列并进行ACL设置”中,对于root.fayson1队列的“管理访问控制”设置为fayson2,但是在“提交访问控制”中却没有设置fayson2用户/组。

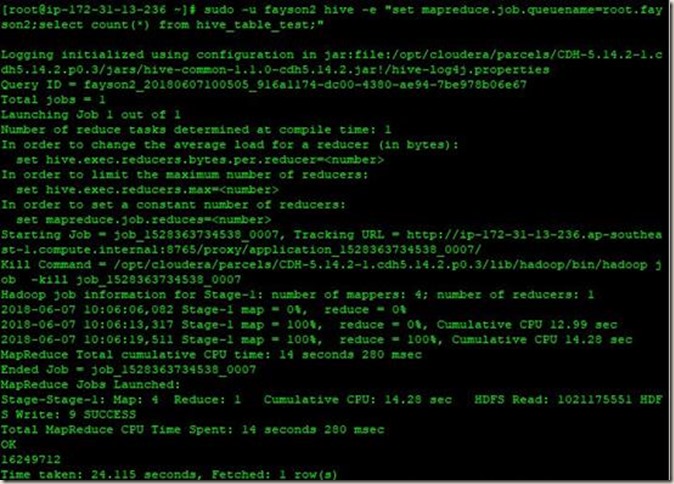

使用fayson2用户往root.fayson1队列提交任务。

sudo -u fayson2 hive -e "set mapreduce.job.queuename=root.fayson1;select count(*) from hive_table_test;"

任务执行成功,说明即使该用户不在队列的“提交访问控制”列表里,如果配置在“管理访问控制”中,也可以往该队列提交作业。

二、 Hive表与Hdfs文件权限同步控制

创建两个系统用户user1和user2

[root@wlint01 wlbd]# useradd user1

[root@wlint01 wlbd]# passwd user1

[root@wlint01 wlbd]# useradd user2

[root@wlint01 wlbd]# passwd user2

创建Kerberos用户

[wlbd@wlint01 ~]$ sudo kadmin.local -q "addprinc user1"

[wlbd@wlint01 ~]$ sudo kadmin.local -q "addprinc user2"

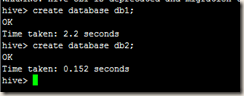

创建数据库和表。这里需要kinit之前生成的hive.keytab,然后进入Hive CLI创建数据库,再通过beeline创建role。

当前目录下有events.csv文件

[wlbd@wlint01 ~]$ cat events.csv

10.1.2.3,US,android,createNote

10.200.88.99,FR,windows,updateNote

10.1.2.3,US,android,updateNote

10.200.88.77,FR,ios,createNote

10.1.4.5,US,windows,updateTag

[wlbd@wlint01 ~]$ kinit -kt hive.keytab hive/wlint01

create database db1;

create database db2;

在数据库中创建表

在db1中创建table1,在db2中创建table1和table2

create table db1.table1 (

ip STRING, country STRING, client STRING, action STRING

) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',';

create table db2.table1 (

ip STRING, country STRING, client STRING, action STRING

) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',';

create table db2.table2 (

ip STRING, country STRING, client STRING, action STRING

) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',';

load data local inpath '/home/wlbd/events.csv' overwrite into table db1.table1;

load data local inpath '/home/wlbd/events.csv' overwrite into table db2.table1;

load data local inpath '/home/wlbd/events.csv' overwrite into table db2.table2;

赋予用户权限

这里是通过beeline连接进行操作的

给user1赋予db1的所有权限

beeline -u "jdbc:hive2://wlint01:10000/;principal=hive/wlint01@HXDI.COM"

create role user1_role;

GRANT ALL ON DATABASE db1 TO ROLE user1_role;

GRANT ROLE user1_role TO GROUP user1;

给user2赋予db2的所有权限

create role user2_role;

GRANT ALL ON DATABASE db2 TO ROLE user2_role;

GRANT ROLE user2_role TO GROUP user2;

测试用户权限

user1用户只具有db1和default的权限

[wlbd@wlint01 ~]$ kinit user1

Password for user1@HXDI.COM:

[wlbd@wlint01 ~]$ beeline -u "jdbc:hive2://wlint01:10000/;principal=hive/wlint01@HXDI.COM"

scan complete in 2ms

Connecting to jdbc:hive2://wlint01:10000/;principal=hive/wlint01@HXDI.COM

Connected to: Apache Hive (version 1.1.0-cdh5.14.2)

Driver: Hive JDBC (version 1.1.0-cdh5.14.2)

Transaction isolation: TRANSACTION_REPEATABLE_READ

Beeline version 1.1.0-cdh5.14.2 by Apache Hive

0: jdbc:hive2://wlint01:10000/> show databases;

INFO : Compiling command(queryId=hive_20180618150404_d26fd5a2-8c54-44d5-9df8-38f362535491): show databases

INFO : Semantic Analysis Completed

INFO : Returning Hive schema: Schema(fieldSchemas:[FieldSchema(name:database_name, type:string, comment:from deserializer)], properties:null)

INFO : Completed compiling command(queryId=hive_20180618150404_d26fd5a2-8c54-44d5-9df8-38f362535491); Time taken: 0.38 seconds

INFO : Executing command(queryId=hive_20180618150404_d26fd5a2-8c54-44d5-9df8-38f362535491): show databases

INFO : Starting task [Stage-0:DDL] in serial mode

INFO : Completed executing command(queryId=hive_20180618150404_d26fd5a2-8c54-44d5-9df8-38f362535491); Time taken: 0.281 seconds

INFO : OK

+----------------+--+

| database_name |

+----------------+--+

| db1 |

| default |

+----------------+--+

2 rows selected (0.884 seconds)

0: jdbc:hive2://wlint01:10000/>

user2用户只具有db2和default的权限

[wlbd@wlint01 ~]$ kinit user2

Password for user2@HXDI.COM:

[wlbd@wlint01 ~]$ beeline -u "jdbc:hive2://wlint01:10000/;principal=hive/wlint01@HXDI.COM"

scan complete in 2ms

Connecting to jdbc:hive2://wlint01:10000/;principal=hive/wlint01@HXDI.COM

Connected to: Apache Hive (version 1.1.0-cdh5.14.2)

Driver: Hive JDBC (version 1.1.0-cdh5.14.2)

Transaction isolation: TRANSACTION_REPEATABLE_READ

Beeline version 1.1.0-cdh5.14.2 by Apache Hive

0: jdbc:hive2://wlint01:10000/> show databases;

INFO : Compiling command(queryId=hive_20180618151010_397e7de5-2bd7-4bd7-90d7-bbfabcab48e8): show databases

INFO : Semantic Analysis Completed

INFO : Returning Hive schema: Schema(fieldSchemas:[FieldSchema(name:database_name, type:string, comment:from deserializer)], properties:null)

INFO : Completed compiling command(queryId=hive_20180618151010_397e7de5-2bd7-4bd7-90d7-bbfabcab48e8); Time taken: 0.104 seconds

INFO : Executing command(queryId=hive_20180618151010_397e7de5-2bd7-4bd7-90d7-bbfabcab48e8): show databases

INFO : Starting task [Stage-0:DDL] in serial mode

INFO : Completed executing command(queryId=hive_20180618151010_397e7de5-2bd7-4bd7-90d7-bbfabcab48e8); Time taken: 0.176 seconds

INFO : OK

+----------------+--+

| database_name |

+----------------+--+

| db2 |

| default |

+----------------+--+

2 rows selected (0.418 seconds)

禁用HIve CLI

表示hive、hue、hdfs和sentry都能访问CLI,别的用户或组成员访问不了CLI。这样创建一个用户user1,由于user1不在这个列表里面,user1自然访问不了Hive CLI。

HDFS测试

配置HDFS ACL与Sentry同步后,HDFS权限与Sentry监控的目录(/user/hive/warehouse)的权限同步

[root@hxmaster ~]# kinit -kt hive.keytab hive/hxmaster

[root@hxmaster ~]# hadoop fs -getfacl -R /user/hive/warehouse/

# file: /user/hive/warehouse

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/db1.db

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:user1:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/db1.db/table1

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:user1:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/db1.db/table1/events.csv

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:user1:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/db2.db

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:user2:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/db2.db/table1

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:user2:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/db2.db/table1/events.csv

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:user2:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/db2.db/table2

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:user2:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/db2.db/table2/events.csv

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:user2:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/test_table

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:hive:rwx

mask::rwx

other::--x

# file: /user/hive/warehouse/test_table/events.csv

# owner: hive

# group: hive

user::rwx

group::---

user:hive:rwx

group:hive:rwx

mask::rwx

other::--x

切换到user1用户,查看HDFS文件

[root@hxmaster ~]# kinit user1

Password for user1@ANDREW.COM:

You have mail in /var/spool/mail/root

[root@hxmaster ~]# hadoop fs -ls /user/hive/warehouse/db1.db

Found 1 items

drwxrwx--x+ - hive hive 0 2018-06-10 20:08 /user/hive/warehouse/db1.db/table1

[root@hxmaster ~]# hadoop fs -cat /user/hive/warehouse/db1.db/table1/events.csv

10.1.2.3,US,android,createNote

10.200.88.99,FR,windows,updateNote

10.1.2.3,US,android,updateNote

10.200.88.77,FR,ios,createNote

10.1.4.5,US,windows,updateTag

You have mail in /var/spool/mail/root

[root@hxmaster ~]# hadoop fs -ls /user/hive/warehouse/db2.db

ls: Permission denied: user=user1, access=READ_EXECUTE, inode="/user/hive/warehouse/db2.db":hive:hive:drwxrwx--x

[root@hxmaster ~]# hadoop fs -cat /user/hive/warehouse/db2.db/table1/events.csv

cat: Permission denied: user=user1, access=READ, inode="/user/hive/warehouse/db2.db/table1/events.csv":hive:hive:-rwxrwx--x

切换到user2用户,查看HDFS文件

[root@hxmaster ~]# kinit user2

Password for user2@ANDREW.COM:

[root@hxmaster ~]# hadoop fs -ls /user/hive/warehouse/db1.db

ls: Permission denied: user=user2, access=READ_EXECUTE, inode="/user/hive/warehouse/db1.db":hive:hive:drwxrwx--x

[root@hxmaster ~]# hadoop fs -cat /user/hive/warehouse/db1.db/table1/events.csv

cat: Permission denied: user=user2, access=READ, inode="/user/hive/warehouse/db1.db/table1/events.csv":hive:hive:-rwxrwx--x

[root@hxmaster ~]# hadoop fs -ls /user/hive/warehouse/db2.db

Found 2 items

drwxrwx--x+ - hive hive 0 2018-06-10 20:08 /user/hive/warehouse/db2.db/table1

drwxrwx--x+ - hive hive 0 2018-06-10 20:08 /user/hive/warehouse/db2.db/table2

[root@hxmaster ~]# hadoop fs -cat /user/hive/warehouse/db2.db/table1/events.csv

10.1.2.3,US,android,createNote

10.200.88.99,FR,windows,updateNote

10.1.2.3,US,android,updateNote

10.200.88.77,FR,ios,createNote

10.1.4.5,US,windows,updateTag

[root@hxmaster ~]# hadoop fs -cat /user/hive/warehouse/db2.db/table2/events.csv

10.1.2.3,US,android,createNote

10.200.88.99,FR,windows,updateNote

10.1.2.3,US,android,updateNote

10.200.88.77,FR,ios,createNote

10.1.4.5,US,windows,updateTag

三、 独立Hdfs文件权限控制

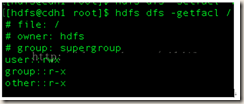

1、 使用hsdf dfs -getfacl / 命令能够得到当前/文件夹的权限。

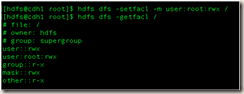

2、使用命令hdfs dfs -setfacl -m user:root:rwx / 为root用户在/文件夹下添加rwx权限

3、现在root用户已经能够在/文件夹下进行rwx操作了。

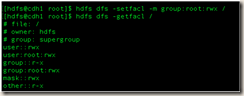

4、同样可以使用hdfs dfs -setfacl -m group:root:rwx / 为root组在文件夹/下添加rwx权限。

5、这样就可以让root用户组下的所有用户拥有文件夹/下的rwx权限了。

6、命令详解

Usage: hdfs dfs -setfacl -R|[--set <acl_spec> <path>]

选项:

· -b: 删除基本ACL条目以外的所有条目。保留用户,组和其他条目以与权限位兼容。

· -k: 删除默认ACL。default

· -R: 以递归方式将操作应用于所有文件和目录。常用。

· -m: 修改ACL。新条目将添加到ACL,并保留现有条目。常用。

· -x: 删除指定的ACL条目。保留其他ACL条目。常用。

· --set: 完全替换ACL,丢弃所有现有条目。 acl_spec必须包含用户,组和其他条目,以便与权限位兼容。

· acl_spec: 逗号分隔的ACL条目列表。

· path: 要修改的文件或目录。