非常好的一篇:https://my.oschina.net/u/876354/blog/1637819

alexnet和VGG没什么特别的,VGG深一些。

Deep learning 实际上是一种 feature engineering 的方法。不论是AlexNet还是VGG-Net,倒数第二层都可以很好的描述image全局特征,所以它们通常用来当作 input image 新的 feature,用来做 image classification(最后一层N个node的softmax层,代表了N个类别)。那么, AlexNet 和 VGG-Net 的 intermediate layer(中间层)呢? 他们是否也可以作为特征来使用? 答案是肯定的。 这些 intermediate convolutional layer 描述了影像的 local feature (局部特征),而最后的几层(倒数第二、第三层) fully connected layer,描述了影像的 global feature (全局特征)。如果一个 deep architecture 只有 convolutional layer, 那么 input image 可以任意大小,可是一旦在convolutional layer 上面叠加上 fully connected layer,input image大小就需要固定了。今年CVPR有好多文章使用 convolutionally filtered intermediate layer 作为 local feature,典型的代表有 Jitendra Malik (Berkeley) 组的 Hypercolumns for Object Segmentation and Fine-grained Localization,Xiaoou Tang (CUHK) 组的 Action Recognition With Trajectory-Pooled Deep-Convolutional Descriptors。

googlenet有几个重要概念

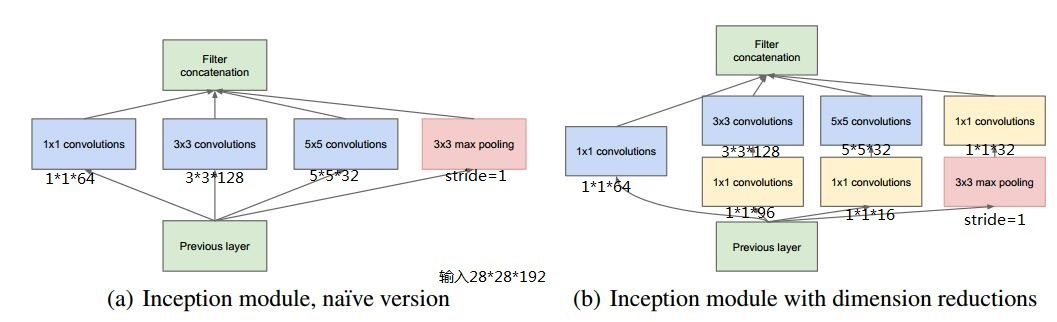

1、inception模块

inception概念及其后续发展:

https://blog.csdn.net/qq_14845119/article/details/73648100

googlenet中的inception(下图b)

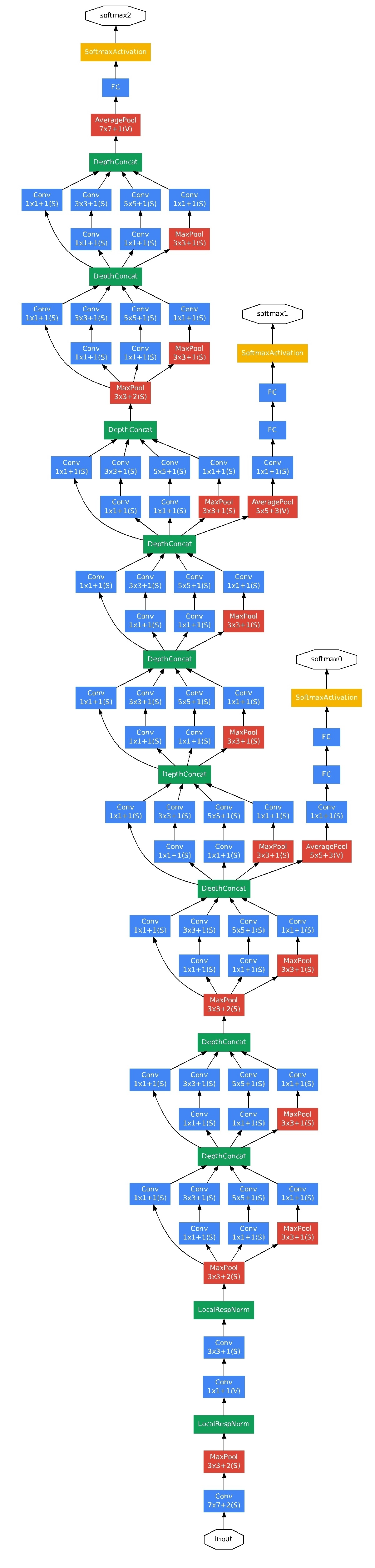

googlenet结构:

2、depthconcat,可以简单理解为几个通道合并

3、1*1卷积,虽说是1*1卷积,但实际上是1*1*n的卷积,可以用于降维(降低通道数),不仅googlenet中有,用于semantic segmentation的unet之类的网络中也有。

1*1卷积

https://blog.csdn.net/chaipp0607/article/details/60868689

unet

https://blog.csdn.net/Formlsl/article/details/80373200