第五周:卷积神经网络 part3

一、卷积神经网络

基本应用:

- 语音问答 2. 股票预测 3. 作词作诗 4. 图像理解 5. 视觉问答

循环神经网络和卷积神经网络的不同是什么?

- 传统神经网络,卷积神经网络,输入和输出之间是相互独立的

- RNN可以更好的处理具有时序关系的任务

- RNN通过其循环结构引入“记忆”的

二、基本结构

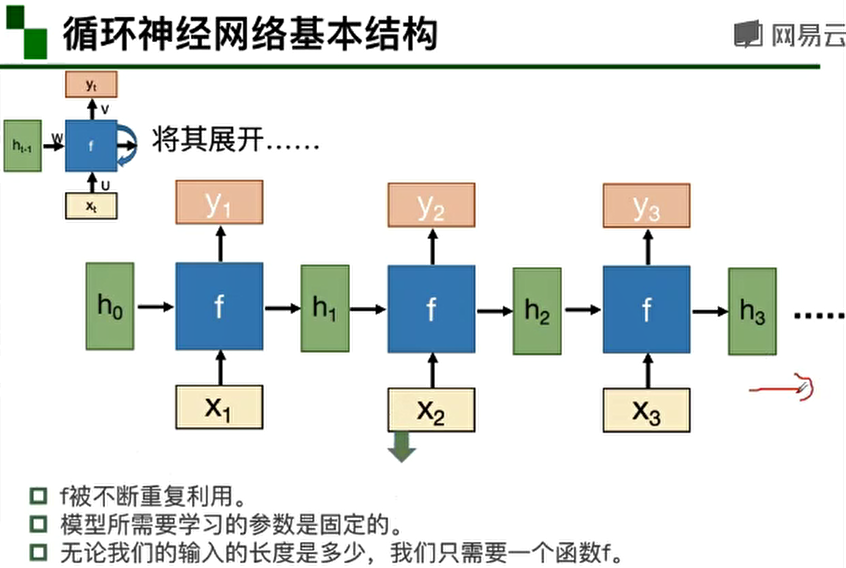

1.RNN基本结构

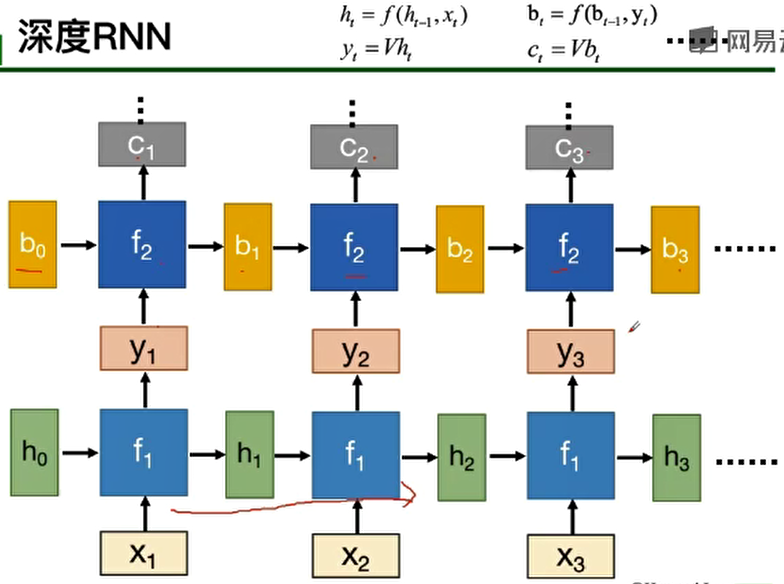

2.深度RNN

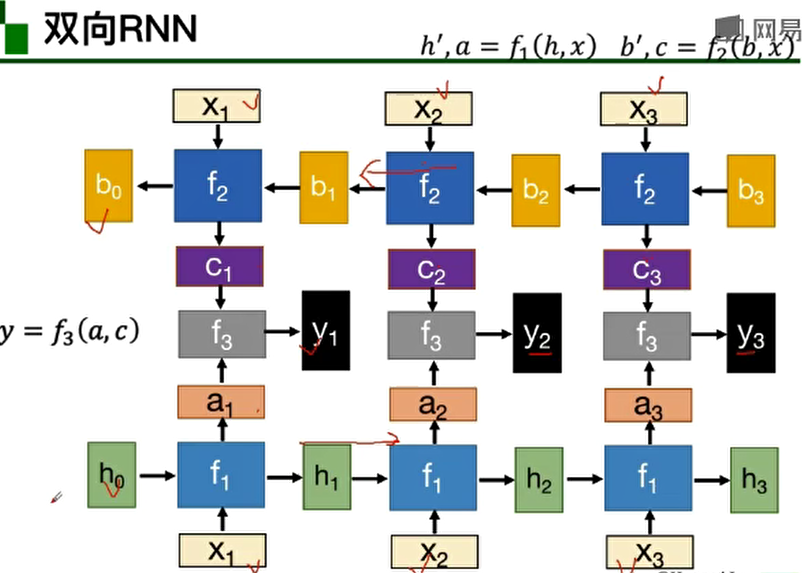

3.双向RNN

4.BP算法

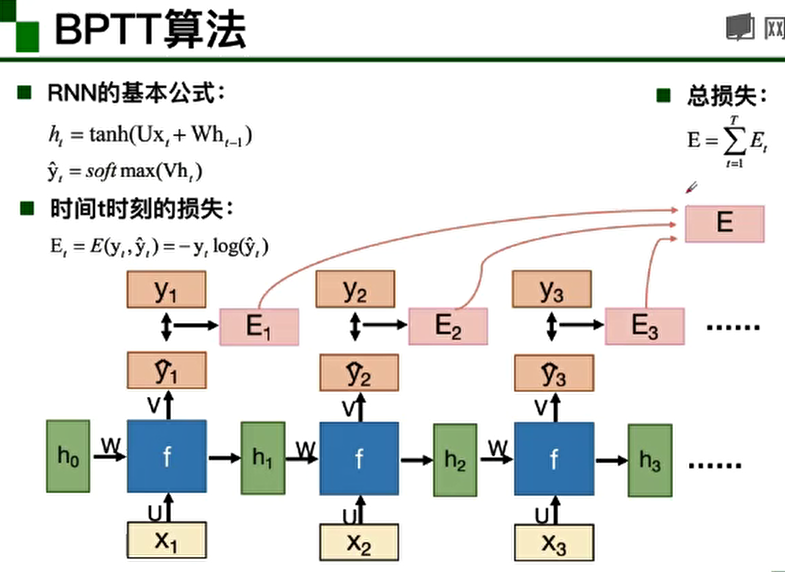

5.BPTT算法

三、变种

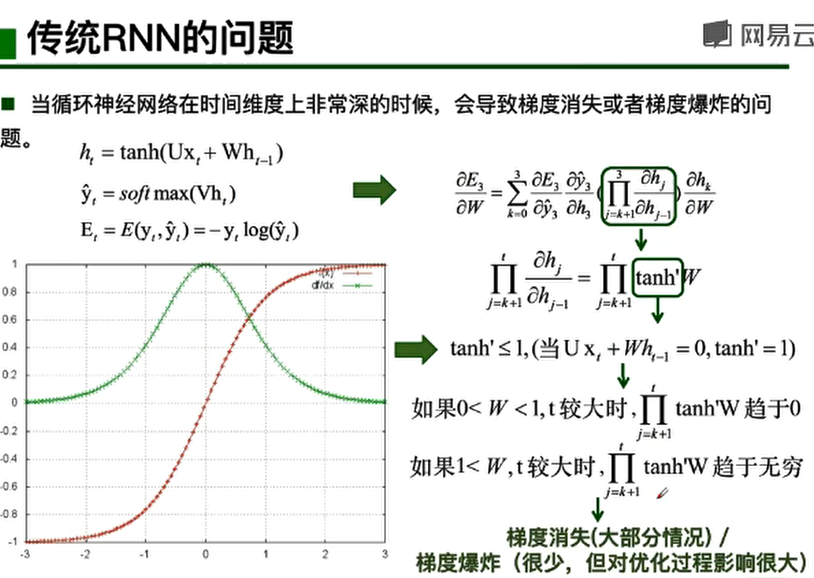

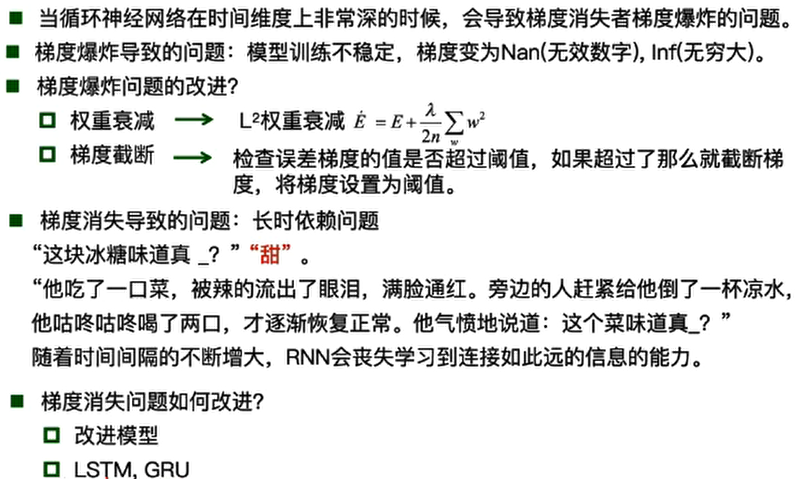

1.传统RNN的问题

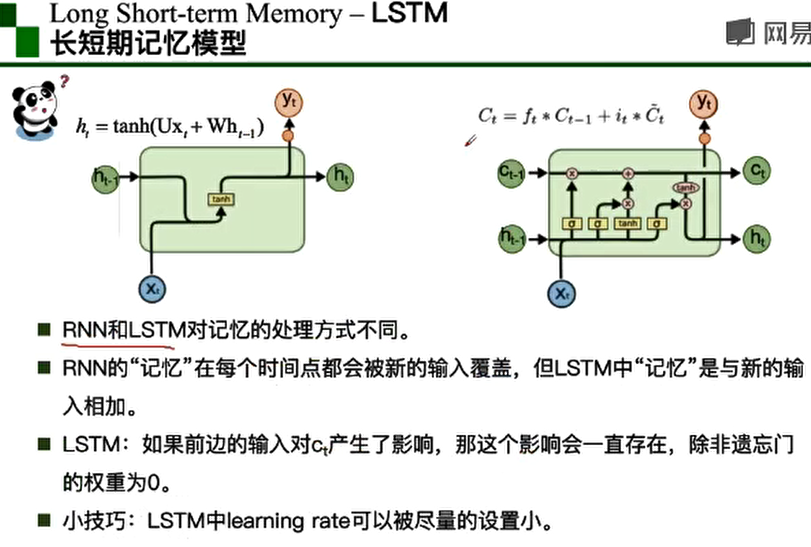

2.LSTM

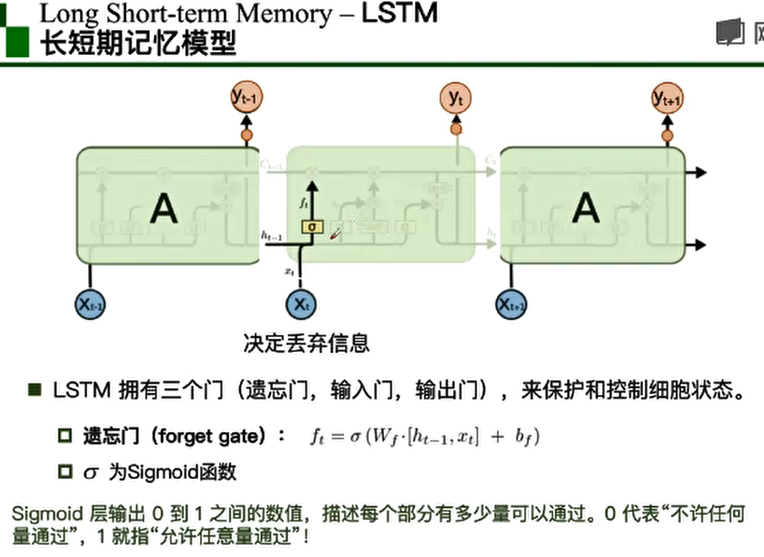

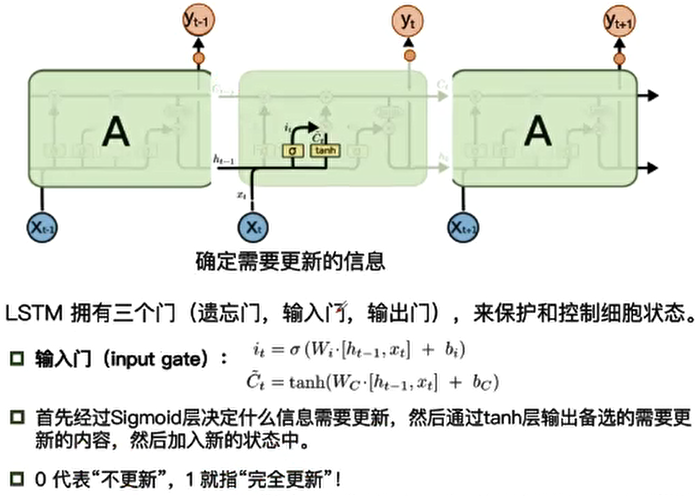

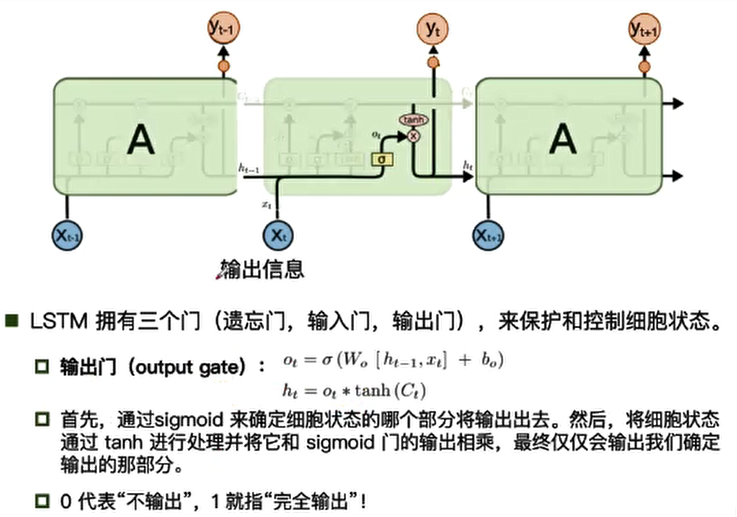

LSTM(长短期记忆模型)由三个门(遗忘门、输入门、输出门)组成,来保护和控制细胞状态。

遗忘门:决定丢弃信息

输入门:确认需要更新的信息

输入门:确认需要更新的信息

遗忘门:

输入门:

输出门:

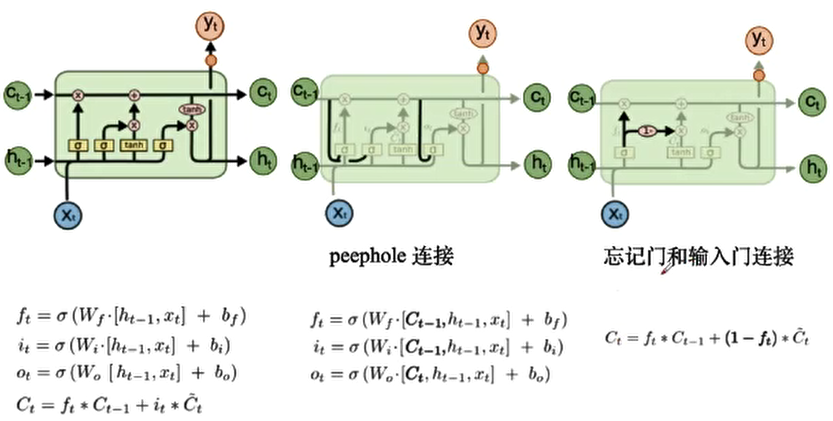

3.LSTM变形

小结:

LSTM实现了三个门计算,即遗忘门,输入门,和输出门。

LSTM的一个初始化技巧就是将输出门的bias置为正数(例如1或5,这点可以查看各大框架代码),

这样模型刚开始训练时forget gate的值接近于1,不会发生梯度消失。

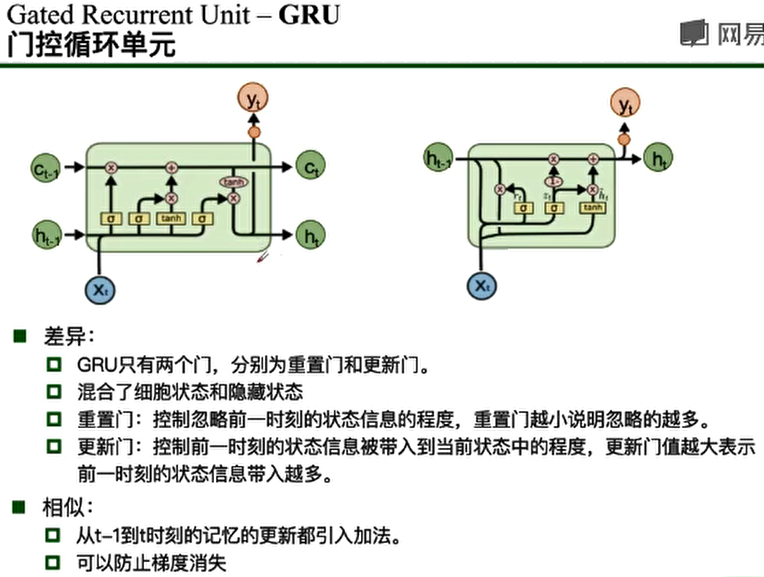

但LSTM有三个门,运算复杂,如何解决?->GRU

4.GRU

四、扩展

1.Clockwise RNN

2. 基于attention的RNN

什么是attention?

是受到人类注意力机制的启发。人们在进行观察图像的时候,其实并不是一次就

把整幅图像的每个位置像素都看过,大多是根据需求将注意力集中到图像的特定

部分。而且人类会根据之前观察的图像学习到未来要观察图像注意力应该集中的

位置。