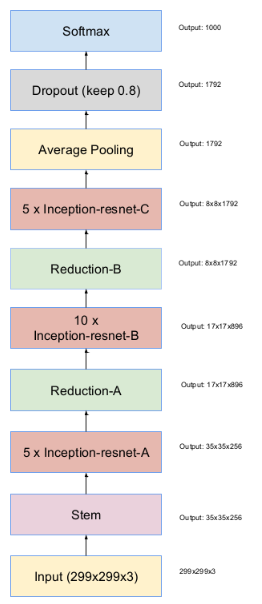

零、Inception-Resnet-V2的网络模型

整体结构如下,整体设计简洁直观:

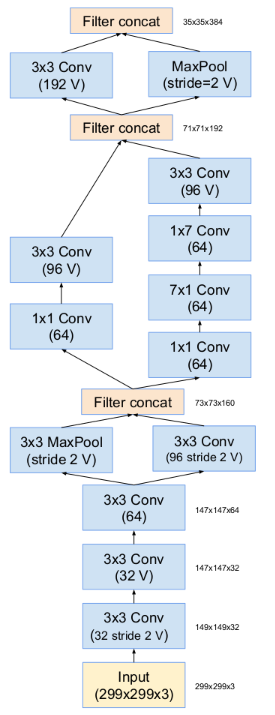

其中的stem部分网络结构如下,inception设计,并且conv也使用了7*1+1*7这种优化形式:

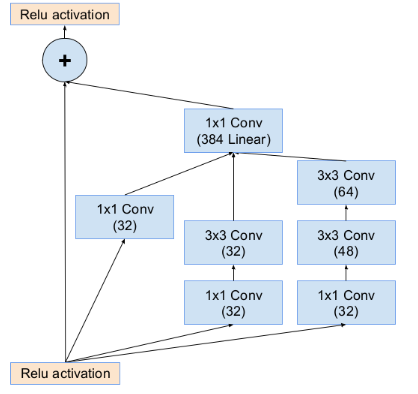

inception-resnet-A部分设计,inception+残差设计:

截自https://my.oschina.net/gyspace/blog/893788

一、Inception

基本思想:不需要人为决定使用哪个过滤器,或是否需要池化,而是由网络自行确定这些参数,你可以给网络添加这些参数的所有可能值,然后把这些输出连接起来,让网络自己学习它需要什么样的参数,采用哪些过滤器组合。

细节:网络中存在softmax分支,原因——即便是隐藏单元和中间层也参与了特征计算,它们也能预测图片的分类,它在Inception网络中起到一种调整的效果,防止过拟合。

二、Resnet

残差网络就是残差块的堆叠,这样可以把网络设计的很深;

残差网络和普通网络的差异是,al+2在进行非线性变化前,把al的数据拷贝了一份与zl+2累加后进行了非线性变换;

对于普通的卷积网络,用梯度下降等常用的优化算法,随着网络深度的增加,训练误差会呈现出先降低后增加的趋势,而我们期望的理想结果是随着网络深度的增加训练误差逐渐减小,而Resnet随着网络深度的增加训练误差会一直减小。

三、1*1卷积的主要作用有以下几点:

1、降维( dimension reductionality )。比如,一张500 * 500且厚度depth为100 的图片在20个filter上做1*1的卷积,那么结果的大小为500*500*20。

2、加入非线性。卷积层之后经过激励层,1*1的卷积在前一层的学习表示上添加了非线性激励( non-linear activation ),提升网络的表达能力;可以在保持feature map尺度不变的(即不损失分辨率)的前提下大幅增加非线性特性(利用后接的非线性激活函数),把网络做的很deep。

当1*1卷积出现时,在大多数情况下它作用是升/降特征的维度,这里的维度指的是通道数(厚度),而不改变图片的宽和高。