逐步会更新阅读过的AutoML文献(其实是NAS),以及自己的一些思考

- Progressive Neural Architecture Search,2018ECCV的文章;

目的是:Speed up NAS by proposing an alternative algorithm (Progressive Search),

具体方法:采取Learning transferable architectures for scalable image recognition中相似的搜索空间,也就是block->cell->network;采用simple to complex的搜索策略,

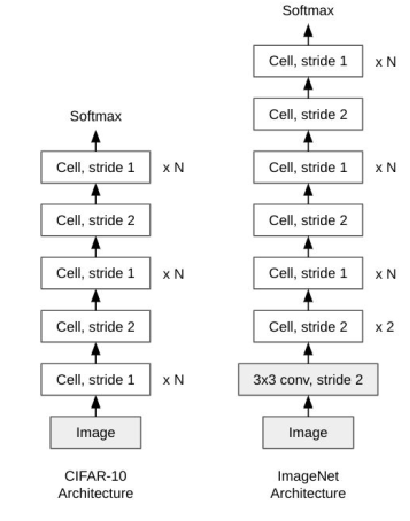

网络结构

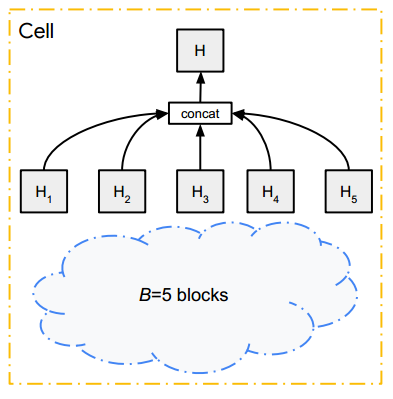

Cell结构

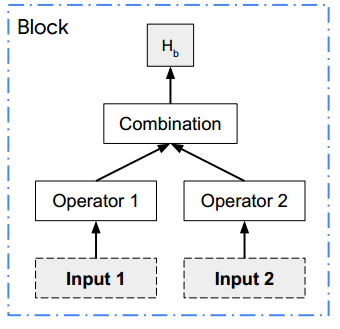

Block结构

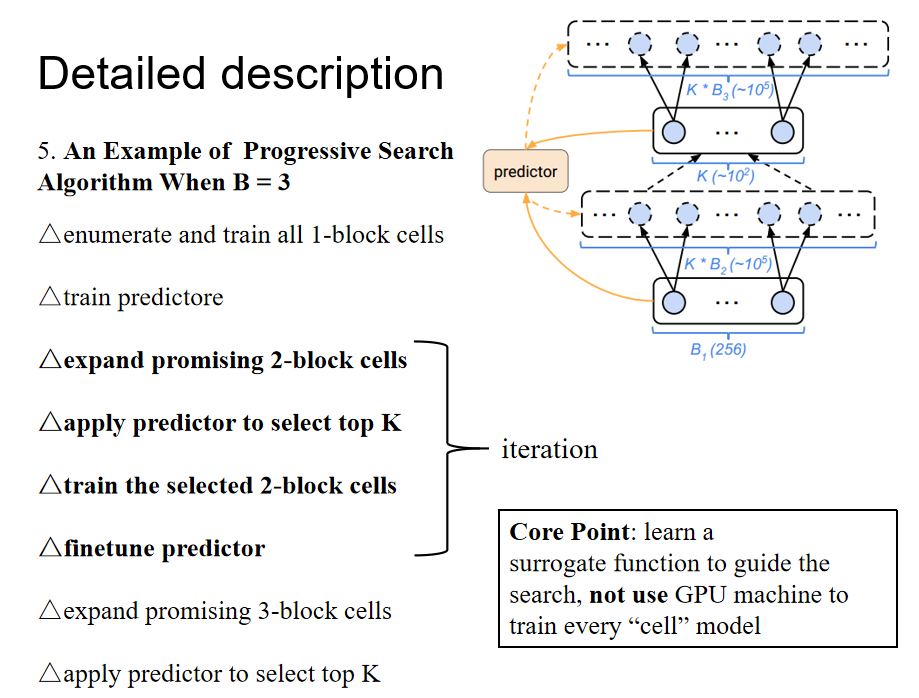

为了减少搜索空间,采用的搜索算法如下:

搜索算法

个人评论:采用了进化算法的思想,以及训练一个预测器,来预测网络性能,但是具体怎么预测并没有说明。

2.Efficient Neural Architecture Search via Parameter Sharing,大名鼎鼎的ENAS,采用权重共享的方法,2018CVPR的文章

目的是:Improve the efficiencyo of NAS to eschew training each child model from scratch to convergence,也就是减少每个子模型训练到收敛的时间。

IDEAS是:让每个子模型都共享一套权重;在一个超网络下,构建很多的子网络

3.Transfer NAS: Knowledge Transfer between Search Spaces with Transformer Agents,2019ICML的workshop,私以为可以结合第1篇进行修改。

目的是:针对不同搜索空间需要重新搜索的问题,提出了一个支持联合学习和快速迁移先验知识的基于transformer的多搜索空间和任务的agent,用于搜索空间迁移

4. EAT-NAS: Elastic Architecture Transfer for Accelerating Large-scale Neural Architecture Search,可以算是地平线出品

目的是:更好地把小数据的网络结构迁移到大数据上,因为目前很少有直接在ImageNet上搜索网络结构的工作,一般是在小数据集(CIFAR10)上训练好,然后直接迁移到ImageNet上,但这样

不能保证迁移后的网络性能。

具体方法:在CIFAR10上搜索得到一个最优网络后,作为种子结构传给ImageNet;首先使用进化算法进行basic architecture的搜索(best model on the samll dataset),然后作为种子进行large dataset的初始化,这使得larget dataset的搜索更快速并且方向更正确

5. Multinomial Distribution Learning for Effective Neural Architecture Search,2019ICCV的文章,主要是刷新搜索时间和网络精度,在搜索算法上进行革新;作者知乎ID风车车,从机械到计算机视觉,非常励志,是我学习的榜样,而且今年才研一已经至少两篇顶会了!还有一篇Dynamic Distribution Pruning for Efficient Network Architecture Search

目的是:把网络结构选择转换成一个多项式分布学习问题,主要是假设每个模型在训练阶段的性能排名都是相同的,即好的一开始就好,差的一开始就差

6. Evaluating the Search Phase of Neural Architecture Search,很有批判性的一篇文章,主要是为了搞清楚NAS算法背后的运行情况

首先证明了随机搜索的平均性能比目前的NAS方法要好,其次是NAS算法的排名和结果并不能代表真正的网络结构性能;权重共享策略会影响网络的训练,从而影响搜索过程的有效性。具体来说权重共享打乱了按照真实训练每个网络结构得到的排名

7. On Network Design Spaces for Visual Recognition,对设计空间进行了探索,主要是发现设计空间之间的差异,依次来解释模型的性能,作为一个case应用在了NAS上,因为NAS专注于在一个搜索空间找到最佳网络,而这篇论文关注搜索空间(设计空间)本身,得出了一个结论,最近的NAS方法很大程度上忽略了设计空间上的差异;通过对五个NAS方法的搜索空间的分析,论文认为随着NAS的发展,搜索得到的网络精度的提高可能一部分受益于搜索空间的改进,比如DARTS的搜索空间最优,而NASNet则最差;论文也将DARTS、NASNet搜索空间和ResNeXt作了对比,发现DARTS和ResNeXt差不多,而NASNet依旧是最差的。

结论是:搜索空间的设计其实很重要,未来应该要出现一些设计搜索空间的工作,无论是手工方法还是数据驱动方法