安装完成之后的环境变量的配置如下:

JAVA_HOME=/usr/local/jdk1.8.0_144

JRE_HOME=/usr/java/jdk1.8.0_144/jre

CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

HADOOP_HOME=/usr/local/hadoop-2.8.2

M2_HOME=/usr/local/maven3

MAHOUT_HOME=/usr/local/hadoop-2.8.2/mahout

export MAHOUT_CONF_DIR=$MAHOUT_HOME/conf

export HADOOP_HOME_WARN_SUPPRESS=not_null

PATH=$PATH:$M2_HOME/bin:$JAVA_HOME/bin:$HADOOP_HOME/bin:$MAHOUT_HOME/bin

export JAVA_HOME

export JRE_HOME

export CLASSPATH

export HADOOP_HOME

export M2_HOME

export PATH

1. java的安装

下载官方文档之后配置环境变量

2.mvn的安装

下载官方文档之后配置环境变量

3.hadoop单机安装

下载官方文档之后解压之后配置环境环境变量

tar -zxvf **.tar.gz

修改配置文件

nano hadoop-env.sh

#export JAVA_HOME=${JAVA_HOME}

export JAVA_HOME=/usr/local/jdk1.8.0_144

nano yarn-env.sh

export JAVA_HOME=/usr/local/jdk1.8.0_144

nano core-site.xml

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

<description>HDFS的URI,文件系统://namenode标识:端口号</description>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop-2.8.2/tmp</value>

<description>namenode上本地的hadoop临时文件夹</description>

<value>hdfs://localhost:9000</value>

<description>HDFS的URI,文件系统://namenode标识:端口号</description>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop-2.8.2/tmp</value>

<description>namenode上本地的hadoop临时文件夹</description>

</property>

</configuration>

nano hdfs-site.xml

<configuration>

<!-- hdfs-site.xml-->

<property>

<name>dfs.name.dir</name>

<value>/usr/local/hadoop-2.8.2/hdfs/name</value>

<description>namenode上存储hdfs名字空间元数据 </description>

</property>

<property>

<name>dfs.data.dir</name>

<value>/usr/local/hadoop-2.8.2/hdfs/data</value>

<name>dfs.name.dir</name>

<value>/usr/local/hadoop-2.8.2/hdfs/name</value>

<description>namenode上存储hdfs名字空间元数据 </description>

</property>

<property>

<name>dfs.data.dir</name>

<value>/usr/local/hadoop-2.8.2/hdfs/data</value>

<description>datanode上数据块的物理存储位置</description>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

<description>副本个数,配置默认是3,应小于datanode机器数量</description>

</property>

</configuration>

配置访问路径和端口:nano yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>192.168.174.129:8099</value>

</property>

</configuration>

启动hadoop

bin/nodename -format

sbin/start-dfs.sh

sbin/start-yarn.sh

在浏览器中输入:192.168.174.129:8099

返回接口信息

或者输入 jps

[root@localhost hadoop-2.8.2]# jps

4848 NameNode

6163 NodeManager

6429 Jps

5854 ResourceManager

5535 SecondaryNameNode

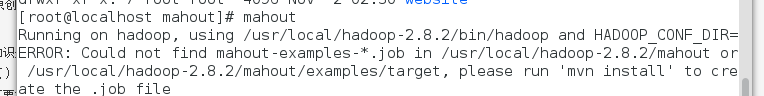

mahout安装

从官网上git,把文件放置到hadoop目录下

配置环境变量之后,查看是否成功抛出如下异常

意思是配置有问题

在mahout下面配置打包之后上传