前言

HDP version: 3.x

HIVE version: 3.x

问题描述

使用hdp版本的集群服务,当安装好spark以后,执行spark.sql ,不能查询到hive的数据库,只查询到default数据库,说明spark没有连接到hive。

问题现象

分析:

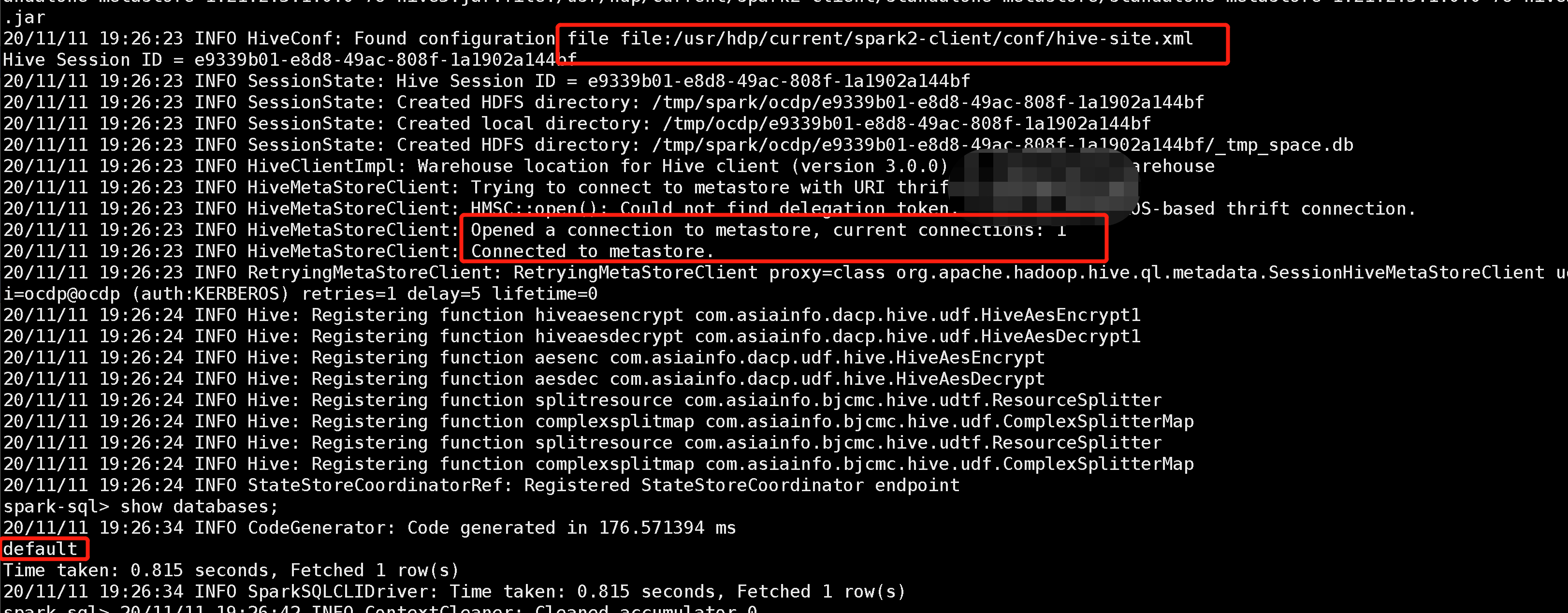

1、通过上图可以看到spark加载的hive-site.xml文件。

2、可以看到hive的版本是3.0

3、可以看到spark连接到metastore元数据服务了

4、执行show databases时候,只显示了default默认数据库

解决

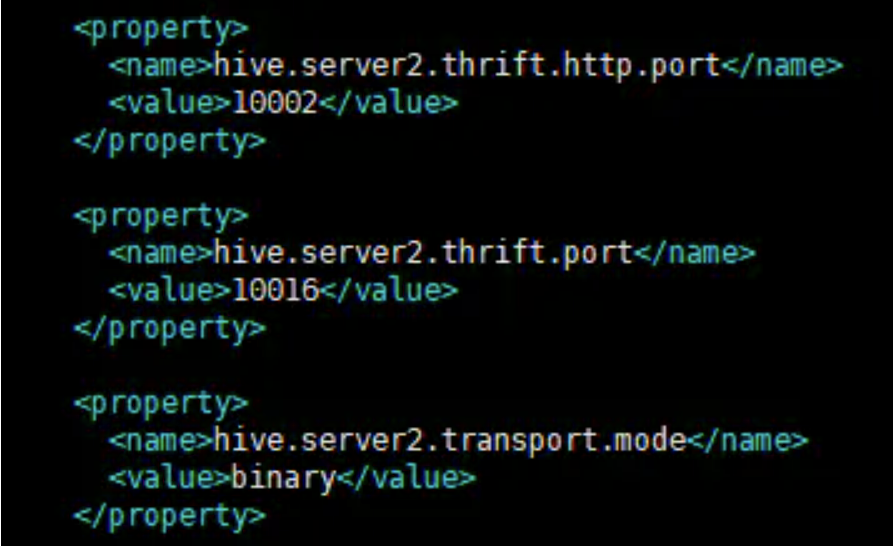

上述提到了一个加载的配置文件,查看这个文件的配置,发现如下参数与集群的不一致

修改成如下的值:

<property>

<name>hive.server2.thrift.http.port</name>

<value>10001</value>

</property>

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

</property>

<property>

<name>metastore.catalog.default</name>

<value>hive</value>

</property>