论文: https://arxiv.org/pdf/1803.01271.pdf

github:https://github.com/locuslab/TCN

转自:http://nooverfit.com/wp/时间卷积网络tcn-总结:时序模型不再是递归网络rnn/

https://blog.csdn.net/Kuo_Jun_Lin/article/details/80602776

https://zhuanlan.zhihu.com/p/41987775

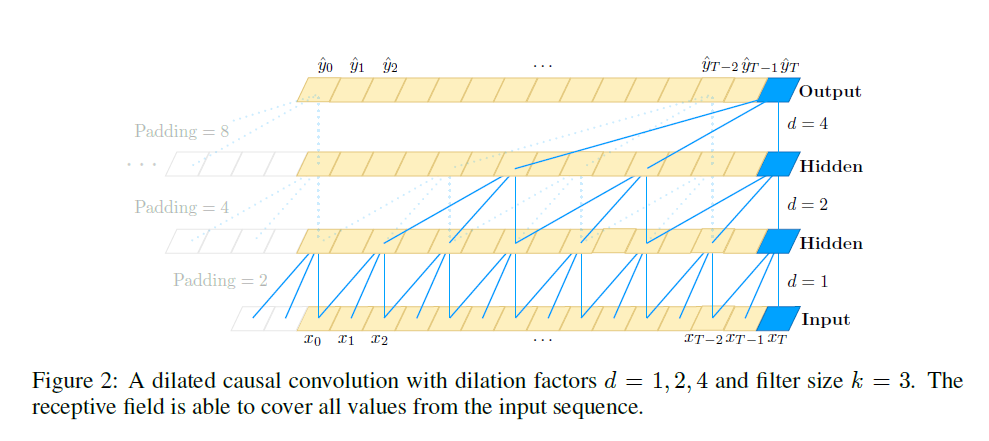

整体结构(来自论文)图1:

TCN的卷积和普通1D卷积最大的不同就是用了扩张卷积(dilated convolutions),越到上层,卷积窗口越大,而卷积窗口中的“空孔”越多。

核心关键

时序问题有两个关键要求:

-

网络输入x0, . . . , xT 的时序数据,我们希望输出也是一样大小的 y0, . . . , yT 的预测。扩张卷积可以做到每一层隐层都和输入序列大小一样,并且计算量降低,感受野足够大。

-

时序预测要求对时刻t 的预测yt只能通过t时刻之前的输入x1到xt-1来判别(像隐马尔科夫链)。这在CNN里面通过因果卷积(causal convolutions)实现,可通过图1看出。本质上,David 9认为就是通过限制卷积窗口滑动做到的。

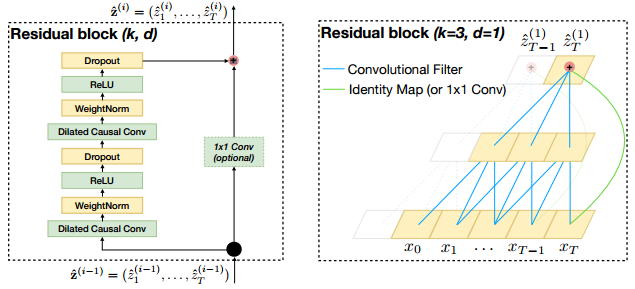

然后,TCN还为了提高准确率,还加入了残差卷积的跳层连接,以及1×1的卷积操作:

残差卷积无需多讲,把下层特征拿到高层增强准确率。1×1卷积是为了降维。

备注:

1x1卷积核的作用: https://zhuanlan.zhihu.com/p/40050371

Weight Normalization: https://zhuanlan.zhihu.com/p/55102378