deep learning初学者,最近在看一些GAN方面的论文,在生成器中通常会用到skip conections,于是就上网查了一些skip connection的博客,虽然东西都是人家的,但是出于学习的目的,还是有必要自行总结下。

skip connections中文翻译叫跳跃连接,通常用于残差网络中。

它的作用是:在比较深的网络中,解决在训练的过程中梯度爆炸和梯度消失问题。

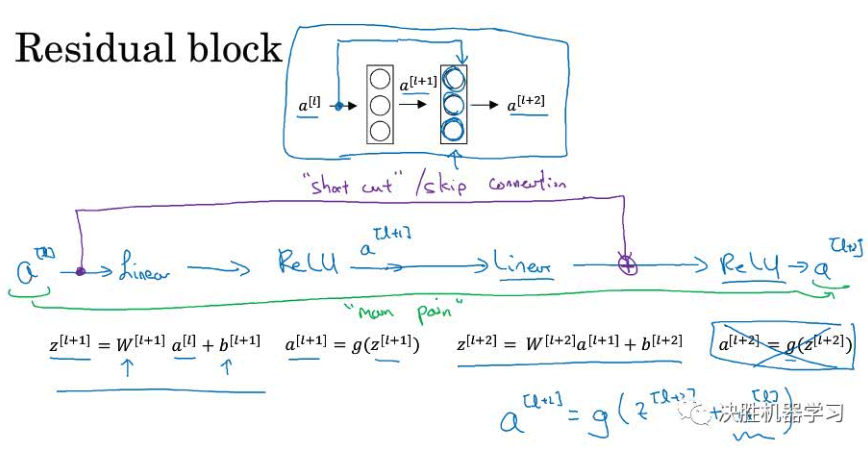

那么什么是残差块呢?

这个就是残差快,其实就是在神经网络前向传播的时候,考虑第l,l+1,l+2层,a[l]代表第l层的输出,而在一般的神经网络中,需要经过l+1层才能到达l+2层,而残差块中直接将a[l]传出到l+2层,使得a[l+2] = g(z[l+2]+a[l]),其实就是在a[l+2]个激活单元除了与第l+2层的z相关,还与第l层的a相关,这就是跳跃连接。

残差块的原理是什么呢?

一个很深的网络,加入残差块后公示为:

a[l+2]=g(z[l+2]+a[l])=g(w[l+2]*a[l+1]+b[l+2]+a[l])

假设梯度消失,则就是w[l+2]=0,此时a[l+2]=g(a[l]),相当于把第l层的输出直接经过relu传输出去,则避免了梯度消失的问题。

参考链接: