摘要

作者认为大多数动物的行为不是聪明的学习算法——监督或者非监督——的结果,而是编码在基因组中。具体来说,动物具有高度结构化的大脑连接,使它们能够非常迅速的学习。由于连接过于复杂无法在基因组中明确指定,通过“genomic bottleneck”进行了压缩,而genomic bottleneck为我们提供了一条能够快速学习的神经网络道路。

(是否可以认为人类和动物一开始有一套大致相同的神经结构,这套神经系统具备基本学习能力,在此基础上经后天的经验对网络结构进行改进)

一、介绍

20世纪40年代计算机发明后,许多人相信计算机可以很快达到或超过人类的智力水平,人工自还能先驱者Herber Simon在1965年做出了著名预测:“机器将在20年内完成人类能够做的任何工作,即通用AI”。当然结果证明大错特错。

在今天的科技界,乐观的情绪再次高涨,很大程度上源于人工神经网络和机器学习(尤其是深度学习)的发展。机器视觉、语音识别、自动驾驶、机器翻译的发展如此迅速,以至于很多人预测我们正接近“技术奇点”,即人工超级智能触发失控增长并改变人类文明。在这种情况下,随着计算机功率的增加,将有可能制造出比建造者更智能的机器。而这个超级智能机器将建造更智能的机器,最终这个递归过程将加速,知道智能达到物理或计算机科学的极限。

尽管有这些进步,人工神经网络离人类智能还有很长的路要走。ANN可以在棋类游戏击败人类,但在大多数方面,如语言、推理、常识等都不及4岁儿童的认知能力,甚至离简单动物的能力还很远。许多最基本的行为,即使是对简单的动物来说毫不费力的行为,对人工智能也是遥不可及的。用人工智能先驱之一,Hans Moravec的话说:“人类大脑中高度进化的感觉和运动部分编码了10亿年关于自然世界和如何在其中生存的经验,我称之为推理的深思熟虑过程是人类思维最浅薄的一层,之所以有效是以为它是更古老且强大的无意识的感知运动知识(sensorimotor)所支持。我们都是感知和运动领域的非凡的奥林匹克运动员,我们做的太好了以至于让这些看起来非常容易。然而,抽象思维是一种新技巧,可能不到10万年的历史,我们还没有掌握它,其实并没有那么难。”

我们不能造出一个能筑巢、跟踪猎物或是装洗碗机的机器,在很多方面,人工智能远远不能达到狗、老鼠或是蜘蛛的智力水平,仅仅扩大当前的方法并不能实现这些目标。

好消息是,如果我们真的能达到老鼠的智力水平,那么人类的智力可能就离我们只有一步之遥了。我们的脊椎动物祖先大约出现在5亿年前,智力可能和鲨鱼差不多。人类智力进化的一个重大飞跃是新皮层(neocortex)的出现。大约1亿年前,当第一批胎盘类哺乳动物出现时,新皮层的基本结构已经建立,人类的大部分智力来源于对大脑皮层的精细加工。现代人类(智人)在仅几十万年前进化而来,对进化史不过眨眼功夫,这表明只要神经基础坚实,那些人类独有的特质,如语言和理性,实际上是比较容易实现的。虽然有些基因和细胞类型是人类独有的,就像其他物种一样,但没有任何证据表明人类大脑利用了老鼠或其他哺乳动物当前没有的基础神经生物学原则,所以老鼠和人类的智力差距可能比老鼠和AI之间小得多。这表明即便我们最终的目标是匹配或超越人类智能,人工智能的一个合理的近期目标是匹配老鼠的智能。

ANN的发明是为了根据神经系统的计算原理建立人工系统。作者提出,神经科学的附加原理可能加快实现人工老鼠甚至人类智能。作者认为,与人工神经系统不同,动物在很大程度上依赖于后天习得和先天机制的结合。这些先天过程经过进化产生,被编码在基因组中,并以rule的形式连接大脑。具体的说,这里引入genomic bottleneck概念,将进化中捕捉的任何先天过程压缩到基因组中,作为一个连接大脑规则的正则化约束。这里讨论这些观测结果对下一代机器算法的影响。

从本质上讲,强调先天机制的重要性只是“先天vs后天”争论的最新表现,这种争论从古希腊就开始了,柏拉图认为是Team Nature,亚里士多德认为是Team Nurture。从历史上看,这一争论主要集中在特征获取上,如智力和道德,传统认为这是人类所特有的。也许是受这些历史的影响,神经网络社区主要专注于对白板网络的Team Nurture,将网络参数的所有变化视为学习learning的结果。

二、ANN学习

在人工智能早期,是两种方法的竞争:符号人工智能和人工神经网络。Marvin Minsky所倡导的符号主义的good old fashion AI中,程序员负责为系统运行的算法编写程序。相比之下,在人工神经网络算法中,系统刚从数据中“学习”。符号人工智能可以被看作是心理学家的方法,从人类的认知过程中获得灵感,而不是试图打开黑盒子,而使用类似神经元的人工智能网络则从神经科学中获得灵感。从60年代到80年代,符号人工智能一直占据主导地位,自那以后被神经科学启发的人工智能方法所取代。

现代ANN和三十年前非常相似。更多的进步归结于原始计算能力的增强:仅仅因为摩尔定律,计算机比上一代快了几个数量级,而在GPU上应用ANN更是加快了它们的速度。第二个关键因素是大规模数据集的可用性,在谷歌时代前,收集用于训练的大量标记图像集是非常具有挑战性的。第三,现代神经网络需要更少的人工干预。现代神经网络,特别是深度网络,从数据中学习适当的底层表示,如视觉特征,而不是依赖手工来显式编程。

在ANN学习中,学习一词由不同于神经科学和心理学的用法。在神经网络中,学习是从输入数据中提取结构,即统计规则,并将其编码到网络参数中的过程。这些网络参数包括网络所需的所有信息。例如,一个N个神经元的全连接网络可能每个神经元由一个参数,例如threshold,还有N2个参数表示突触之间的连接强度。当然,随着N的增加,全连接ANN的参数数量由N2决定。

有三种经典的方式从数据中提取结构,并编码到网络参数中,如权重和阈值。在监督学习中,数据成对组成,输入和标签,目标是找到网络参数为新对生成正确标签。在无监督学习中,数据没有标签,目标是发现数据中的统计规律,而不需要明确指导寻找什么样的规律。例如,人们可以想想,有了足够多的长颈鹿和大象的例子,机器可以推断出两类动物的存在,而不需要贴上标签。在强化学习中,数据用于驱动行为,行为是否成功由“奖励”信号来评估。

人工神经网络的大部分进展是开发更好的监督学习工具。监督学习的核心考虑是“泛化”。随着参数数量的增加,网络的表达能力也随之增强,即网络能够处理输入-输出映射的复杂性。一个网络足够的自由参数可以适应任何函数,但是训练网络的数据量限制了参数的数量,使网络不会过拟合。如果一个网络有太多的自由参数,那么就有过拟合的数据风险,即它会在训练样本上生成正确的响应,但不能泛化到新样本。在ANN研究中,网络的灵活性(神经元和连接的数量)和训练网络所需的数据量之间的紧张关系被称为偏差方差权衡。

三、动物学习

神经科学和心理学中“学习”指的是经验导致的行为的持久变化。在这种情况下,学习包括动物范例,如经典条件反射和操作条件反射,以及一系列其他范例,如观察学习和指导学习。尽管神经科学和人工神经网络在术语“学习”的使用上有一些重叠,但在某些情况下这些术语的差异会导致混淆。

使用上最大的分歧是“监督学习”一词的应用。监督学习是近年来ANN在现实应用中取得许多成功的关键。例如ANN可以成功的进行图像分类。然而,为了确保泛化能力,再训练这一的网络需要庞大的数据集,一个问答系统需要百万个标记样本进行训练。虽然这种训练的结果是一个有能力的神经网络,至少在表面上可以模仿人类分类图片的能力,但是人工系统学习的过程与新生儿几乎没有相似之处。一年仅有百万秒,一个孩子需要每秒问一个问题才能得到相应数量的标记数据,而且孩子遇到的大多数图片都没有标签。因此,可用的标记数据池和儿童的学习速度不匹配。显然孩子们并不主要依靠监督算法来学习物体分类。诸如此类的思考使机器学习社区寻找更强大的学习算法,寻找能让儿童在数年内学习在世界畅行的秘密武器。ANN社区中许多人,包括Yann Lecun和Geoff Hinton这样的先驱,认为我们主要依赖非监督的范式来构建这个世界的表征。用Lecun的话说:“如果智力是一块蛋糕,那么大部分是无监督学习,蛋糕上的糖衣是监督学习,蛋糕上的樱桃是强化学习”。

由于无监督算法不需要标记数据,可能会利用我们接收到的大量原始感官数据。实际上,有几种无监督算法生成表示法让人联想到视觉系统中发现的那些表示法。虽然目前这些无监督算法不能够产生和监督算法同样有效的表示法,但也没有理论原则排除这种算法的存在。虽然No free lunch定理表明没有完全通用的学习算法存在,对于某种学习模式总有一种表现不佳的数据分布。每个学习模型都对它能学习的函数有显式或隐式的限制。因此,尽管一个孩子在生命的前百万秒所遇到的带标签图像数量很少,但这段时间接收到的感官输入总量却非常大。或许大自然已经进化出了一种强大的非监督学习算法来利用这个庞大的数据池。发现这样的无监督算法,将为下一代人工神经网络奠定基础。

四、动物的习得行为和天生行为

一个核心问题是在没有大量监督训练集的情况下,动物是如何在出生后这么短的时间内就能很好的工作的。可用确定的是这是比目前发现的任何算法都更强大的非监督学习,可能在建立感觉表征和驱动行为方面发挥了作用。但这不是全部,这个假设的算法面临的挑战比看起来大得多。人类是一个例外,我们花在学习上的时间比其他动物都多,我们有很长一段不成熟。许多动物在百万秒、十万秒甚至更短的寿命后就能有效活动:例如松鼠在出生几个月内就能从一棵树跳到另一棵树,小马能在几个小时内学会走路,蜘蛛天生就能捕食。这样的例子表明,挑战甚至超出了无监督学习的能力。

单凭无监督机制无法解释动物在出生时或出生后不久是如何有效发挥作用的。我们的感觉表征和行为驱动很大程度上是先天的。例如,许多嗅觉刺激是天生的具有吸引力或引起食欲的,如血对鲨鱼、尿对老鼠等。对视觉刺激的反应也可能是天生的,如老鼠对若隐若现的刺激物是防御性的,使它们能迅速发现并避开空中捕食者。但是先天机制的作用不仅仅建立对感觉表征的反应。大多数昆虫和短命动物的行为技能都是天生的。脊椎动物也有许多复杂的先天行为,例如求爱仪式。哺乳动物复杂的先天行为的一个显著例子是穴居:亲缘关系很近的鹿鼠在tunnel的长度和复杂度上有显著的不同。这些天生的倾向是独立于养育的:一种老鼠由另一种老鼠的养母养大,它们会像它们的亲生父母一样建造洞穴。因此,动物行为系统中很大一部分似乎不是聪明的学习算法(监督或非监督)的结果,而是与生俱来的行为程序。

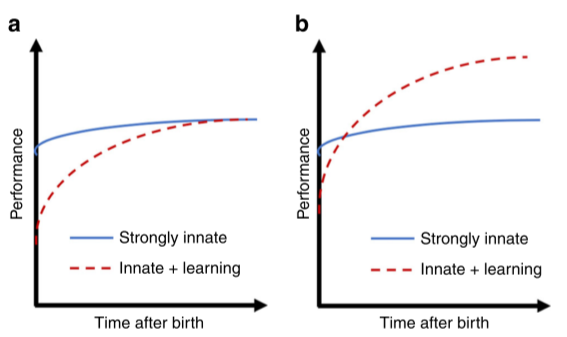

从进化的角度看,先天行为的又是显而易见。动物的生成需要它反复的解决四个f——进食、战斗、逃跑、交配。每个个体出生后,仅有非常有限的时间,从几天到几年,来找出解决这几个问题的方法。如果成功了,它会传递部分解决方案到下一代。考虑一个物种X在出生时获得了98%的成熟表现(生存和繁殖能力),它的竞争对手Y仅获得50%。假设其他条件相同,例如两个物种的成熟表现水平相同,那么物种X将超过物种Y,因为它们繁殖时间更短,且第一个月存活下来的比例更大。图2所示,先天和学习策略之间的进化权衡。在条件相同的情况下,依赖先天策略的物种将战胜采用混合策略的物种,但如果该策略可用达到更高的性能水平也能兴旺。

通过纯粹先天机制获得的成熟表现可能与通过额外学习获得的表现不同。如果一个环境快速变化,先天的行为策略可能无法像部分依赖学习的混合策略那样提供一个达到高水平成熟表现的途径。例如,以水果为生的动物可能进化出寻找树木的倾向,但个体必须学会果园在特定环境中的位置。这种固有行为策略和习得行为策略之间有一种适当的权衡,让人联想到监督学习中的偏差-方差权衡。

(这里应该更倾向于机器本身具有一套通用知识,但这里的通用也是对照于某一类机器人,类似动物种群的差异,这套通用知识中有对环境的基本交互能力、基本评价能力、学习能力等,再通过具体环境实践获取后天知识,而这里的实践获取主要是无监督学习和增强学习,配以少量监督学习。)

五、先天行为和后天行为是协同的

先天行为和后天行为的界限不明显。两种行为和表现互相作用,通常是协同的。例如,啮齿类动物和其他动物在海马体中形成一个空间表征——认知地图。这种表征是由位置细胞组成的,当动物进入它所处环境的一个特定位置时,这些细胞就会变得活跃起来。在特定环境中,一个位置细胞通常只有一个或几个位置区域place field。形成位置区域的倾向是天生的:当幼鼠第一次探索巢穴外的开放环境时,空间地图就出现了。然而,位置区域的内容是学到的。每到达一个新的环境,一个新的位置区域就会形成。因此,认知地图的框架是天生的,但是在这个框架上构建特定的地图是后天习得的。

这种天生和学习之间的协同作用是很常见的。例如,婴儿在出生后不久就能辨别面孔,而没有接触过面孔的猴子在第一次接触面孔时就表现出对面孔的偏好,这反映了先天机制对于脸部突出性和感知的贡献。在人类和灵长类动物中,存在一个皮质区——纺锤状脸区FFA,它选择性的参与面部感知。FFA部分缺失患者在面部处理方面存在永久性缺陷。然而,识别特定的面孔是在一生中习得的,就像海马体中的定位细胞一样,处理面部的先天回路可能提供了框架,特定面孔依赖于这个框架后天学到。类似的协同作用可能会加速儿童对语言的学习:像布罗卡氏区(即运动性言语中枢。 布罗卡氏区的发现,不但使人相信神经系统内的机能各有其较特殊的定位,而且还找到了以脑沟回作为脑的机能分区的明确标志。)这样的先天回路可能提供了框架,任何一种特定语言的语法和词汇都能快速习得。这种协同作用可能来自于进化压力。

(婴儿的学习过程,先天可以聚类、提取特征,后天学习关联关系、类别名称)

六、基因组规定了大脑连接规则

上文提到动物在出生后这么快能正常运转的主要原因是它们严重依赖先天机制,而不是无监督学习算法。这些天生机制被编码在基因组中,具体说,基因组编码了连接神经系统的蓝图,通过连接我们知道了哪些神经元连接在一起以及连接强度。这些蓝图是数亿年的进化选择出来的,在无数个体上运作,指定回路为先天行为和学习机制提供框架。

(一个基本的网络结构以及连接权重,可以完成一些基本行为和学习行为,根据后天改变结构本身或创造新的网络)

如果秘密武器在我们的基因组中,那么基因组到底指定了哪些连接。在一些简单的生物体中,基因组有能力详细说明每个神经元之间每一条连接,精确到最细微的细节。例如,最简单的线虫有302个神经元和7000个突触,在一个自交系的每个个体中,连接方式大体相同。因此在一种极端情况下,基因组可以编码一个查找表,通过发育过程将其转换成一个精确定型连接的回路。

但在较大的大脑中,如哺乳动物的大脑,突触连接不能如此精确地指定,基因组没有足够的能力明确指定每个连接。人类基因组有3*10^9个核苷酸,最多只能编码1GB的信息,即1小时的视频流。但人类大脑有10^11个神经元,每个神经元有超过10^3个突触。指定一个连接目标需要log21011约为37bits/突触,这大概需要3.7×1015bits来指定1014个连接。(这可能低估了,因为只考虑了是否存在连接,还需要一些额外的bit/突触来指定连接强度。但是由于突触噪音或其他原因,突触强度无法非常精确的指定。因此在大而稀疏连接的大脑中,大多数信息可能用来指定连接矩阵的非零元素的位置,而不是精确值。)因此,即使人类基因组的每个核苷酸都被用来指定大脑连接,信息容量至少缺6个数量级。

这解释了为什么在大多数大脑中,基因组不能指定明确的接线图,而必须在发育的过程中指定一组连接大脑的规则。即使是一套很短的规则也可以容易地指定大量神经元链接。在极限情况下,一个像网格一样连接起来的神经系统只需要一个规则,即每个神经元连接到它最近的四个邻居。另一个简单规则是,给定游戏规则找出尽可能玩的好的网络。在实践中,动物大脑中的回路常常依赖于重复的模块。人们一直推测,新皮层是由很多个基本“规范”微回路拷贝组成的,这些微回路连接在一起形成了大脑皮层。

七、监督学习还是监督进化

如上所述,“学习”一次在ANN和神经科学上由不同的用法。在最抽象的层次上,学习可以定义为将来自外部世界的统计规律编码到网络参数的过程。但在动物学习的语境中,用于学习的输入数据的来源仅限于动物的经验,即动物一生中发生的事件。那些不依赖于经验,而是由基因组编码的连接规则,如那些用于连接视网膜的规则,通常不被称为学习。“终生”和“经验”两个术语在ANN的应用中没有很好的定义,调和ANN和神经科学领域中对“学习”的定义是一个挑战。

如果动物的大部分行为是天生的,那么动物的生活经历只代表了有助于其适应性的一小部分数据,另一个潜在的更大的数据池有助于其天生的行为和表现,这些是通过自然选择产生的。因此,与学习一样,进化也可以看作是一种提取统计学习规律的机制,尽管它的时间长度比学习要长的多。进化可以被认为是一种强化算法,在世代的时间尺度上运行,强化信号由个体产生的子代数量组成。ANN的优化过程必须模拟进化过程和终生学习过程中学习到的东西,而对动物来说,学习只涉及生命周期中的变化。

在这种观点下,ANN的监督学习不应该被视为模仿动物学习。由于大多数有助于动物适应环境的数据都是通过进化编码到基因组的,或许将其命名为“监督进化”。这种命名强调在ANN中,“监督学习”实际上是对动物在进化或学习过程中出现的统计规律的抽取。在动物中有两套嵌套优化过程:一个外部的“进化”循环作用于generation的时间尺度,一个内部的“学习”循环作用于个体的一生。监督进化可能比自然进化快得多,自然进化成功之处在于它受益于数亿年来千万亿个体的生活经验所代表的海量数据。

虽然学习和进化有相似之处,但也有重要区别。学习可以通过Hebbian和其他机制直接作用于突触的权重,但进化只能通过基因组间接作用于大脑连接。基因组不直接编码表现或行为,而是编码连接规则和连接motif(基序?)。哺乳动物基因组的能力有限,比明确指定所有连接少几个数量级,可能起到正则化或信息瓶颈制约的作用,改变方差到偏差的平衡。基因组本身的大小并不是一个固定的限制,在不同物种之间的差异很大。人类基因组的大小在哺乳动物中处于平均水平,但与鱼类和两栖动物相比显得微不足道。肺鱼的基因组比人类大40倍。人类的基因组本可能会更大,这说明基因的有限能力带来的调节效应可能代表了一种特性而不是缺陷。

(到底是基因中还是存在一个网络有学习能力对ANN或许并不重要,重要的是这套基础机制,它可以给网络一个最佳初始结构和初始参数,完成个体与环境的基本交互,然后在交互过程中启动学习机制,不断完善网络。对于动物来讲,这个最佳初始和学习机制就是在进化中得到的。)

八、对神经网络的启示

文章认为动物之所以在出生后这么短的时间内就能很好工作,是因为它们天生就有高度结构化的大脑连接。这种连接为快速学习提供了一个基础,使先天机制和学习过程协同工作。类似的方法可能会激发加速ANN发展的新方法。

神经科学的第一个发现是动物的很多行为是天生的,而不是后天习得的。动物的大脑并不像一些AI研究员所设想的那样,是一块配备了通用学习算法的白板,随时准备学习东西。动物有很强的选择压力限制了它们的学习,只学那些生存所需要的。动物倾向于快速学习某些东西的观点与AI和认知科学中“元学习”和“归纳偏见”有关。在此构想下,有一个外部循环(如进化),它优化了学习机制,使之有归纳偏差,使我们能够学习非常具体的东西。

(自然选择本身可能是一个强化学习,目标是让动物明确学习目标,集中注意力。对应到AI中,机器并不知道目标是什么,设立一个目标让他主动寻找目标和输入)

先天机制的重要性表明,ANN在解决新问题时应该尽可能多的尝试建立在先前相关问题的解决方案上。这一想法与ANN一个活跃领域有关,即迁移学习。在迁移学习中,对某一任务进行与训练的连接迁移到相关任务上以加速学习。例如,一个被训练进行物体分类的网络,比如大象和长颈鹿,可能被用作区分树木和汽车的网络的起点。然而,迁移学习在很大程度上不同于大脑使用的先天机制。在迁移学习中,神经网络的整个连接矩阵或一个重要部分作为一个起点,而在动物大脑中,代代迁移的信息量更小,因为它必须通过基因组的瓶颈限制。通过基因组瓶颈传递信息可以选择更通用更泛化的连接和可塑性规则。例如,视觉皮层和听觉皮层的连接非常相似。这表明,典型的皮质回路为哺乳动物执行各种各样的任务提供了基础。神经科学表明,可能存在更强大的机制,一种广义的迁移学习机制,它不仅在单一的感觉形态(如视觉)中运作,而且运行在多种感觉形态之间。

(这或许为多种不相关任务的网络结构压缩提供了思路,浅一级是用同一初始网络解决相关任务,更深层是不相干任务的联系,例如视觉、听觉和行为网络的交叉)

神经科学的另一发现是基因组并不直接编码表现或行为,也不直接编码优化原则。基因组编码连接的规则和模式,然后实例化行为和表示。这些连接规则就是进化的目标。对ANN网络的结构就是优化目标。经典的ANN在很大程度上忽略了网络结构的细节,可能是由普遍的三层全连接网络的理论结果所引导的。卷积神经网络是ANN在现代的主要进步之一,它用高度受限连接对接视觉世界的平移不变性。也许还有许多东西有待发现。在神经网络中,有时还通过超参数对连接和学习规则施加其他约束,对于超参数的优化有大量的文献。然而,目前ANN只利用了一小部分可能的网络架构,更强大的受皮质层启发的架构有待发现。

原则上,神经处理背后的回路可以被实验神经科学发现。传统上神经表征和连接是通过活动记录间接推断出来的。最近人们开发了而一些工具可以确定可以直接确定回路和wiring motif。局部回路可以用连续电子显微镜确定,目前有项目向确定老鼠视觉皮层1立方毫米内每个突触。可以用MAPseq或其他方法通过高通量的方式实现长期预测。因此皮质层连接的细节可能很快会得到,为神经网络提供实验基础。

结论

大脑为AI提供灵感的思路是AI研究的基础。神经网络代表了一种尝试,试图捕捉神经系统的一些关键方面:很多简单单元,突触连接,并行操作。例如强化学习算法为AlphaGo Zero等成功案例提供了基础,它们的灵感来源于对动物学习的研究。CNN受到神经皮质结构的启发。

但AI的进一步发展似乎否受益于动物大脑的研究仍存在争议。也许我们已经从动物的大脑中学到了我们需要的东西,正如飞机和鸟类有很大的不同,只能机器的操作原理与生物有机体可能非常不同。作者认为这是不对的,因为我们对智能机器(有时被误导为人工通用智能)的要求是不寻常的,它与人类的能力匹配非常紧密,只有结构类似于大脑的机器才能实现。从某些方面来说,飞机比鸟好得多,可以更快更高更远,运载能力也大得多。但飞机不能入水抓鱼,不能从树上俯冲抓老鼠。通用,现代计算机在某些方面已经超过了人类的计算能力,但无法在定义为通用通用智能的特定任务集上与人类匹敌。如果我们想涉及一个系统做人类能做的事,我们需要根据相同的设计原则构建它。

参考资料: