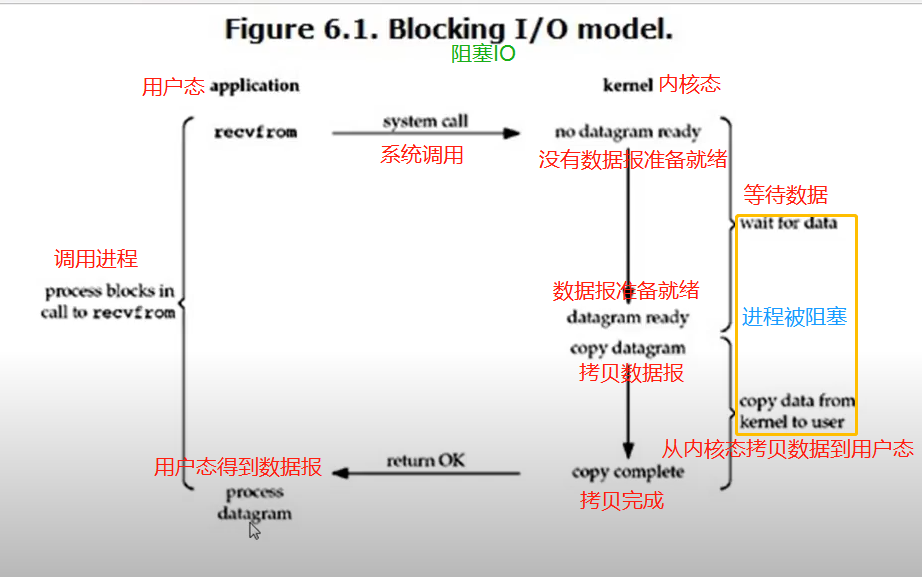

阻塞IO

在linux中,默认情况下所有的socket都是blocking

当用户进程调用了recvfrom这个系统调用,kernel就开始了IO的第一个阶段:准备数据。对于network io来说,很多时候数据在一开始还没有到达(比如,还没有收到一个完整的UDP包),这个时候kernel就要等待足够的数据到来。而在用户进程这边,整个进程会被阻塞。当kernel一直等到数据准备好了,它就会将数据从kernel中拷贝到用户内存,然后kernel返回结果,用户进程才解除block的状态,重新运行起来。

所以,blocking IO的特点就是在IO执行的两个阶段都被block了。

非阻塞IO

linux下,可以通过设置socket使其变为non-blocking。

从图中可以看出,当用户进程发出read操作时,如果kernel中的数据还没有准备好,那么它并不会block用户进程,而是立刻返回一个error。从用户进程角度讲 ,它发起一个read操作后,并不需要等待,而是马上就得到了一个结果。用户进程判断结果是一个error时,它就知道数据还没有准备好,于是它可以再次发送read操作。一旦kernel中的数据准备好了,并且又再次收到了用户进程的system call,那么它马上就将数据拷贝到了用户内存,然后返回。

所以,用户进程其实是需要不断的主动询问kernel数据好了没有。

注意:

在网络IO时候,非阻塞IO也会进行recvform系统调用,检查数据是否准备好,与阻塞IO不一样,”非阻塞将大的整片时间的阻塞分成N多的小的阻塞, 所以进程不断地有机会 ‘被’ CPU光顾”。即每次recvform系统调用之间,cpu的权限还在进程手中,这段时间是可以做其他事情的,

也就是说非阻塞的recvform系统调用调用之后,进程并没有被阻塞,内核马上返回给进程,如果数据还没准备好,此时会返回一个error。进程在返回之后,可以干点别的事情,然后再发起recvform系统调用。重复上面的过程,循环往复的进行recvform系统调用。这个过程通常被称之为轮询。轮询检查内核数据,直到数据准备好,再拷贝数据到进程,进行数据处理。需要注意,拷贝数据整个过程,进程仍然是属于阻塞的状态。

'''

阻塞IO:比如tcp的accept和connect,服务端accept会一直处于阻塞状态等待客户端的connect,及recv没有收到send的消息而阻塞

非阻塞IO:socket模块下的一个setblocking(flag)方法可以设置accept的阻塞和非阻塞,当flag为True时是阻塞状态,为False时是非阻塞状态

非阻塞IO缺点:发了太多的系统调用;因为轮询的关系没有及时响应处理客户端的链接

'''

from socket import *

import time

'''非阻塞IO'''

server = socket(AF_INET, SOCK_STREAM)

server.setsockopt(SOL_SOCKET, SO_REUSEADDR, 1)

server.bind(('127.0.0.1', 8080))

server.listen(5)

server.setblocking(False) # 参数为False,accept()是非阻塞状态

print('waiting client connection...')

while True:

try:

conn, addr = server.accept() # 进程主动轮询,accept()为非阻塞状态,那么无连接请求时必报错,所以得放在try代码块下,如果没有循环运行完一次捕捉到异常即退出

print('成功链接的客户端地址:', addr)

data = conn.recv(1024)

if not data:

continue

print('客户端发来的消息:', data.decode('utf-8'))

conn.sendall(data.upper())

# conn.close()

except Exception as e:

print(e)

time.sleep(5)

********client端,现在支持多个客户端连接且能持续与服务端交互

from socket import *

import time

'''非阻塞IO'''

while True:

client = socket(AF_INET, SOCK_STREAM)

client.connect(('127.0.0.1', 8080))

client.sendall('客户端one'.encode('utf-8'))

data = client.recv(1024)

print('服务端回复的消息是:', data.decode('utf-8'))

# break

client.close()

time.sleep(5)

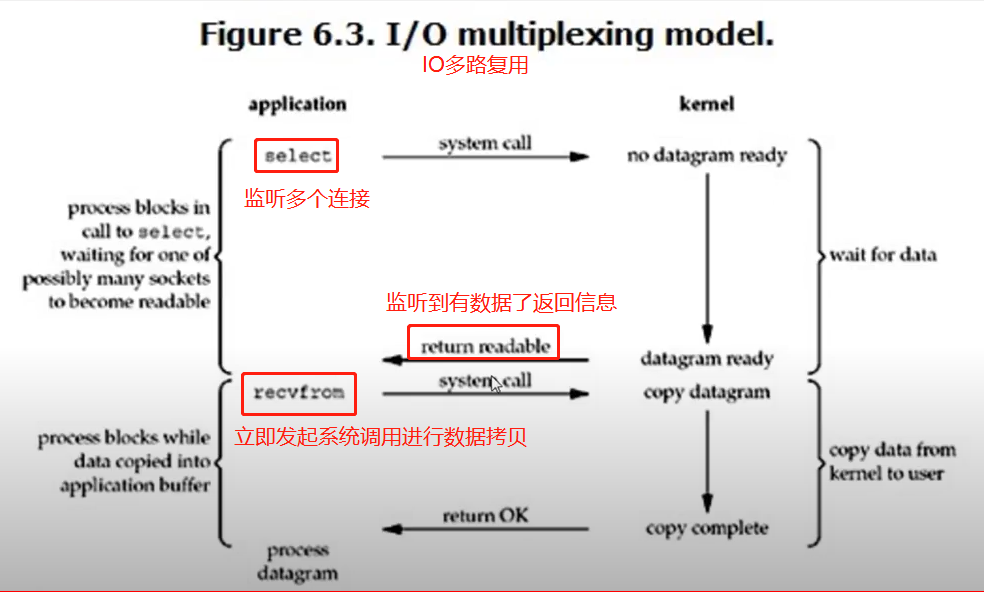

IO多路复用

IO multiplexing这个词可能有点陌生,但是如果我说select,epoll,大概就都能明白了。有些地方也称这种IO方式为event driven IO。我们都知道,select/epoll的好处就在于单个process就可以同时处理多个网络连接的IO。它的基本原理就是select/epoll这个function会不断的轮询所负责的所有socket,当某个socket有数据到达了,就通知用户进程。

当用户进程调用了select,那么整个进程会被block,而同时,kernel会“监视”所有select负责的socket,当任何一个socket中的数据准备好了,select就会返回。这个时候用户进程再调用read操作,将数据从kernel拷贝到用户进程。

这个图和blocking IO的图其实并没有太大的不同,事实上,还更差一些。因为这里需要使用两个system call (select 和 recvfrom),而blocking IO只调用了一个system call (recvfrom)。但是,用select的优势在于它可以同时处理多个connection。(多说一句。所以,如果处理的连接数不是很高的话,使用select/epoll的web server不一定比使用multi-threading + blocking IO的web server性能更好,可能延迟还更大。select/epoll的优势并不是对于单个连接能处理得更快,而是在于能处理更多的连接。)

在IO multiplexing Model中,实际中,对于每一个socket,一般都设置成为non-blocking,但是,如上图所示,整个用户的process其实是一直被block的。只不过process是被select这个函数block,而不是被socket IO给block。

注意1:select函数返回结果中如果有文件可读了,那么进程就可以通过调用accept()或recv()来让kernel将位于内核中准备到的数据copy到用户区。

注意2: select的优势在于可以处理多个连接,不适用于单个连接