稀疏矩阵

在矩阵中,若数值为0的元素数目远远多于非0元素的数目,并且非0元素分布没有规律时,则称该矩阵为稀疏矩阵;与之相反,若非0元素数目占大多数时,则称该矩阵为稠密矩阵。定义非零元素的总数比上矩阵所有元素的总数为矩阵的稠密度。

就是很稀疏,像程序员的头发[尴尬]

稀疏编码

- 稀疏编码(Sparse Coding)也是一种受哺乳动物视觉系统中简单细胞感受 野而启发的模型.

- 稀疏编码(sparse coding) (Olshausen and Field, 1996) 是一个线性因子模型, 也是一种概率模型,已作为一种无监督特征学习和特征提取机制得到了广泛研究。

- 严格来说,术语 “稀疏 编码’’ 是指在该模型中推断 h 值的过程,而 ‘‘稀疏建模’’ 是指设计和学习模型的过 程,但是通常这两个概念都可以用术语 “稀疏编码’’ 描述。

- 通常将受 限玻尔兹曼机称为无向模型,而稀疏编码则被称为有向模型。

自编码器 [Bengio et al., 2007]

Bengio Y, Lamblin P, Popovici D, et al., 2007. Greedy layer-wise training of deep networks[C]// Advances in neural information processing systems. 153-160.

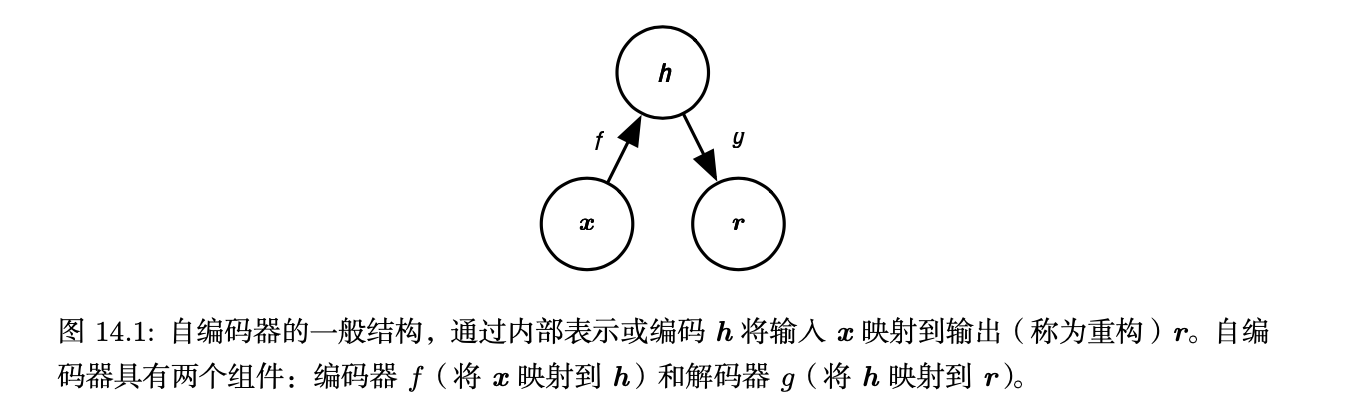

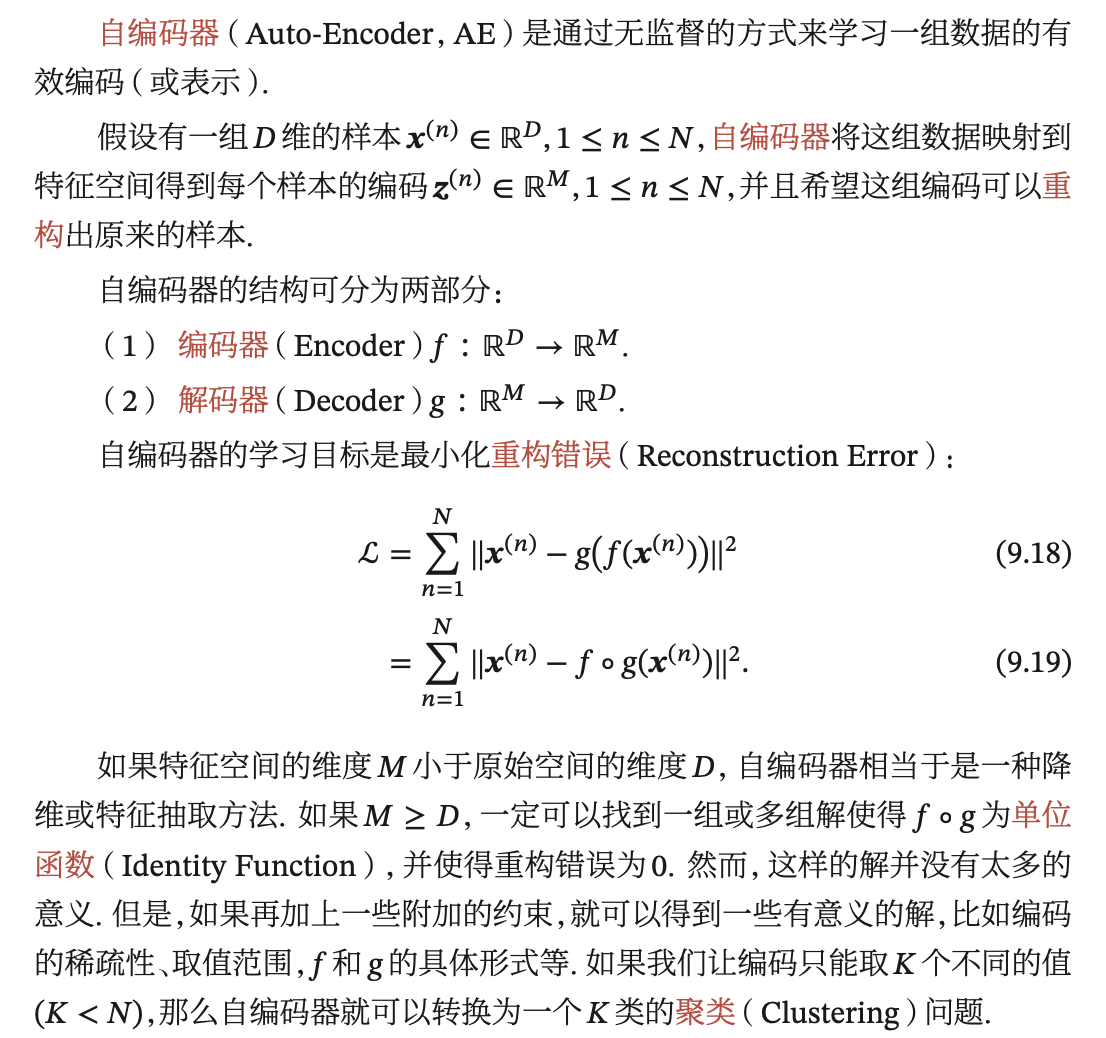

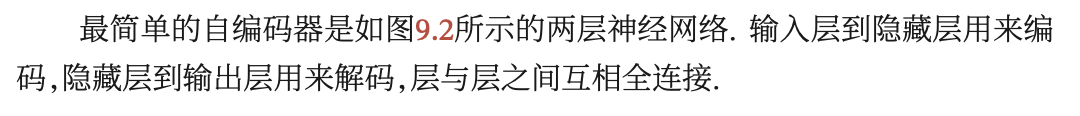

- 自编码器由一个 编码器 (encoder)函数和一个 解码器(decoder)函数组合而成。

- 自编码器(autoencoder)是神经网络的一种,经过训练后能尝试将输入复制到 输出。

- 自编码器(autoencoder)内部有一个隐藏层 h,可以产生 编码(code)表示 输入。

- 该网络可以看作由两部分组成:一个由函数 h = f(x) 表示的编码器和一个生 成重构的解码器 r = g(h)。

- 输入的模式和输出的模式在同一空间,这种模型叫作自联想模型

- 自联想模型可以通过前馈神经网络或者循环神经网络来实 现,也常称为自编码器(Auto-Encoder,AE)

稀疏自编码器 [Ranzato et al., 2006]

Ranzato M, Poultney C, Chopra S, et al., 2006. Efficient learning of sparse representations with an energy-based model[C]//Proceedings of the 19th International Conference on Neural Informa- tion Processing Systems. MIT Press: 1137-1144.

- 可以认为整个稀疏自编码器框架是对带有潜变量的生成模型的近似最大似 然训练,而不将稀疏惩罚视为复制任务的正则化。

- 稀疏自编码器一般用来学习特征,以便用于像分类这样的任务。

去噪自编码器 [Vincent et al., 2008]

Vincent P, Larochelle H, Bengio Y, et al., 2008. Extracting and composing robust features with denoising autoencoders[C]//Proceedings of the International Conference on Machine Learning. 1096-1103.

- 是一种无监督方法

- 用于领域自适应的情感分析

变分自编码器(Variational AutoEncoder,VAE)[Kingma et al., 2014]

Kingma D P, Welling M, 2014. Auto-encoding variational bayes[C/OL]//Proceedings of 2nd Inter- national Conference on Learning Representations. http://arxiv.org/abs/1312.6114.

- 有向图模型

- 使用学好的近似推断,可以纯粹地使用基于梯度的方法进行训练

- 其思想是利用神经网络来分别建模两个复杂的条件概率密度 函数.

- 一个优秀 的流形学习算法