清源

清华大学+智源研究院

悟道1.0在今年3月发布,有文源、文汇、文澜、文溯共4个方向。

文源:超大规模中文预训练模型

文汇:认知

文澜:多模态

文溯:蛋白质序列

“文源”(以中文为核心的超大规模预训练语言模型)、

“文汇”(面向认知的超大规模新型预训练模型)、

“文澜”(超大规模多模态预训练模型)、

“文溯”(超大规模蛋白质序列预训练模型)

悟道2.0在今年6月发布,没有细分这几个方向,走向了多模态融合。

https://wudaoai.cn/home

和文本生成相关的,目前有以下3个

GLM系列

https://wudaoai.cn/model/detail/GLM系列

GLM (General Language Model) 是一个全新的预训练框架,打破BERT和GPT的瓶颈。单一GLM模型在语言理解和生成任务方面取得了最佳结果,并且超过了对相同数据量进行训练的常见预训练模型(例如BERT,RoBERTa和T5)

适用于:文本摘要生成、长文本生成等

不支持中文

CPM系列

https://wudaoai.cn/model/detail/CPM系列

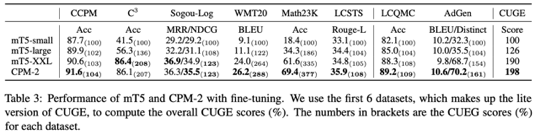

2020年11月,CPM系列正式发布,并推出当时参数最大的26亿中文预训练语言模型CPM-1(Chinese Pretrained Models),可支持简单对话、文章生成和语言理解等下游任务。2021年6月,CPM-2(Cost-effective Pre-trained language Models)在北京智源大会上发布,推出了110亿的中英双语语言模型和对应的1980亿MoE(Mixture-of-Experts)版模型。2021年9月,“悟道”推出了模型推理工具包BMInf,可以实现“一卡顶四卡”的高效推理。配合BMInf,采用模型量化技术,推出高效生成模型CPM1(INT8)、高效对话模型EVA1.5(INT8)、高效通用模型CPM2(INT8)及其生成强化版CPM2.1(INT8),可同时提供较强的文本补全与生成能力。

适用于:文本生成、摘要生成

支持中文

文源

使用模型,需要提交申请单

https://wudaoai.cn/model/download?resourceId=1420992356135514112&filename=CPM-2-11B-zh-en.tar

19G

模型文件名 32000.tar,是中英文双语模型,110亿参数

代码:https://github.com/BAAI-WuDao/CPM

Transformer-XL

https://wudaoai.cn/model/detail/Transformer-XL

Transformers具有长期学习依赖的潜力,但在语言建模设置中受到固定长度上下文的限制。而Transformer-XL作为一种新神经网络架构可以很好地解决长文本依赖问题。悟道基于Transformer-XL训练并开放29亿的语言模型,在长文本生成方面具有优势。

适用于:新闻生成、智能协作、评论生成等

支持中文

模型文件大小5.3G

Transformer-XL 文汇

依赖nltk,支持中文

模型文件需要提出申请,人工审核。

模型文件,

http://dorc-model-team.ks3-cn-beijing.ksyun.com/ren-zhi/my-model/mp_rank_00_model_states.pt

5.3G

代码:https://github.com/BAAI-WuDao/Chinese-Transformer-XL

已试,可进行文本生成