BigBird:用于更长序列的 Transformer

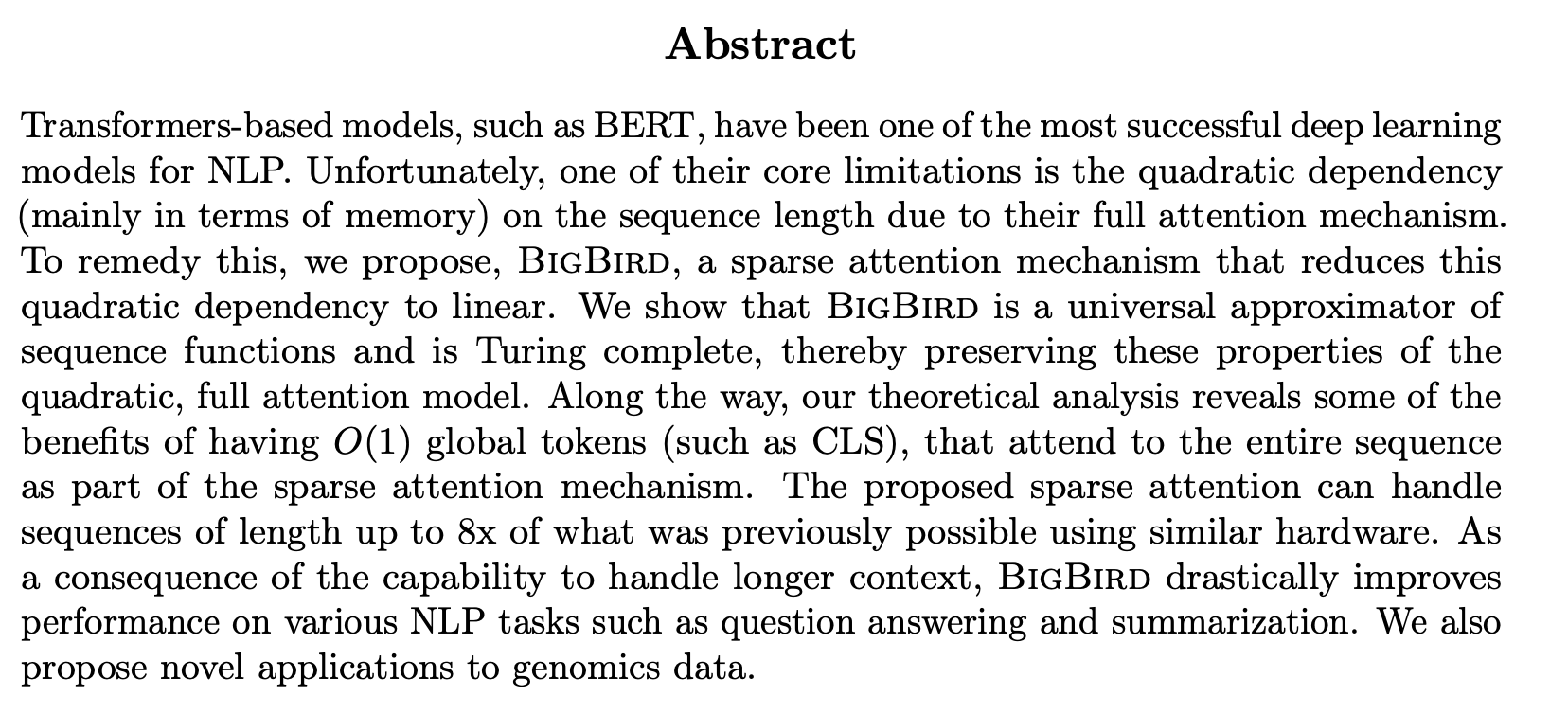

Big Bird: Transformers for Longer Sequences

Zaheer, M., Guruganesh, G., Dubey, A., Ainslie, J., Alberti, C., Ontanon, S., Pham, P., Ravula, A., Wang, Q., Yang, L., & Ahmed, A. (2020). Big Bird: Transformers for Longer Sequences. 1–51. http://arxiv.org/abs/2007.14062

BERT的主要缺点是全注意力机制的二次方依赖,本文提出BigBird,一个稀疏注意力机制,将依赖降低为线性。我们证明了BigBird是序列函数的通用逼近器,且图灵完备。8倍512

可提高问答和摘要任务的性能。

BigBird 运行在稀疏注意力机制上,克服 BERT 的二次依赖性,同时又保持了完全注意力模型的属性。(突破全注意力机制的局限)

BigBird 的主要亮点:

- 稀疏注意力机制

- 可以处理多达 8 倍长的输入序列

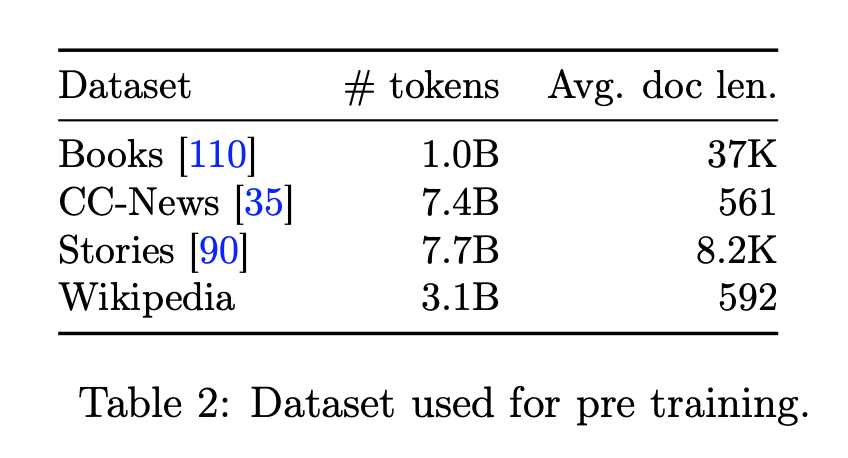

- 针对大数据集进行预训练

可能的应用领域:

- 基因组学处理

- 长文档摘要与问答系统

- 用于搜索

- Web 和移动应用程序开发

可以完成的任务:

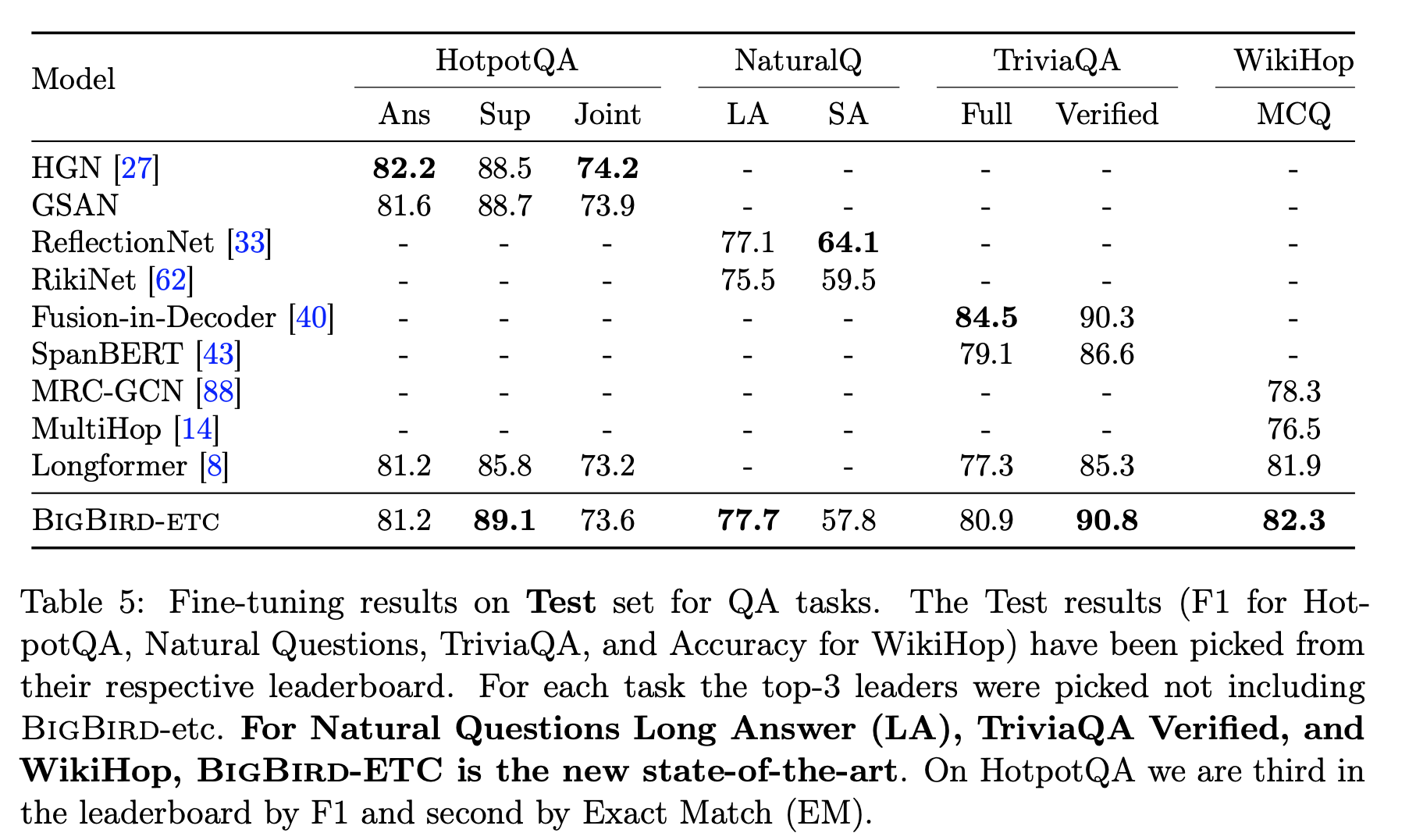

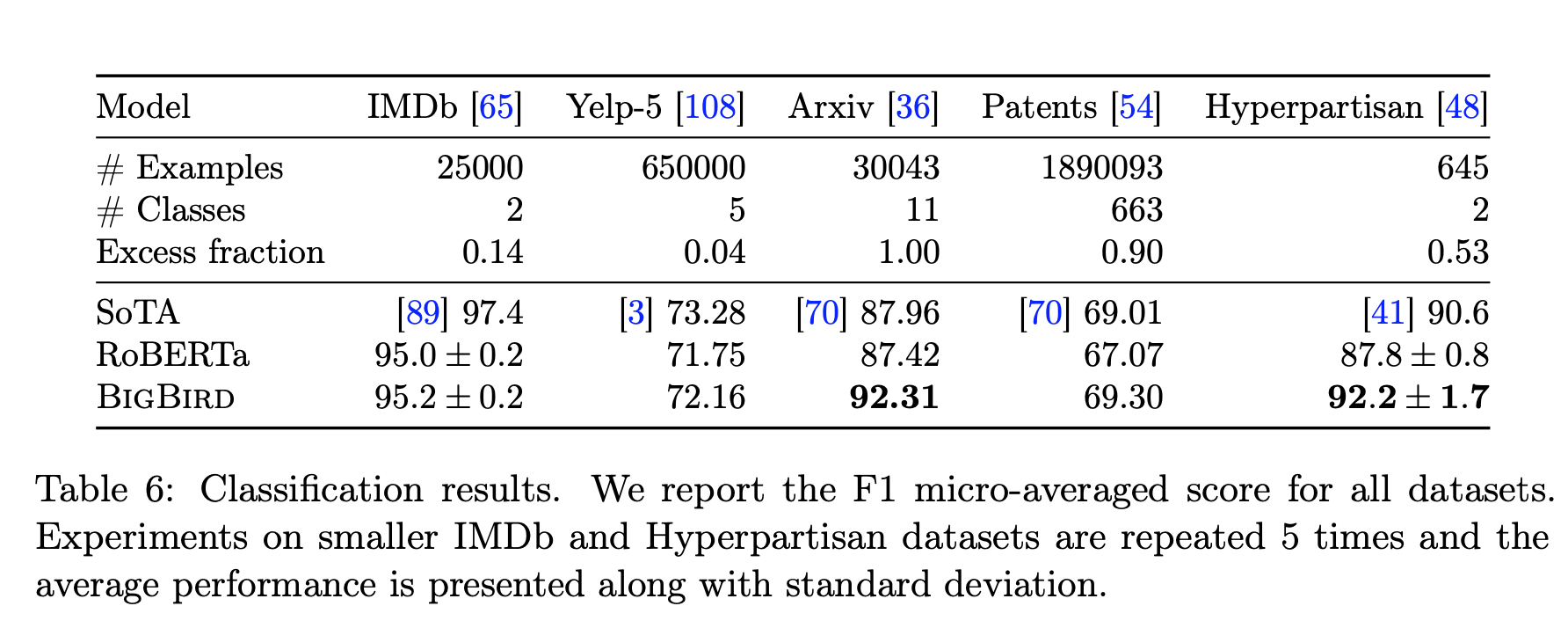

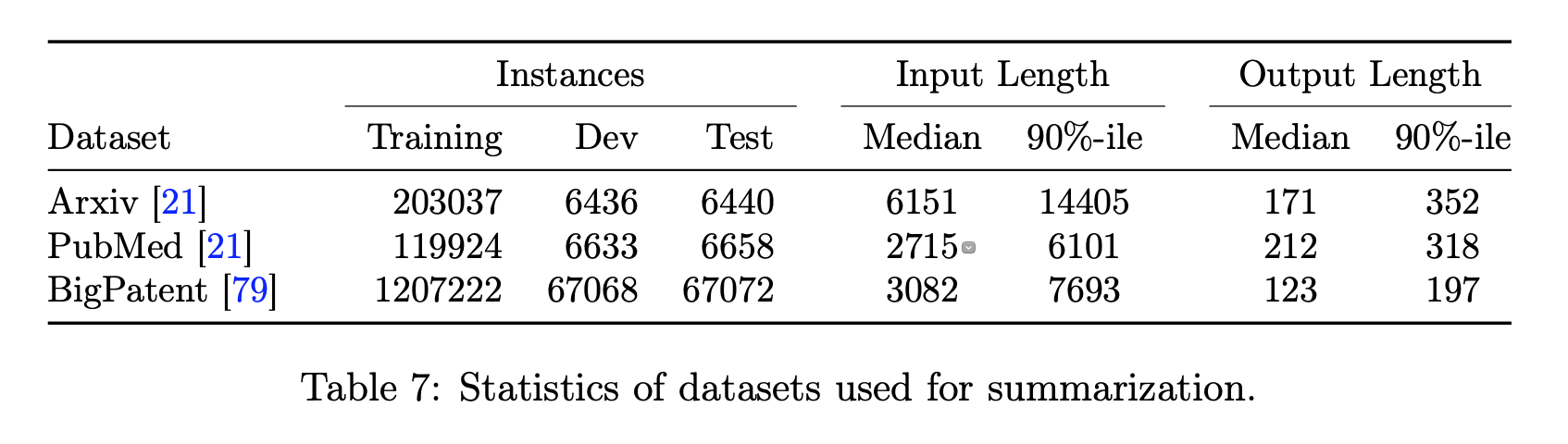

分类(长文本)、问答、摘要、基因语言模型实验

未见代码

参考:

- https://mp.weixin.qq.com/s/qAfKvbBUSaiqPThGTyTl3Q

- https://mp.weixin.qq.com/s/MPGF3tkNn3PBA_7S-fo9eg

- https://blog.csdn.net/mengzhengnan/article/details/108689270

- https://zhuanlan.zhihu.com/p/64114978

- https://zhuanlan.zhihu.com/p/165509102

- https://zhuanlan.zhihu.com/p/215847627

- https://zhuanlan.zhihu.com/p/256119575

- https://arxiv.org/abs/2007.14062