在编写爬虫代码的过程中,程序员会使用redis 集合进行去重,今天就测试一下redis去重需要多少内存的问题

过程:我们对10w,100w,1000w 的数字进行 md5 加密,生成唯一的32位字符串,然后存入到redis集合中去,通过rdm 的 内存分析占用查看redis的大小。

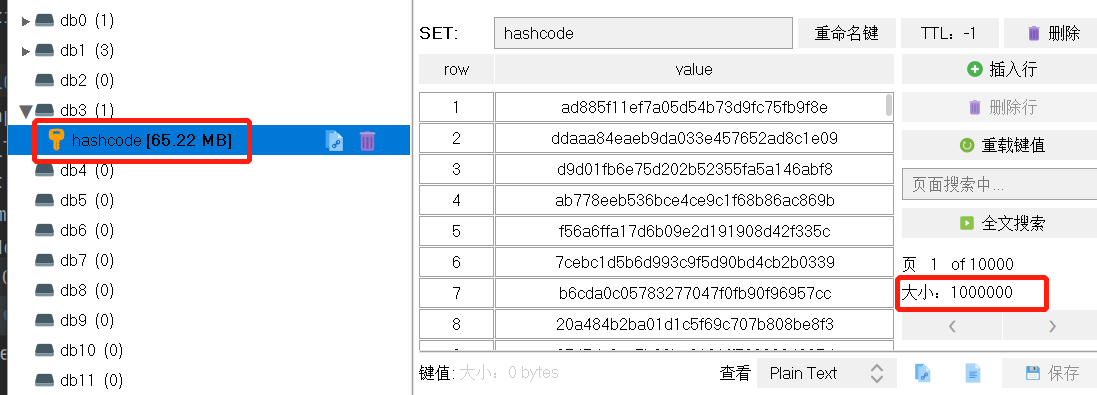

1. 对10w 数据去查,查看大小

2. 对100w 数据去查,查看大小

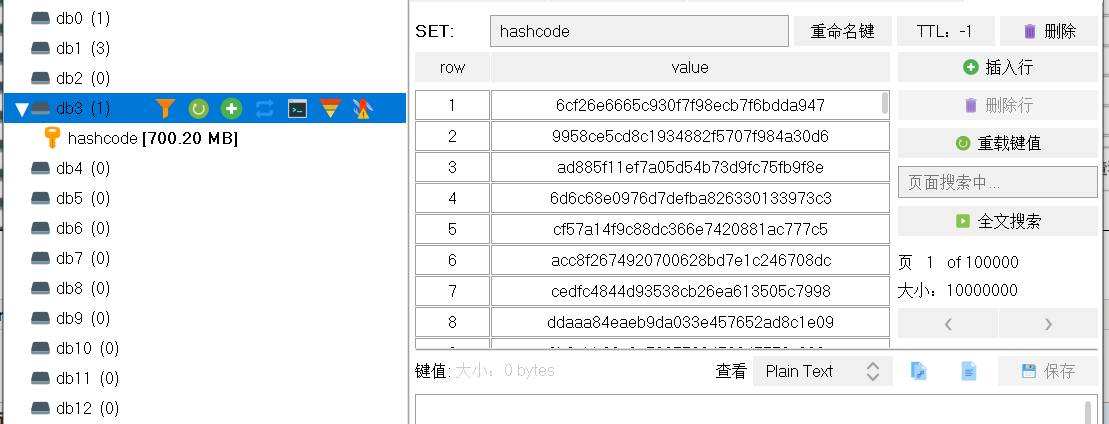

3. 对1000w 数据去查,查看大小

4. 对 2000w 数据去查,查看大小

总结:

绘制一个图表展示一下吧

当需要去重的数据量达到1亿的时候,需要的内存是7GB左右,如果要是有50亿条数据,redis去重还是一个好的解决方案吗?

最后对自己想说的是:百想不如一测