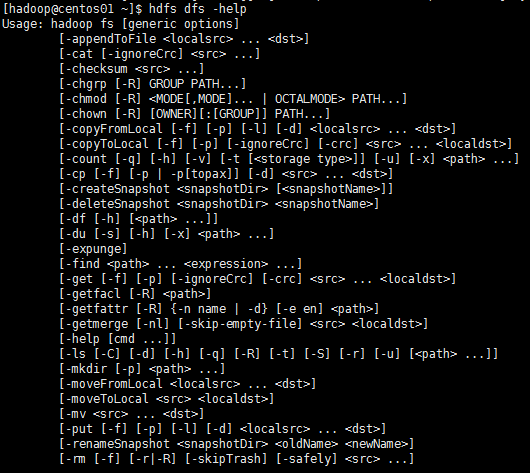

1、列出所有命令

hdfs dfs -help

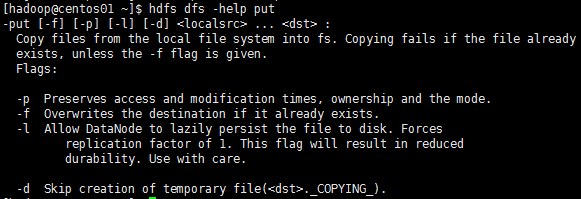

2、查看某个一个命令的详细

hdfs dfs -help -put

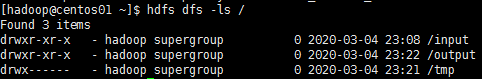

3、ls 查看HDFS系统中文件和目录,例如查看根目录

hdfs dfs -ls /

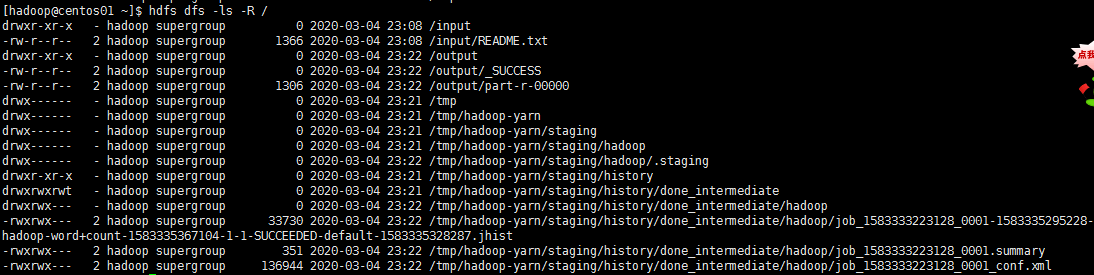

列出所有目录和文件

hdfs dfs -ls -R /

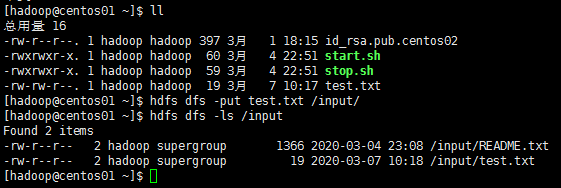

4、put 将本地文件上传道HDFS系统中

hdfs dfs -put test.txt /input/

5、moveFromLocal 命令将本地文件移动到HDFS系统中,可以移动多个文件,与put命令类似,不同的是移动后删除本地文件

hdfs dfs -moveFromLocal test.txt /iput/

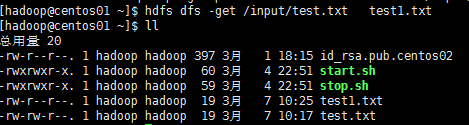

6、get 命令将HDFS系统中的文件下载到本地,下载时本地不能有同名文件,否则会提示文件已存在(确保本地存在写入权限)

hdfs dfs -get /input/test.txt test1.txt

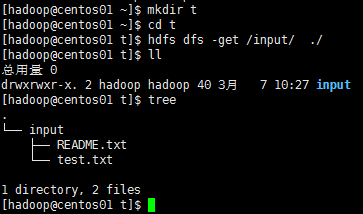

下载整个目录

hdfs dfs -get /input/ ./

7、rm 删除HDFS系统的文件或者文件夹

删除指定文件 hdfs dfs -rm /input/test.txt 递归删除input目录以及改目录下全部内容 hdfs dfs -rm -r /input

8、mkdir 在HDFS系统中创建文件夹

hdfs dfs -mkdir /input/ 创建多级目录(自动创建父级不存在的目录) hdfs dfs -mkdir -P /input/test

9、cp 复制文件(备份文件)

hdfs dfs -cp /input/test.txt /input/1.txt

10、move 移动文件(重命名)

hdfs dfs -move /input/test.txt /input/1.txt

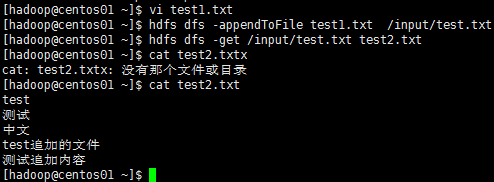

11、appendToFile 将本地单个文件或多个文件追加到HDFS系统的文件中

hdfs dfs -appendToFile test1.txt /input/test.txt

如果需要追加多个文件,用空格隔开

hdfs dfs -appendToFile test1.txt test2.txt /input/test.txt

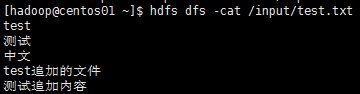

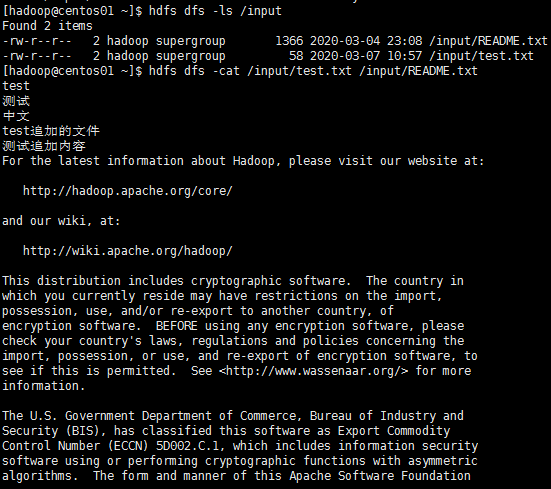

12、cat 查看HDFS系统中的所有内容

hdfs dfs -cat /input/test.txt

查看多个文件,显示的内容按顺序合并

hdfs dfs -cat /input/test.txt /input/README.txt

NameNode hadoop-daemon.sh start namenode hadoop-daemon.sh stop namenode DataNode hadoop-daemon.sh start datanode hadoop-daemon.sh stop datanode

resourcemanager

yarn-daemon.sh start resourcemanager

yarn-daemon.sh stop resourcemanager

nodemanager

yarn-daemon.sh start nodemanager

yarn-daemon.sh stop nodemanager

journalnode 集群命令 hadoop-daemon.sh start journalnode hadoop-daemon.sh stop journalnode ZKFC hadoop-daemon.sh start zkfc hadoop-daemon.sh stot zkfc zookeeper: zkServer.sh start 启动 zkServer.sh stop 停止 zkServer.sh status 查看状态 leader follwer